Documente Academic

Documente Profesional

Documente Cultură

Cadenas de Markov - Metodo Montecarlo

Încărcat de

Shirle UnamDescriere originală:

Titlu original

Drepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Cadenas de Markov - Metodo Montecarlo

Încărcat de

Shirle UnamDrepturi de autor:

Formate disponibile

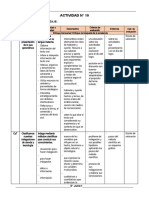

Metodos de Cadenas de Markov Montecarlo

Shirle Aragn Coaguila1,* Escuela de Ingeniera e Informtica, Universidad Nacional de Moquegua Ilo, Moquegua *shirlearagon@gmail.com

Resumen

Los procesos estocsticos son sucesiones de eventos regidos por leyes probabilsticas. Varios investigadores han estudiado las caractersticas y el comportamiento de estas sucesiones, para aplicarlos a los procesos estocsticos en fsica, ingeniera, biologa, medicina y otras disciplinas as como tambin en otras ramas de la matemtica y han establecido sus teoras y propiedades[1]. Palabras clave: procesos estocsticos, Markov, mtodo Montecarlo. mtodo

Probabilidades de transicin entre estados, en un ciclo (matriz P) Distribucin inicial del sistema entre los M estados posibles

Propiedad markoviana: Un proceso estocstico tiene la propiedad markoviana si las probabilidades de transicin en un paso slo dependen del estado del sistema en el perodo anterior (memoria limitada)[4].

I. Introduccin Las cadenas de Markov son modelos probabilsticos que se usan para predecir la evolucin y el comportamiento a corto y a largo plazo de determinados sistemas[2][3]. Ejemplos: reparto del mercado entre marcas; dinmica de las averas de mquinas para decidir poltica de mantenimiento; evolucin de una enfermedad, Una Cadena de Markov (CM) es: Un proceso estocstico Con un nmero finito de estados (M) Con probabilidades de transicin estacionarias Que tiene la propiedad markoviana

Elementos de una Cadena de Markov: Un conjunto finito de M estados, exhaustivos y mutuamente excluyentes (ejemplo: estados de la enfermedad) Ciclo de markov (paso) : periodo de tiempo que sirve de base para examinar las transiciones entre estados (ejemplo, un mes)

Tipos de modelos de Markov: Procesos de Markov (Modelos semimarkovianos): Las probabilidades de transicin entre estados pueden variar a medida que transcurren ms ciclos. Ejemplo: para modelizar la esperanza de vida, el riesgo de muerte aumenta con la edad Cadenas de Markov: Las probabilidades de transicin se suponen constantes a lo largo del tiempo. Tipos de Estado de Cadenas de Markov:

II.

Mtodo de simulacin de Montecarlo o cadenas de Markov

a.

Mtodo de Montecarlo: El mtodo de Montecarlo consiste en generar series aleatoria de eventos, n este caso condiciones hidrolgicas con las cuales se simula la operacin del SIC durante un perodo de hasta 15 aos. Cada serie cubre un perodo igual al del estudio y est compuesta por un conjunto de aos hidrolgicos elegidos al azar de la estadstica disponible de 40 aos. Para cada una de ellas se conoce el comportamiento ptimo del SIC en funcin del nivel inicial del embalse, pues este fue determinado (y almacenado en matrices > durante la etapa de optimizacin. Partiendo de una cota conocida a principios del primer ao, es posible determinar el valor que toman las siguientes variables en cada ao del estudio: cota final del lago Laja, costo de generacin, costo de falla, costos marginales trimestrales, consumo de combustible, generacin de cada central trmica, generacin de Abanico, El Toro y Antuco, energa fallada y rebases. La figura siguiente muestra grficamente el proceso de simulacin de Montecarlo: Con un numero de secuencias hidrolgicas de simulacin relativamente

elevado (entre 1000 y 2000), se obtiene la distribucin de probabilidades de cada una de estas variables en cada ano. El programa entrega el valor esperado y la desviacin estndar de todas estas variables para cada ao y la distribucin de probabilidad de cotas finales y de una cualquiera de las otras seleccionada previamente[1]. b. Mtodo de Markov: Una forma alternativa de estudiar el comportamiento de un sistema es el denominado mtodo de Cadenas de Markov. Mediante el es posible analizar el estado de un sistema que evoluciona en el tiempo y cuyo comportamiento depende de condiciones aleatorias. Como resultado se obtienen las distribuciones de probabilidad del estado del sistema en los distintos perodos considerados y, en general, distribuciones de probabilidad para variables que son funcin del estado del sistema. Las condiciones en las cuales se utiliza este mtodo son: i) En cada perodo, el estado del sistema, y las variables que son funcin de el, deben ser discretas. ii) La condicin del sistema en un perodo cualquiera depende slo del estado del sistema en un perodo anterior y de la ocurrencia de eventos durante el perodo. La actual versin del modelo utiliza el mtodo de Markov slo para estudiar el comportamiento de las cotas en el lago Laja y de los consumos de carbn. El mtodo de Markov constituye una alternativa al mtodo de simulacin de Montecarlo, por lo que ambos deberan entregar resultados idnticos[1]. Ello, sin embargo, puede no ocurrir debido a: - El mtodo de Montecarlo converge a los verdaderos valores de la distribucin de probabilidades slo si el nmero de tiradas tiende a infinito. En la medida que dicho valor no sea suficientemente grande, existirn errores en la estimacin de probabilidades y de los estadgrafos asociados. - En el mtodo de Markov existe una prdida de informacin, ya que para los efectos de clculo,

las variables continuas deben ser discretizadas, por lo cual todos los valores son asignados al centro de la clase a la cual pertenecen. Adicionalmente , la clase correspondiente al extremo superior del dominio de definicin es semiabierta e incluye todos los valores superiores a su lmite inferior. En todo caso, ambos mtodos entregaran resultados parecidos en la medida en que aumenten tanto el nmero de tiradas en el mtodo de Montecarlo como el nmero de clases de equivalencia en el mtodo de Markov[1]. El mtodo de Monte Carlo es una tcnica numrica para calcular probabilidades y otras cantidades relacionadas, utilizando secuencias de nmeros aleatorios[5]. Formalmente un clculo MC no es otra cosa que una integracin. En general, para integrales unidimensionales pueden usarse otros mtodos numricos ms optimizados. El mtdo MC es, sin Embargo muy til para integraciones multidimensionales[5][6]. Monte Carlo va cadenas de Markov: Una cadena de Markov es un modelo matemtico de sistemas estocsticos donde los estados dependen de probabilidades de transicin. El estado actual solo depende del estado anterior. El mtodo de Monte Carlo es un mtodo no determinstico o estadstico numrico usado para aproximar expresiones matemticas complejas y costosas de evaluar con exactitud[7]. Las tcnicas de Monte Carlo va cadenas de Markov permiten generar, de manera iterativa, observaciones de distribuciones multivariadas que difcilmente podran simularse utilizando mtodos directos. La idea bsica es muy simple: construir una cadena de Markov que sea fcil de simular y cuya distribucin de equilibrio corresponda a la distribucin final que nos interesa. Smith y Roberts (1993) presentan una discusin general de este tipo de mtodos[8]. III. Referencias Bibliogrficas

[1] Metodos de Cadenas de Markov Monte Carlo - Google Acadmico. [En lnea]. Disponible en: http://scholar.google.com/scholar?start=10&q =Metodos+de+Cadenas+de+Markov+Monte +Carlo&hl=es&as_sdt=0,5. [Accedido: 06ago-2013].

[2] metodo de montecarlo - Buscar con Google. [En lnea]. Disponible en: https://www.google.com.pe/#bav=on.2,or.r_q f.&fp=89feaee616532cfa&q=metodo+de+mo ntecarlo. [Accedido: 06-ago-2013]. [3] A. Moreno Daz, Modelos multivariantes para variables ordinales: Aplicaciones en estudios de calidad de servicio, phd, Facultad de Informtica (UPM), 2001. [4] bea_cadenas_marko.ppt. . [5] swp0000.dvi - cpfund10.pdf. [En lnea]. Disponible en: http://www.ugr.es/~bioestad/_private/cpfund 10.pdf. [Accedido: 06-ago-2013]. [6] R. Ruiz Crdenas, Modelagem da distribuio espao-temporal da broca do

caf (Hypothenemus hampaei Ferrari) em uma cultura da regio central colombiana., 07-jun-2013. [En lnea]. Disponible en: http://www.teses.usp.br/teses/disponiveis/11/ 11134/tde-19092003-144713/pt-br.php. [Accedido: 06-ago-2013]. [7] La_inferencia_bayesiana_en_la_admini straci_n_de_riesgos.pdf. [En lnea]. Disponible en: http://sistemas.fciencias.unam.mx/~cvrc/files/ La_inferencia_bayesiana_en_la_administraci _n_de_riesgos.pdf. [Accedido: 06-ago-2013]. [8] Inicio - Dropbox. [En lnea]. Disponible en: https://www.dropbox.com/home. [Accedido: 06-ago-2013].

S-ar putea să vă placă și

- Análisis numérico en fenómenos de transporte. Casos de estudioDe la EverandAnálisis numérico en fenómenos de transporte. Casos de estudioÎncă nu există evaluări

- Principios Propiedades y Estrategias de Modelo MontecarloDocument7 paginiPrincipios Propiedades y Estrategias de Modelo MontecarloVictor Elias AquinoÎncă nu există evaluări

- La Simulación de MontecarloDocument8 paginiLa Simulación de MontecarloMauro HernándezÎncă nu există evaluări

- Modulo III Gestion de RiesgosDocument14 paginiModulo III Gestion de RiesgosPedro Changanaqui Ormeño100% (1)

- Simulación de MontecarloDocument24 paginiSimulación de MontecarloRenato Requena CárdenasÎncă nu există evaluări

- Teorema de Montecarlo!Document11 paginiTeorema de Montecarlo!andresÎncă nu există evaluări

- MontecarloDocument11 paginiMontecarloChubeMexÎncă nu există evaluări

- Clase 4 Simulación Montecarlo PDFDocument42 paginiClase 4 Simulación Montecarlo PDFErick Dreyk E.Încă nu există evaluări

- 7 Metodo MontecarloDocument55 pagini7 Metodo Montecarlorxsg1Încă nu există evaluări

- Monte Carlo ModeloDocument17 paginiMonte Carlo ModeloElizabeth RamirezÎncă nu există evaluări

- VAR Simulación de MontecarloDocument14 paginiVAR Simulación de MontecarloJuan Chura100% (1)

- Nivelacion de RecursosDocument33 paginiNivelacion de RecursosDania BanegasÎncă nu există evaluări

- Simulacion MonteCarlo para Programación de ProducciónDocument2 paginiSimulacion MonteCarlo para Programación de ProducciónjuanÎncă nu există evaluări

- Grupo 1 Simulación MontecarloDocument25 paginiGrupo 1 Simulación MontecarloJulissa VelascoÎncă nu există evaluări

- El Método Monte-Carlo y Su Aplicación A FinanzasDocument58 paginiEl Método Monte-Carlo y Su Aplicación A FinanzasLuis Miguel MartinezÎncă nu există evaluări

- Simulacion MonteCarloDocument20 paginiSimulacion MonteCarloJulio Jamir Montes RodriguezÎncă nu există evaluări

- El Método de MontecarloDocument4 paginiEl Método de MontecarlotonatiuhÎncă nu există evaluări

- Ejercicios de Integrales Por Sustitución TrigonométricaDocument7 paginiEjercicios de Integrales Por Sustitución Trigonométricayashua12Încă nu există evaluări

- El Modelo de Montecarlo - Informe CezarFloresDocument19 paginiEl Modelo de Montecarlo - Informe CezarFloresAroly Corrales100% (1)

- Simulación de MontecarloDocument4 paginiSimulación de MontecarloOmar SánchezÎncă nu există evaluări

- Dinamica y ControlDocument5 paginiDinamica y ControlJoako OrthzÎncă nu există evaluări

- Simulación de MonteCarlo 1 - 2021 - PUCVDocument30 paginiSimulación de MonteCarlo 1 - 2021 - PUCVHector BrionesÎncă nu există evaluări

- Informe Camino Más CortoDocument3 paginiInforme Camino Más CortoJuan David MorenoÎncă nu există evaluări

- Método Montecarlo, EjemploDocument5 paginiMétodo Montecarlo, EjemploRider MendozaÎncă nu există evaluări

- Simulación Montecarlo para Evaluar La Probabilidad de BER en Función de Eb/N0 Con Matlab/SimulinkDocument12 paginiSimulación Montecarlo para Evaluar La Probabilidad de BER en Función de Eb/N0 Con Matlab/SimulinkLuis RodriguezÎncă nu există evaluări

- Simulación y Modelos PDFDocument7 paginiSimulación y Modelos PDFsikiuÎncă nu există evaluări

- MontecarloDocument9 paginiMontecarloandyÎncă nu există evaluări

- Metodo Montecarlo para Cuantificacion RiesgosDocument18 paginiMetodo Montecarlo para Cuantificacion RiesgosJavy Patrick MárquezÎncă nu există evaluări

- Metodo MontecarloDocument24 paginiMetodo Montecarlokleber89Încă nu există evaluări

- Dijkstra DefinitivoDocument6 paginiDijkstra DefinitivoJuan CeÎncă nu există evaluări

- Metodo de Montecarlo - Primer ExamenDocument1 paginăMetodo de Montecarlo - Primer ExamenCristian Dave Llanos TolaÎncă nu există evaluări

- Metodo de Monte CarloDocument5 paginiMetodo de Monte CarloTeresa Zuñiga moralesÎncă nu există evaluări

- Método de Montecarlo Como Estrategia Didáctica Intercultural para La Enseñanza Universitaria de La Física y Matemática en El Contexto de La Educación No PresencialDocument19 paginiMétodo de Montecarlo Como Estrategia Didáctica Intercultural para La Enseñanza Universitaria de La Física y Matemática en El Contexto de La Educación No PresencialunibaguaÎncă nu există evaluări

- MontecarloDocument9 paginiMontecarloandres calamaroÎncă nu există evaluări

- ElcaminoaleatorioDocument9 paginiElcaminoaleatorioJhonnySanchezÎncă nu există evaluări

- Metodo de MontecarloDocument8 paginiMetodo de MontecarloMarvelysÎncă nu există evaluări

- Método de MontecarloDocument4 paginiMétodo de MontecarloLucho AccoÎncă nu există evaluări

- Modelo de MontecarloDocument3 paginiModelo de Montecarlokroline9596Încă nu există evaluări

- Método de MontecarloDocument4 paginiMétodo de Montecarlomilton rojasÎncă nu există evaluări

- Método MontecarloDocument2 paginiMétodo Montecarloandres sanchezÎncă nu există evaluări

- Metodo MontecarloDocument50 paginiMetodo MontecarloJaime CoylaÎncă nu există evaluări

- Tutorial Montecarlo en ExcelDocument11 paginiTutorial Montecarlo en ExcelItalo Franchini100% (1)

- Informe Metodo de MontecarloDocument7 paginiInforme Metodo de MontecarloSebastian LopezÎncă nu există evaluări

- Numeros Aleatorios y Montecarlo Ejercicio RuidoDocument12 paginiNumeros Aleatorios y Montecarlo Ejercicio RuidoAngel CortesÎncă nu există evaluări

- MontecarloDocument17 paginiMontecarloGeogeneralÎncă nu există evaluări

- Guia Metodo de MontecarloDocument1 paginăGuia Metodo de MontecarloEnrique CamposÎncă nu există evaluări

- Método de MontecarloDocument5 paginiMétodo de MontecarloSthefanny Aguilera VelásquezÎncă nu există evaluări

- Exposicion Simulacion MontecarloDocument40 paginiExposicion Simulacion MontecarloLa fourche MademoiselleÎncă nu există evaluări

- Simulacion de MontecarloDocument4 paginiSimulacion de MontecarloGonzalo Jesús Vega VigoÎncă nu există evaluări

- Calculo Del Numpero Pi Por El Metodo de MontecarloDocument3 paginiCalculo Del Numpero Pi Por El Metodo de MontecarloEl RenegadoÎncă nu există evaluări

- Método de MontecarloDocument3 paginiMétodo de MontecarloVic BlázquezÎncă nu există evaluări

- Numeros PseudoaleatoriosDocument5 paginiNumeros PseudoaleatoriosLópez GabrielÎncă nu există evaluări

- Torres Alvarez Melissa Metodo MontecarloDocument5 paginiTorres Alvarez Melissa Metodo Montecarloмelissa TorresÎncă nu există evaluări

- 05 Metodo MontecarloDocument22 pagini05 Metodo MontecarloCatunta NelsonÎncă nu există evaluări

- Simulación de MonteCarlo para Encontrar El Número Pi, Con MathematicaDocument2 paginiSimulación de MonteCarlo para Encontrar El Número Pi, Con MathematicaOliver EspinosaÎncă nu există evaluări

- El valor económico de la calidad ambiental urbana: Un análisis espacial para las comunas y barrios de CaliDe la EverandEl valor económico de la calidad ambiental urbana: Un análisis espacial para las comunas y barrios de CaliÎncă nu există evaluări

- La matemática en la ingeniería, modelación y transversalidad de saberes: Situaciones de aprendizajeDe la EverandLa matemática en la ingeniería, modelación y transversalidad de saberes: Situaciones de aprendizajeÎncă nu există evaluări

- Cadena de MarkovDocument5 paginiCadena de MarkovSergio Ochoa100% (1)

- Determinación Analítica Del Dominio Y Rango de Funciones.: X X P X GDocument8 paginiDeterminación Analítica Del Dominio Y Rango de Funciones.: X X P X GAoki SantosÎncă nu există evaluări

- Agua ReikiDocument8 paginiAgua ReikiJongleur Frater BnnÎncă nu există evaluări

- Cálculo de Refrigeración de Motores Con EjemplosDocument4 paginiCálculo de Refrigeración de Motores Con EjemplosJavier Leonidas100% (1)

- 006) Formularios 1Document12 pagini006) Formularios 1pabloÎncă nu există evaluări

- Propiedades Mecánicas Del ConcretoDocument32 paginiPropiedades Mecánicas Del ConcretoJonathan Efraín Rubio FríasÎncă nu există evaluări

- Informe de Laboratorio de Biologia 1Document9 paginiInforme de Laboratorio de Biologia 1aaaa1234qwerÎncă nu există evaluări

- Electiva Profecional Iii Familia IsoDocument12 paginiElectiva Profecional Iii Familia IsoCesar ValdesÎncă nu există evaluări

- Proyecto Vinagre de Guineo-FundamentoDocument1 paginăProyecto Vinagre de Guineo-FundamentoGiovanny Jimenez MezaÎncă nu există evaluări

- Tarea 1.1Document1 paginăTarea 1.1Hugo DiazÎncă nu există evaluări

- CG-GS-SST-DIR-009 - V1 Estandar Segregacion-DelimitacionDocument3 paginiCG-GS-SST-DIR-009 - V1 Estandar Segregacion-Delimitacioncamilo gonzalezÎncă nu există evaluări

- Fuente Dc. Laboratorio CircuitosDocument4 paginiFuente Dc. Laboratorio CircuitosJunior ALdair Andrade SiancasÎncă nu există evaluări

- UNSAACDocument12 paginiUNSAACCinthya Ataulluco PizarroÎncă nu există evaluări

- Administración de Inventarios MODELOS CON DEMANDA CONSTANTEDocument29 paginiAdministración de Inventarios MODELOS CON DEMANDA CONSTANTEDanielaÎncă nu există evaluări

- Justificacion y Antecedentes de Una InvestigacionDocument11 paginiJustificacion y Antecedentes de Una InvestigacionAlex Saca MoraÎncă nu există evaluări

- Modulo 1 Lengua Bloque 1 PDFDocument50 paginiModulo 1 Lengua Bloque 1 PDFCarmenÎncă nu există evaluări

- EticaDocument2 paginiEticaMaria Camila JaimesÎncă nu există evaluări

- 1.8 Informe de Fancy ZonesDocument15 pagini1.8 Informe de Fancy ZonesCAROLINA GOMEZ JIMENEZÎncă nu există evaluări

- Resumen H.psicologiaDocument3 paginiResumen H.psicologiaTatiana CalderonÎncă nu există evaluări

- Catálogo EternitDocument52 paginiCatálogo EternitJony HerreraÎncă nu există evaluări

- Canvas Social (Social-Business Model Canvas)Document29 paginiCanvas Social (Social-Business Model Canvas)Camilo Andres Rodriguez RuedaÎncă nu există evaluări

- UCDM Extracto Ejercicios IntroduccionDocument2 paginiUCDM Extracto Ejercicios IntroduccionDracon KnightÎncă nu există evaluări

- Apuntes de ContabilidadDocument14 paginiApuntes de ContabilidadEngelbertÎncă nu există evaluări

- Administracion Del TallerDocument22 paginiAdministracion Del TallerMiguel Granja100% (1)

- 5° Grado - Julio 17Document29 pagini5° Grado - Julio 17Gabriela NuñezÎncă nu există evaluări

- SYLLABUS Proyecto Integrador 1Document3 paginiSYLLABUS Proyecto Integrador 1Luis AguirreÎncă nu există evaluări

- Unidad 2. Organizacion de La Franquicia PDFDocument64 paginiUnidad 2. Organizacion de La Franquicia PDFclaudiaÎncă nu există evaluări

- SAP Descripcion Nro Fabricante Ubicación Necesario % Acumulado VAL. INVDocument1 paginăSAP Descripcion Nro Fabricante Ubicación Necesario % Acumulado VAL. INVBenyamin Leonardo Zuniga MarinÎncă nu există evaluări

- Informe 03 Casa Fuerza - CalderosDocument5 paginiInforme 03 Casa Fuerza - CalderossantiagoÎncă nu există evaluări

- Diarios 11° Semana de IntervenciónDocument6 paginiDiarios 11° Semana de IntervenciónMaría del Carmen Millán FloresÎncă nu există evaluări

- Problemas de Olimpiada 1Document7 paginiProblemas de Olimpiada 1Lic. Greily SánchezÎncă nu există evaluări