Documente Academic

Documente Profesional

Documente Cultură

Regresión No Paramétrica en R

Încărcat de

Ru LoTitlu original

Drepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Regresión No Paramétrica en R

Încărcat de

Ru LoDrepturi de autor:

Formate disponibile

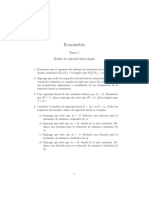

REGRESI

ON

NO PARAM

ETRICA

EN R

Trabajo Fin de Master

Master en Estadstica Aplicada

Autora: Nisa Boukichou Abdelkader

Tutora: Mara Dolores Martnez Miranda

Indice general

Prologo 1

1. Introduccion 5

1.1. Antecedentes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

1.2. Estimacion del modelo de Regresion No Parametrica . . . . . . . . . 6

1.3. Regresion Polinomial Local . . . . . . . . . . . . . . . . . . . . . . . . 10

1.4. Metodos de seleccion de la complejidad del modelo . . . . . . . . . . 13

1.5. Extension multivariante . . . . . . . . . . . . . . . . . . . . . . . . . 14

1.5.1. El problema de la dimensionalidad . . . . . . . . . . . . . . . 16

1.5.2. Modelos aditivos no parametricos . . . . . . . . . . . . . . . . 16

1.6. Seleccion del parametro ancho de banda . . . . . . . . . . . . . . . . 17

2. Software disponible en R 19

2.1. Introduccion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.2. Libro KernSmooth . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

2.3. Libro Locpol . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

2.4. Libro Loct . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63

2.5. Libro sm . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

3. Aplicacion practica 87

3.1. Estudio con datos reales . . . . . . . . . . . . . . . . . . . . . . . . . 87

3.2. Estudio con datos simulados . . . . . . . . . . . . . . . . . . . . . . . 94

Bibliografa 99

iii

Prologo

Dado el rapido avance que ha experimentado la Estadstica Computacional en

las ultimas decadas, hoy en da podemos agradecerle el desarrollo de diversos cam-

pos dentro de la Estadstica, que eran impensables dado que requeran costosos

procedimientos de calculo. Un ejemplo de este tipo lo constituyen los enfoques no

parametricos del Analisis de Regresion.

Las tecnicas de Regresion No Parametrica logran una mejor adaptacion a los

datos disponibles, mediante la obtencion de estimaciones mas proximas a la curva

de regresion subyacente. Esto es posible usando la informacion suministrada direc-

tamente desde los datos, sin formular rgidos modelos parametricos.

En este trabajo nuestro objetivo ha sido el de explorar las tecnicas de regresion

no parametrica mas habituales y las capacidades que R incorpora actualmente para

su aplicacion practica. En este sentido el trabajo se ha estructurado en tres captulos.

El primero tiene como nalidad establecer los elementos teoricos fundamentales de

la regresion no parametrica, desde la propia formulacion del modelo. De este modo

para un problema general de regresion se denen dos vas se solucion. Una sera la

regresion parametrica o clasica que presenta la ventaja de ser mas sencilla y menos

costosa desde el punto de vista computacional, pero que suele ser muy poco exible

y de difcil adaptacion en situaciones complejas. Paralelamente y no necesariamente

en contraposicion (puesto que ambas pueden ir de la mano) la denominada regresion

no parametrica. De esta ultima destacamos fundamentalmente su exibilidad, ya que

permite una mejor adaptacion a diversas situaciones y problemas, si bien requiere

de un elevado coste computacional y una mayor complejidad desde el punto de vista

teorico.

Una vez denido el contexto general y establecidas las caractersticas particulares

que perlan el problema de regresion no parametrica frente a los planteamientos

clasicos parametricos, se procede a analizar algunas de las mas relevantes tecnicas de

este tipo. El tratamiento que se ha hecho de dichos metodos en este trabajo, ha sido

dirigido fundamentalmente hacia la practica y concreto la practica con el software

R. De este modo no se ha profundizado en aspectos teoricos de complejidad como

son los estudios de tipo asintotico. Bajo tal perspectiva se han explorado metodos

univariantes y multivariantes, perlandose los denominados metodos de regresion

polinomial local como una buena solucion, dadas sus buenas propiedades teoricas y

1

2 PR

OLOGO

sus deseables caractersticas de interpretabilidad y sencillez en la practica.

De forma sencilla se plantea tambien en este primer captulo el conocido problema

de la dimensionalidad. Desde dicha motivacion se introducen metodos que permiten

salvar dicho problema, como son los modelos de regresion aditivos no parametri-

cos. Dichos modelos se caracterizan fundamentalmente porque la naturaleza de los

efectos de las variables explicativas sobre la variable de respuesta se considera de

forma individual. Esto obviamente permite ganar en simplicidad y tambien en in-

terpretabilidad.

Asociado a los metodos de regresion no parametrica (univariantes o multivari-

antes) se introduce uno de los problemas tecnicos cruciales en la practica, la eleccion

del parametro de suavizado o ancho de banda que dene la complejidad del modelo.

Desde el punto de vista teorico se formula el problema de seleccion y se perlan los

distintos metodos dise nados para su seleccion automatica. En concreto se distingue

entre los metodos basados en la metodologa plug-in, los basados en el criterio de

validacion cruzada (cross-validation) y los procedimientos basados en Bootstrap.

Una vez expuestos los elementos teoricos necesarios comienza el captulo dos,

donde se hace un estudio profundo de los aspectos computacionales asociados a

dichos metodos. El software analizado es el entorno de analisis y programacion es-

tadstica R y en contreto algunos de los libros especcos de funciones, actualmente

disponibles en la web http://cran.es.r-project.org, para la aplicacion practica

de los metodos de regresion no parametricos. Nuestra atenci on se ha centrado fun-

damentalmente en los libros kernSmooth, locpol, loct y sm, si bien existen

funciones disponibles en otros libros (stats, monreg, lokern, loess, lowess, np,

psplines, etc.). Asociado a alguna aplicacion de datos concreta se ilustrara tambien

el uso de alguna de estas funciones adicionales.

De estos libros de R se ha hecho una descripcion casi exhaustiva, obviando solo

en algunos casos partes que no corresponden a los objetivos concretos de este trabajo

y mas concretamente de los metodos teoricos desarrollados en el captulo primero.

Hemos de destacar que todo el trabajo aqu desarrollado esta sujeto a la necesaria

y continua actualizacion, dado el rapido avance en esta materia computacional. En

este sentido para cada libro se ha especicado la version utilizada incorporando

dentro de la ultima (hasta septiembre de 2009) version de R.

Para nalizar este trabajo se desarrollan en el captulo tres algunas aplicaciones

practicas. Nos hemos centrado en modelos de regresion univariante, haciendo uso de

algunas de las funciones analizadas en el captulo dos. Se han ilustrado los metodos

de regresion no parametrica para distintos conjuntos de datos. Hemos querido re-

alizar dichas ilustraciones usando datos reales (disponibles en libros de R) y tambien

mediante ejercicios de simulacion. Con esto pretendemos iniciarnos en el metodo

habitualmente usado en la investigacion para la validacion practica de las nuevas

metodologas propuestas. En la resolucion de estos ejercicios practicos hemos uti-

lizado varias funciones disponibles para el mismo problema. Esto nos ha permitido

INDICE GENERAL 3

realizar conclusiones acerca de dichos procedimientos.

A modo de conclusion podemos decir que este trabajo nos ha permitido un

acercamiento a los metodos de regresion no parametrica m as habituales con un

enfoque eminentemente practico. Las ilustraciones desarrolladas con datos permiten

explorar el modo en que actualmente se puede trabajar en R, para dar soluciones

al problema de regresion no parametrico. Los metodos de regresion polinomial local

ofrecen una sencilla va de solucion, sucientemente documentada e implementada

en diversos libros de R. No obstante sigue siendo necesaria la incorporacion de nuevas

funciones, que permitan la implementacion de novedosas tecnicas, que ocupan las

publicaciones actuales en dicha materia. Estamos seguros de que es cuestion de

no mucho tiempo y entre nuestros objetivos esta el de intentar colaborar en dicha

tarea. El inicio de este proposito se traduce en el trabajo que actualmente tiene en

sus manos.

Nisa Boukichou Abdelkader

Granada, 27 de septiembre de 2009

4

INDICE GENERAL

Captulo 1

Introduccion

1.1. Antecedentes

Consideremos en primer lugar el planteamiento de un problema de regresion,

habitualmente especicado como sigue:

Sea un conjunto de n observaciones, {(X

i

, Y

i

), i = 1, . . . , n}, de una variable

aleatoria bidimensional, (X, Y ), satisfaciendo el modelo,

Y

i

= m(X

i

) +

i

, i = 1, . . . , n, (1.1)

donde

los residuos

i

son variables aleatorias independientes (vv.aa.ii.) con media

cero y varianza

2

(X

i

),

y la funcion m es desconocida y se dene como la funcion de regresion, m(x) =

E[Y |X = x].

Un planteamiento tal corresponde a un modelo de regresion de tipo univariante,

esto es, con tan solo una variable explicativa, basado en un dise no aleatorio, donde

las observaciones constituyen una muestra aleatoria de la poblacion (X,Y). Ademas,

estamos considerando una situacion general de heterocedasticidad, es decir, las

varianzas de los errores se suponen distintas.

Con tal planteamiento el interes se centra principalmente en los tres objetivos

siguientes:

1. Explorar y representar la relacion existente entre la variable explicativa, X, y

la variable Y .

2. Predecir el comportamiento de Y para valores de la variable X a un no obser-

vados.

5

6 CAP

ITULO 1. INTRODUCCI

ON

3. Estimar las derivadas de m, as como algunas propiedades relacionadas.

Para alcanzar tales objetivos se puede optar por dos aproximaciones diferentes:

asumir alg un modelo parametrico para la funcion de regresion o no imponer tal re-

striccion, asumiendo tan solo que la funcion presenta algunas propiedades deseables

generalmente relacionadas con la derivabilidad.

La primera aproximacion correspondera a lo que se denomina Regresion Pa-

rametrica, y supone que la funcion de regresion desconocida, m, pertenece a alguna

familia parametrica de funciones, m {m

| }. De esta manera se procede a la

seleccion de alguna de ellas seg un alg un criterio previamente especicado, como

puede ser el criterio de mnimos cuadrados. Por contraposicion a la segunda

aproximacion se le denomina Regresion No Parametrica, y la unica restriccion

que se le impone a la funcion m, es que sea suave, entendiendo esta suavidad en

terminos de derivabilidad. En este ultimo sentido a estos metodos tambien se les

suele denominar metodos de suavizamiento o suavizado.

De partida podemos destacar de las dos aproximaciones una serie de ventajas e

inconvenientes:

- Los modelos de Regresi on Parametrica en general son sencillos y de calculo

rapido. Ademas, el presuponer que tienen una forma denida y parametrica

para la funcion de regresion, hace que se tengan garantizadas de antemano

las propiedades de las estimaciones resultantes. Sin embargo, se caracterizan

por ser metodos poco exibles y de difcil adaptacion en diversas situaciones

reales.

- El planteamiento no parametrico por el contrario, permite una mayor exibili-

dad y por eso, se considera una de las mejores herramientas de tipo explorato-

rio. No obstante, el no realizar muchas hipotesis sobre la estructura subyacente

en los datos se traduce en soluciones mucho mas complejas y con un mayor

coste computacional.

En este trabajo nos centraremos en la teora de Regresi on No Parametrica y de

hecho sera la aproximacion que desarrollaremos con mas detalle en lo que sigue.

1.2. Estimacion del modelo de Regresion No Pa-

rametrica

La teora y los metodos de suavizamiento o regresion no parametrica han cobrado

un gran auge en las ultimas decadas unido al avance en materia computacional. Una

revison de los mismos se puede encontrar por ejemplo en los libros de Wand y

Jones (1995), Fan y Gijbels (1996) y Loader (1999). El creciente interes por estas

1.2. ESTIMACI

ON DEL MODELO DE REGRESI

ON NO PARAM

ETRICA 7

metodologas ha tenido dos razones principales: la primera, que los estadsticos se

dieron cuenta de que planteamientos puramente parametricos no aportaban la ex-

ibilidad necesaria para la estimacion de las curvas que aparecan en la practica. Y

la segunda razon estaba ligada al avance de la informatica y al desarrollo de un

hardware que posibilitaba el costoso calculo de esos estimadores no parametricos.

Los primeros estimadores de regresion no parametrica propuestos fueron los sencillos

estimadores de tipo n ucleo de Nadaraya (1964) y Watson (1964). Dichos estimadores

se han ido renando y perfeccionando dentro de los denominados metodos de re-

gresion polinomial local, convirtendose en uno de los metodos mas empleados por

diversos analistas en la actualidad.

Y centrando la atencion en la adecuada eleccion de los par ametros decisivos en

el buen comportamiento de los estimadores de regresion resultantes, como son: el

ancho de banda o parametro de suavizado y el grado de los ajustes polinomiales

locales. A continuacion, en Eubank (1988) se puede encontrar el siguiente postulado

que dice lo siguiente:

Supongamos que la funcion de regresi on desconocida m, es suave entonces, pode-

mos esperar que las observaciones tomadas en puntos proximos a uno dado x puedan

darnos informacion del vector de dicha funcion en x.

Con este planteamiento y sobre el diagrama de dispersion de los datos, se trata

de denir unas bandas centradas en cada punto y de un ancho h, y calcular la esti-

macion en el punto utilizando tan solo las observaciones que caen dentro. Ademas,

para obtener la curva de regresion estimada, la banda denida por el parametro

h recorrera todo el diagrama de dispersion de izquierda a derecha. No obstante

tambien, al parametro h se le suele llamar ancho de banda o parametro de suavizado.

Figura 1.1: Ancho de Banda

8 CAP

ITULO 1. INTRODUCCI

ON

Como podemos observar en este graco (Figura 1.1), en primer lugar hemos

denido unas bandas centradas en los puntos x = 25 y x = 30 con un ancho h en

cada una de ellos. Y despues, hemos estimado las curvas de regresion en cada uno

de los puntos utilizando solamente las observaciones que caen dentro de cada una

de las bandas.

Por tanto, siguiendo esta idea se han desarrollado diversas tecnicas, entre las que

destacaremos estos cuatro tipos:

1. Estimadores tipo n ucleo: realizan un promedio de las observaciones que

caen en cada banda. Se denen como:

m(x) =

n

i=1

W

i

(x)Y

i

(Nadaraya Watson, 1964)

donde:

W

i

(x)

= n

1

h

1

k

_

X

i

x

h

_

2. Regresion Polinomial Local: realiza un ajuste polinomial con las observa-

ciones que caen en la banda. Se dene como:

mn

n

i=1

_

_

_

Y

i

p

j=0

j

(X

i

x)

j

_

_

_

2

h

1

k

_

X

i

x

h

_

(Cleveland, 1979)

3. Suavizamiento por Splines: se dene como la solucion a un problema de

mnimos cuadrados penalizados. Y se calcula de la siguiente forma:

min n

1

n

i=1

{m(X

i

) Y

i

}

2

+

_

(m

(r)

(x))

2

dx ( > 0)

4. Estimadores basados en Desarrollos en Serie Ortogonal o los que estan

tan de moda denominados Wavelets, se denen como:

1.2. ESTIMACI

ON DEL MODELO DE REGRESI

ON NO PARAM

ETRICA 9

m

N

(x) =

N

j=1

j

q

j

(x)

donde:

j

= n

1

n

i=1

q

j

(X

i

)Y

i

Ruppert, Wand y Carroll (2003) establecen los siguientes factores a tener en

cuenta a la hora de evaluar y decidir que tipo de estimador no parametrico utilizar

en la practica:

1. Conveniencia. Esta disponible en el software de uso habitual o favorito por

el analista?

2. Facilidad para su implementacion. Si no esta disponible directamente, es facil

implementarlo en el lenguaje de programacion habitual del analista?

3. Flexibilidad. Se trata de ver si el estimador es capaz de explicar un amplio

abanico de tipos de relaciones que pueden existir entre las variables de interes.

4. Simplicidad y sencillez. Es intuitivo? esto es, si es facil entender como el

metodo act ua sobre los datos para dar respuestas.

5. Tratabilidad: es sencillo estudiar las propiedades matematicas del estimador?.

6. Fiabilidad. Si se tiene garanta de que las respuestas proporcionadas por el

estimador son verdad.

7. Eciencia. Si el estimador hace un uso de los datos eciente.

8. Posibilidades de extension a otras situaciones o problemas mas complicados.

Este trabajo se desarrolla desde una perspectiva computacional y practica, en

este sentido ponemos especial atencion en los puntos 1, 2, 3 y 8 anteriores. As,

desde tales premisas, los metodos de regresion polinomial local constituyen una

adecuada eleccion. De hecho se trata de un procedimiento sencillo y muy intuitivo,

que esta implementado y ampliamente documentado en programas estadsticos y

lenguajes de programacion de uso extendido. Destacan implementaciones en S-Plus,

MatLab y en R atraves de diversos libros especcos.

A continuacion describiremos con mas detalle el procedimiento de regresion poli-

nomial local desde el punto de vista teorico.

10 CAP

ITULO 1. INTRODUCCI

ON

1.3. Regresion Polinomial Local

Si suponemos que la funcion de regresion,m tiene p derivadas en un punto x

0

,

entonces va el teorema de Taylor tenemos una aproximacion de este tipo para los

valores en un entorno de x

0

.

m(x) m(x

0

) +m

(x

0

)(x x

0

) +

m

(x

0

)

2!

(x x

0

)

2

+ ... +

m

(p)

(x

0

)

p!

(x x

0

)

p

Luego, esto justica que se puede aproximar localmente mpor funciones polin omi-

cas de grado p.

P

p

(x) =

p

j=0

j

(x x

0

)

j

As, se obtienen estimaciones de los coecientes

j

con j = 0, . . . , p y entonces,

observando la expresion, vemos que la estimacion del termino independiente

0

sera un estimador de m en x

0

y el resto de coecientes

j

proporcionaran esti-

maciones de sus derivadas.

Por eso, con el n de estimar m localmente mediante polinomios de grado p

consideraremos un problema de mnimos cuadrados ponderados:

min

n

i=1

_

_

_

Y

i

p

j=0

j

(X

i

x

0

)

j

_

_

_

2

k

h

(X

i

x

0

)

donde:

h es un parametro denominado ancho de banda o parametro de suavizado

que controla las observaciones que caen en cada entorno.

K

h

(u) = h

1

K(

u

h

), donde la funcion K(), se denomina funcion n ucleo.

Dicha funcion dene las ponderaciones que se asignan a cada observacion en

el entorno local considerado. Habitualmente se supone una densidad simetrica

y con soporte compacto.

y p es el grado del ajuste polinomial local.

Ademas,como casos particulares se puede obtener el conocido estimador n ucleo

de Nadaraya-Watson, que supone realizar ajustes polinomiales locales de grado cero,

y tambien cuando el ajuste polinomial es de grado uno, se obtiene el denominado es-

timador lineal local. Si bien los ajustes constantes has sido estudiados y ampliamente

1.3. REGRESI

ON POLINOMIAL LOCAL 11

utilizados por teoricos y analistas de datos, es el ajuste lineal el que ha mostrado

ser mas conveniente y el mas usado actualmente en la practica (en este sentido es

interesante la discusion del artculo de Cleveland (1979).

Como anteriormente hemos mencionado la denicion del estimador esta deter-

minado por tres parametros: el ancho de banda, h, la funcion n ucleo y el grado

p.

El ancho de banda se dene como un parametro positivo cuyo rango en prin-

cipio sera la amplitud del intervalo de estimacion. No obstante la eleccion de dicho

parametro constituye uno de los aspectos cruciales del procedimiento de estimacion.

Las buenas propiedades del estimador resultante dependera en gran medida de la

eleccion que se haga de dicho parametro. En este sentido existe una compensacion

(trade-o en ingles) entre exiblidad y complejidad que es contralada a traves de di-

cho parametro. As, si dicho parametro se toma muy peque no, tan solo observaciones

muy proximas al punto de estimacion intervendran en el calculo del estimador, de-

scribiendo muy bien comportamientos locales pero obtendremos una curva estimada

muy variable. Si por el contrario, dicho parametro se toma muy grande, las estima-

ciones en cada punto se veran afectadas por observaciones en puntos alejados de

forma que difcilmente se podran recoger los comportamientos locales, dando lugar

a grandes sesgos y como consecuencia obtendremos poca variabilidad. Notese por

tanto que una practica con anchos de banda muy grandes se traduce en proced-

imientos computacionalmente costosos.

As, desde un punto de vista teorico, la eleccion del ancho de banda tendra que

buscar una adecuada compensacion entre sesgo y varianza. Y desde un punto de

vista practico supondra la eleccion de la complejidad del modelo.

Por otro lado, con la eleccion del grado de los ajustes polinomiales nos ocurre

algo similar. Es decir, la utilizacion de ajustes de grado cero o uno nos daran es-

timaciones con poca variabilidad, muy suaves, pero con sesgos muy elevados. Por

el contrario, cuando los ajustes son con grados mayores (dos o tres) nos permitiran

mayor adaptabilidad, o sea, menores sesgos pero, obtendremos mayor varianza.

Luego, del mismo modo que para la eleccion del ancho de banda es necesario una

compensacion entre sesgo y varianza, para elegir p se buscara tambien la compen-

sacion optima entre sesgo y varianza.

Y nalmente, la funcion n ucleo, K, dene la forma de los pesos que se asocian a

cada observacion dentro de la banda denida y por tanto, determina su importancia

en el calculo de la estimacion. Para dicha funcion es habitual el uso de alguna de las

siguientes densidades:

1. Triangular: k(u) = (1 |u|)1

|u|1

2. Epanechnikov: k(u) =

3

4

(1 u

2

)1

|u|1

3. Biponderado: k(u) =

15

16

(1 u

2

)

2

1

|u|1

12 CAP

ITULO 1. INTRODUCCI

ON

4. Gaussiano: k(u) = (2)

1

exp(

x

2

2

)1

|u|1

En la practica, la eleccion del n ucleo no afecta al buen comportamiento de las

estimaciones resultantes, por lo que considerar una funcion u otra atiende funda-

mentalmente a razones tecnicas.

Por otro lado, tenemos que el ancho de banda y el grado del polinomio necesitan

una compensacion entre el sesgo y la varianza, por tanto, se denen a continuacion

criterios para medir dicho compromiso y asimismo, la consecuente bondad de las

estimaciones.

Luego, entre las diversas medidas que se pueden denir, hemos considerado las

siguientes:

- El Error Cuadratico Medio Condicional en su version local (MSE):

MSE( m

h

(x

0

)) = E

Y/X

_

( m

h

(x

0

) m(x

0

))

2

_

- El Error Cuadratico Medio Condicional en su version global (MISE):

MISE( m

h

) = E

Y/X

__

( m

h

(x) m(x))

2

dx

_

Por tanto, como sabemos el error cuadratico medio se puede descomponer en

un termino de sesgo al cuadrado mas uno de varianza, por lo que podemos asumir

que este criterio permitira la compensacion entre sesgo y varianza anteriormente

mencionado.

MSE( m

h

(x

0

)) =

_

E

Y/X

[ m

h

(x

0

)] m(x

0

)

_

2

. .

sesgo

2

+V ar

Y/X

( m

h

(x

0

))

. .

varianza

En cuanto, a la eleccion entre un criterio u otro dependera de que busquemos

optimalidad en cada punto (MSE) o bien, que busquemos la optimalidad conjunta

en todo el intervalo de estimacion (MISE).

A continuacion, veremos varios procedimientos de estimacion de h o tambien

denominados selectores del ancho de banda o metodos se seleccion de la complejidad

del modelo.

1.4. M

ETODOS DE SELECCI

ON DE LA COMPLEJIDAD DEL MODELO 13

1.4. Metodos de seleccion de la complejidad del

modelo

A) Metodos Plug-in

La idea que subyace en este tipo de tecnicas es que a partir de la expresion

optima teorica del ancho de banda, se proponen estimadores de lo desconocido

que se incrustaran en dicha expresion teorica. No obstante, aunque estos pro-

cedimientos comparten una misma losofa, podemos hacer una clasicacion

de los mismos en dos categoras:

- Plug-in Asintotico:

Parte de expresiones asintoticas teoricas del error (MSE o MISE) y estima

lo desconocido. Y uno de los inconvenientes que tiene es que es necesario

realizar hipotesis bastante restrictivas sobre la funcion de regresion de-

sconocida, lo cual limita su campo de aplicacion en la practica. Ademas,

es valida para tama nos muestrales grandes porque en caso, de tama nos

muestrales peque nos dicho procedimiento no es efectivo.

- Plug-in no Asintotico:

Debido al problema que presenta el plug-in asintotico en muestras peque nas,

se toma como punto de partida expresiones desarrolladas de los errores

teoricos de naturaleza no asintotica, incrustando en ellas las estimaciones

propuestas para los terminos desconocidos. Por otro lado, dependiendo

de si utilizan iteraciones para llegar a la solucion optima, se pueden

distinguir entre:

- Plug-in iterativo:

A naden una sucesion de iteraciones con el n de conseguir una progresiva

mejora del ancho de banda. Su inconveniente es que aumenta el coste

computacional.

- Plug-in no iterativo o directo:

Son los que no utilizan iteraciones para la obtencion del selector del

parametro.

B) Otros metodos de seleccion automatica basados en los datos:

Se basan en la minimizacion de criterios de error relacionados con con los

anteriores MSE y MISE pero conocidos, como es la suma residual de cuadrados

para obtener la seleccion del parametro. Ademas, dentro del mismo destacamos

algunas de las elecciones mas habituales, como son:

14 CAP

ITULO 1. INTRODUCCI

ON

La validacion cruzada por mnimos cuadrados.

La validacion cruzada generalizada.

El criterio de informacion de Akaike.

El error de prediccion nito.

El selector de Shibata.

La T de Rice.

C) Procedimientos basados en aproximaciones Bootstrap

La metodologa bootstrap tiene como proposito ganar informacion acerca de

la distribucion de un estimador. Sin embargo, en regresion no parametrica

la metodologa bootstrap es utilizada fundamentalmente para dos tareas: la

primera es la de elegir el parametro de suavizamiento o ancho de banda y la

segunda es la de construir intervalos de conanza para la curva de regresion.

1.5. Extension multivariante

Consideramos ahora la extension del modelo (1.1) al caso en que se considera

mas de una covariable. De este modo sea X

i

un vector de D covariables y el modelo

general de regresion multivariante heterocedastico dado por:

Y

i

= m(X

i

) +

i

(1.2)

donde la funcion (x) = V ar[Y |X = x] es nita, y los residuos,

i

, son vari-

ables independientes e identicamente distribuidas, con media cero, varianza

2

(X

i

)

y son independientes de los vectores aleatorios, X

i

. La funcion de regresion, m(x) =

E[Y |X = x], con x = (x

1

, . . . , x

D

)

T

.

El modelo de regresion lineal multivariante supone que la relacion entre la vari-

able de respuesta Y y cada una de las variables independientes es lineal. A veces,

es evidente que esta relacion no es lineal, por lo que hay que considerar modelos

que sean mas exibles. Las tecnicas de regresion no parametricas responden a esta

exibilidad ya que no imponen condiciones sobre la forma de la funcion D-variante,

m(x).

En esta situacion, los estimadores mas comunes para m(x) son versiones mul-

tivariantes de los estimadores tipo n ucleo (como los polinomiales locales descritos

anteriormente) o splines de suavizamiento. Ruppert y Wand (1994) introducen la

extension multivariante del estimador polinomial local. A continuacion describimos

el estimador polinomial local para el caso general de grado p y D > 1. Consideramos

el siguiente problema de mnimos cuadrados ponderados:

1.5. EXTENSI

ON MULTIVARIANTE 15

mn

i=1

_

_

_

Y

i

p

L=1

l

1

+...+l

d

=L

l

1

,...,l

d

D

j=1

(X

i

x

j

)

l

j

_

_

_

2

K

H

(X

i

x)

donde: = {

l

1

,...,l

D

: l

1

+. . . + l

D

= L} y L = {0, . . . , p} es un vector de coe-

cientes, H es una matriz de dimension D D simetrica, denida positiva; K() es

una funcion n ucleo no negativa D-variante y K

H

(u) = |H|

1/2

K(H

1/2

u).

A la matriz H se le denomina matriz ancho de banda, dado que es la extension

multivariante del parametro ancho de banda univariante. Si denotamos por

j

, j =

0, . . . , p, a las soluciones del problema anterior entonces, usando el desarrollo de

Taylor, el estimador polinomico local vendra dado por la primera de ellas, esto es:

m

p

(x) =

0,...,0

El problema en forma matricial y su solucion, se denen mediante:

mn

(YX

x

)

T

W

x,H

(YX

x

)

m

p

(x) = e

T

1

_

X

T

x

W

x,H

X

x

_

1

X

T

x

W

x,H

Y

donde e

1

es un vector (pD + 1), con un 1 en la primera posicion y 0 en el resto,

Y = (Y

1

, . . . , Y

n

)

T

,

X

x

=

_

_

_

_

1 (X

1

x)

T

((X

1

x)

p

)

T

.

.

.

.

.

.

.

.

.

.

.

.

1 (X

n

x)

T

((X

n

x)

p

)

T

_

_

_

_

y

W

x,H

= diag {K

H

(X

1

x), . . . , K

H

(X

n

x)}

Casos particulares:

p = 0, este coincide con la version multivariante del estimador n ucleo de

Nadaraya-Watson:

m

0

(x) =

n

i=1

K

H

(X

i

x)Y

i

n

i=1

K

H

(X

i

x)

16 CAP

ITULO 1. INTRODUCCI

ON

p = 1, es el estimador lineal local multivariante (Ruppert y Wand, 1994):

m

1

(x) = e

T

1

_

X

T

x,H

W

x,H

X

x

_

1

X

T

x

W

x,H

Y

1.5.1. El problema de la dimensionalidad

Aunque la generalizacion al caso multidimensional de la mayora de tecnicas

de suavizamiento es posible, aparece un problema importante conocido como: el

problema de la dimensionalidad, (en ingles the curse of dimensionality, Bell-

man,1961).

Este problema se reere al hecho de que cuando estamos estimando, considerando

un entorno con un n umero jo de datos, y tenemos una supercie de gran dimension,

dicho entorno puede ser demasiado grande como para ser llamado local, es decir,

si un entorno local contiene 10 datos de cada variable, entonces el correspondiente

entorno local D dimensional contiene 10

D

datos.

Como consecuencia se necesitan conjuntos de datos mucho mas grandes incluso

cuando D no es muy elevado, y en la practica puede que tales conjuntos no esten

disponibles.

Otro problema que presentan los estimadores multivariantes es la falta de inter-

pretabilidad, ya que sera difcil de visualizarlos gracamente. No es posible repre-

sentar supercies para D > 2.

Tambien resulta un inconveniente el excesivo coste computacional de las versiones

multivariantes, que requieren un gran n umero de operaciones. Esto hace que en la

practica los suavizadores multidimensionales solo se apliquen hasta dimensiones 2

o 3.

Los problemas anteriores nos llevan a plantear modelos alternativos que eviten

estos inconvenientes, como los que se comentan en este trabajo y que reciben el

nombre de modelos aditivos.

Los modelos aditivos se presentan como una herramienta util para el analisis de

datos. Estos modelos mantienen una importante caracterstica de interpretacion de

los modelos lineales, al tener representada cada variable de forma separada. As la

naturaleza de los efectos de una variable sobre la variable de respuesta no depende

de los valores de las otras variables.

Los modelos aditivos fueron formulados por Friedman y Stuetzle, (1981) y con-

stituan el centro del algoritmo ACE de Breiman y Friedman(1985).

1.5.2. Modelos aditivos no parametricos

Propuestos por Hastie y Tibshirani (1990), son una tecnica de regresion no

parametrica multivariante muy utilizada. Frente a otras tecnicas de regresion no

1.6. SELECCI

ON DEL PAR

AMETRO ANCHO DE BANDA 17

parametrica multivariante, los modelos aditivos pueden interpretar facilmente los

efectos individuales de las variables independientes sobre la variable dependiente,

sin tener en cuenta que el n umero de variables sea elevado. Si partimos del modelo

de regresion m ultiple heterocedastico (1.2), el modelo aditivo supone que la funcion,

m, se puede escribir como la suma de funciones univariantes de cada una de las

variables independientes, que se suponen suaves; es decir:

m(x) = E

_

Y |X = (x

1

, . . . , x

D

)

T

_

= + m

1

(x

1

) + . . . + m

D

(x

D

)

Para estimar este modelo se han propuesto en los ultimos a nos diferentes meto-

dos, entre ellos destacamos el algoritmo backtting, el metodo de integraci on marginal

y el smooth backtting (Nielsen and Sperlich, 2005), como los mas importantes, y a

partir de estos se han propuesto distintas modicaciones pero, todas ellas con el n

de mejorar las estimaciones obtenidas.

El algoritmo backtting, propuesto por Buja, Hastie y Tibshirani (1989) pro-

porciona un metodo iterativo para estimar las componentes unidimensionales. Sin

embargo, el hecho de ser un proceso iterativo diculta el estudio de las propiedades

asintoticas de las estimaciones. Y por eso, esta dicultad del estudio de las propiedades

del algoritmo backtting es lo que lleva a otros autores a plantearse metodos de es-

timacion alternativos.

De esta forma, Linton y Nielsen(1995) proponen el metodo de integracion

marginal para un modelo aditivo bivariante, este es un metodo que estima di-

rectamente cada una de las componentes univariantes y permite el estudio de sus

propiedades, y fue generalizado para un modelo multivariante (D > 2) por Hengart-

ner(1996) y Kim, Linton y Hengartner(1997).

1.6. Seleccion del parametro ancho de banda

La seleccion de una matriz de anchos de banda en el caso general multivariante,

H, a partir de los datos, ha sido mucho menos considerado en la literatura que el

problema en el caso univariante, en el que interviene un unico ancho de banda.

En el caso de los modelos aditivos, el parametro es un vector que dene el grado

de suavizamiento empleado en cada componente del modelo y puede considerar un

ancho de banda diferente para cada una de las componentes aditivas o un unico

parametro com un para todas ellas.

Al igual que en el caso univariante se pueden utilizar diversos metodos de se-

leccion del parametro ancho de banda. Los mas destacados son el metodo plug-in y

el metodo de validacion cruzada. Para una revision de estos metodos se pueden ver

en el libro de Hastie y Tibshirani (1990) y en el de Martnez Miranda et al., (2008).

18 CAP

ITULO 1. INTRODUCCI

ON

El metodo de validacion cruzada de este modelo se puede encontrar en el libro

de Kim, Linton y Hengartner, 1999; en el de Kauermann y Opsomer, 2003 y en el

de Nielsen y Sperlich, 2005.

Y para los metodos plug-in ver los libros de Opsomer y Ruppert, 1997; el de

Severance-Lossin y Sperlich, 1997 y el de Mammen y Park, 2005.

Captulo 2

Software disponible en R

2.1. Introducci on

El programa R es un entorno de analisis y programacion estadstico que forma

parte del proyecto de software libre GNU General Public Licence. R esta disponible

en la direccion http://www.r-project.org. El proyecto R comenzo en 1995 por

un grupo de estadsticos de la universidad de Auckland, dirigidos por Ross Ihaka

y Robert Gentleman. R esta basado en el lenguaje de programacion S, dise nado

especcamente para la programacion de tareas estadsticas en los a nos 80 por los

Laboratorios Bell AT&T. El lenguaje S se considera un lenguaje de programacion

estadstica orientado a objetos de alto nivel.

Frente a otros lenguajes de programacion, R es sencillo, intuitivo y eciente

ya que se trata de un lenguaje interpretado (a diferencia de otros como Fortran,

C++, Visual Basic, etc.). Como programa de analisis estadstico, R-base permite

realizar tareas estadsticas sencillas habituales y ademas permite extensiones que

implementan tecnicas estadsticas avanzadas. De este modo se cubre las necesidades

de cualquier analista, tanto en el ambito de la estadstica profesional como en el de

la investigacion estadstica.

R consta de un sistema base pero la mayora de las funciones estadsticas vienen

agrupadas en distintos libros (o bibliotecas del ingles packages) que se incorporan

de forma opcional. Para los metodos de regresion no parametrica existen funciones

disponibles en el libro basico stats, no obstante el uso mas adecuado de dichos meto-

dos puede conseguirse a traves de funciones incorporadas en varios libros adicionales

y actualmente disponibles en la web. Entre estos libros destacan kernSmooth,

locpol, np, loct,lokern, monreg, loess, sm, lowess etc.

En este captulo haremos una descripcion casi exhaustiva de algunos de estos

libros. En concreto nos centraremos en los libros kernSmooth, locpol, loct y sm.

Se ha obviado solo en algunos casos, partes que no corresponden a los objetivos

concretos de este trabajo y mas concretamente de los metodos teoricos desarrollados

19

20 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

en el captulo primero.

Hemos de destacar que todo el trabajo aqui desarrollado esta sujeto a la necesaria

y continua actualizacion, dado el rapido avance en esta materia computacional. En

este sentido los libros descritos se ha actualizado solo en la fecha que se indica en

sus correspondientes apartados.

2.2. Libro KernSmooth

En este libro llamado KernSmooth se trabajara con funciones para el suavizado

del n ucleo y la estimacion de densidades correspondientes al texto de Wand y Jones

(1995). Dicho libro corresponde a la actualizacion del 24-05-2009, version 2.23-2 y

esta sujeta a cualquier modicacion a da de hoy porque esta en constante actual-

izacion.

Ademas, nos vamos a encontrar en este libro diferentes funciones con las que

podremos trabajar el tema que nos ocupa como es la regresion no parametrica. Los

detalles de cada una de las funciones se veran en cada seccion de las mismas con

mas detenimiento pero, basicamente tratan de calcular el parametro de seleccion, el

estimador de densidad, el calculo de los bins y la funcion de regresion.

Funci on bkde

Descripcion: devuelve las coordenadas x e y de un Binned estimado de la

densidad del n ucleo para la funcion de probabilidad de los datos.

Funcion:

bkde(x, kernel = "normal", canonical = FALSE, bandwidth,

gridsize = 401L, range.x, truncate = TRUE)

donde:

El n ucleo kernel puede ser: normal, box (rectangular), epanech (Beta(2,2)),

biweight (Beta(3,3)), triweight (Beta(3,3)).

Valor devuelto por la funcion: esta funcion devuelve un graco de la funcion

de probabilidad.

Ejemplo de uso:

> data(geyser, package="MASS")

> x <- geyser$duration

2.2. LIBRO KERNSMOOTH 21

> est <- bkde(x, bandwidth=0.25)

> plot(est, type="l")

0 1 2 3 4 5 6

0

.

0

0

.

1

0

.

2

0

.

3

0

.

4

0

.

5

est$x

e

s

t

$

y

Figura 2.1: KernSmooth de bkde

Funci on bkde2D

Descripcion: devuelve la red de puntos y la matriz de densidad estimada in-

ducida. El n ucleo es la densidad normal bivariada.

Funcion:

bkde2D(x, bandwidth, gridsize = c(51L, 51L), range.x, truncate = TRUE)

Valor devuelto por la funcion: esta funcion devuelve dos gracos, el primero

es el contorno de las variables x1 y x2 y las estimaciones de

f. Y el segundo graco,

es la perpestiva de las estimaciones de

f.

Ejemplo de uso:

> data(geyser, package="MASS")

> x <- cbind(geyser$duration, geyser$waiting)

22 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

> est <- bkde2D(x, bandwidth=c(0.7, 7))

> contour(est$x1, est$x2, est$fhat)

> persp(est$fhat)

0.001

0.002

0.003

0.004

0.005

0.006

0.006

0.007

0.007

0 1 2 3 4 5 6

4

0

6

0

8

0

1

0

0

1

2

0

Figura 2.2: KernSmooth de bkde2D

1

est$fhat

Y

Z

Figura 2.3: KernSmooth de bkde2D

2

Funci on bkfe

Descripcion: calcula una estimacion aproximada (binned) para la estimacion

tipo n ucleo de una funcion de densidad. El n ucleo es la densidad normal estandar.

2.2. LIBRO KERNSMOOTH 23

Funcion:

bkfe(x, drv, bandwidth, gridsize = 401L, range.x, binned = FALSE,

truncate = TRUE)

donde:

El drv: es el orden de la derivada en la funcion de densidad.

Valor devuelto por la funcion: esta funcion lo que nos devuelve es un valor

aproximado de la estimacion de la densidad.

Ejemplo de uso:

> data(geyser, package="MASS")

> x <- geyser$duration

> est <- bkfe(x, drv=4, bandwidth=0.3)

> est

[1] 33.04156

Funci on dpih

Descripcion: Se utiliza directamente el metodo plug-in para seleccionar el tama no

del bin de un estimador de tipo histograma.

NOTA: Plug-in puede ser asintotico y no asintotico, y si se usa iteraciones para

llegar a la solucion optima pueden ser plug-in iterativo y plug-in no iterativo (di-

recto).

Funcion:

dpih(x, scalest = "minim", level = 2L, gridsize = 401L,

range.x = range(x), truncate = TRUE)

donde:

El minim es el mnimo de la desviacion tpica estandar (stdev) y del rango

intercuartilico (iqr) dividido por 1349.

24 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

Valor devuelto por la funcion: esta funcion devuelve un valor y con este se

construye el vector de los bins que posteriormente se utilizaran para construir el

histograma.

Ejemplo de uso:

> data(geyser, package="MASS")

> x <- geyser$duration

> h <- dpih(x)

> bins <- seq(min(x)-0.1, max(x)+0.1+h, by=h)

> hist(x, breaks=bins)

> h <- dpih(x)

> h

[1] 0.2088382

> bins <- seq(min(x)-0.1, max(x)+0.1+h, by=h)

> bins

[1] 0.7333333 0.9421715 1.1510096 1.3598478 1.5686859 1.7775241 1.9863623

[8] 2.1952004 2.4040386 2.6128767 2.8217149 3.0305530 3.2393912 3.4482294

[15] 3.6570675 3.8659057 4.0747438 4.2835820 4.4924202 4.7012583 4.9100965

[22] 5.1189346 5.3277728 5.5366110 5.7454491

Histogram of x

x

F

r

e

q

u

e

n

c

y

1 2 3 4 5

0

1

0

2

0

3

0

4

0

5

0

6

0

Figura 2.4: KernSmooth de dpih

2.2. LIBRO KERNSMOOTH 25

Funci on dpik

Descripcion: Se utiliza directamente el metodo plug-in para seleccionar el ancho

de banda de la densidad estimada tipo n ucleo.

Funcion:

dpik(x, scalest = "minim", level = 2L, kernel = "normal",

canonical = FALSE, gridsize = 401L, range.x = range(x),

truncate = TRUE)

donde:

El minim es el mnimo de la desviacion tpica estandar, stdev y del rango

intercuartlico, iqr dividido por 1.349.

Valor devuelto por la funcion: esta funcion devuelve el valor del ancho de

banda y despues, lo utiliza con la funcion bkde para calcular los bins estimados de la

densidad del n ucleo para nalmente representarlos gracamente dicha estimacion.

Ejemplo de uso:

> data(geyser, package="MASS")

> x <- geyser$duration

> h <- dpik(x)

> h

[1] 0.1434183

> est <- bkde(x, bandwidth=h)

> plot(est,type="l")

26 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

1 2 3 4 5 6

0

.

0

0

.

2

0

.

4

0

.

6

est$x

e

s

t

$

y

Figura 2.5: KernSmooth de dpik

Funci on dpill

Descripcion: Se utiliza el metodo plug-in para la seleccion del ancho de banda

de un estimador lineal local con n ucleo gaussiano, descrito por Ruppert, Sheather y

Wand (1995).

Funcion:

dpill(x, y, blockmax = 5, divisor = 20, trim = 0.01, proptrun = 0.05,

gridsize = 401L, range.x, truncate = TRUE)

donde:

El blockmax es el n umero maximo de bloques de los datos para la construccion

de un parametro inicial estimado.

El trim es la proporcion de la muestra de cada uno de los extremos recortados

en la direccion x antes de aplicar el metodo plug-in.

El proptrun es la proporcion de la serie de x en cada extremo truncado en la

funcion estimada.

2.2. LIBRO KERNSMOOTH 27

Valor devuelto por la funcion: esta funcion devuelve el valor del ancho de

banda seg un el metodo descrito por Ruppert, Sheather y Wand (1995). Este valor

se puede utilizar para calcular el estimador de regresion lineal local.

Ejemplo de uso:

> local({pkg <- select.list(sort(.packages(all.available = TRUE)))

+ if(nchar(pkg)) library(pkg, character.only=TRUE)})

KernSmooth 2.23 loaded

Copyright M. P. Wand 1997-2009

> data(geyser, package = "MASS")

> x <- geyser$duration

> y <- geyser$waiting

> plot(x, y)

> h <- dpill(x, y)

> h

[1] 0.2342897

> fit <- locpoly(x, y, bandwidth = h)

> lines(fit)

1 2 3 4 5

5

0

6

0

7

0

8

0

9

0

1

0

0

1

1

0

x

y

Figura 2.6: KernSmooth de dpill

28 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

Funci on locpoly

Descripcion: Estima una funcion de densidad de probabilidad, una funcion de

regresion o sus derivadas utilizando polinomios locales.

Funcion:

locpoly(x, y, drv = 0L, degree, kernel = "normal",

bandwidth, gridsize = 401L, bwdisc = 25,

range.x, binned = FALSE, truncate = TRUE)

donde:

El drv es el orden de la derivada para ser estimada.

El bwdisc es el n umero de anchos de banda equiespaciados logaritmicamente

utilizados para acelerar el calculo.

Valor devuelto por la funcion: esta funcion devuelve un objeto con los re-

sultados de la estimacion de la funcion de densidad o la funci on de regresion o sus

derivadas utilizando polinomios locales. A partir de este objeto se puede representar

el ajuste realizado usando el metodo plot.

Ejemplo de uso:

> data(geyser, package = "MASS")

> # local linear density estimate

> x <- geyser$duration

> est <- locpoly(x, bandwidth = 0.25)

> plot(est, type = "l")

> # local linear regression estimate

> y <- geyser$waiting

> plot(x, y)

> fit <- locpoly(x, y, bandwidth = 0.25)

> lines(fit)

2.2. LIBRO KERNSMOOTH 29

1 2 3 4 5

0

.

0

0

.

1

0

.

2

0

.

3

0

.

4

0

.

5

est$x

e

s

t

$

y

Figura 2.7: KernSmooth de locpoly

1 2 3 4 5

5

0

6

0

7

0

8

0

9

0

1

0

0

1

1

0

x

y

Figura 2.8: KernSmooth de locpoly

30 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

2.3. Libro Locpol

En este libro se recogen funciones que calculan estimadores de tipo polinomial

local, seg un se describen en Fan y Gijbels (1996) o Wand y Jones (1995). Dicho libro

corresponde a la actualizacion del 17-04-2009, version es del 0.2-0.

Dentro de este libro se recogen funciones para calcular cantidades utiles asociadas

a los n ucleos, el estimador de densidad, la estimacion polinomial local as como

selectores del parametro ancho de banda de tipo plug-in y validacion cruzada.

Funci on compKernVals

Descripcion: permiten calcular valores utiles relacionados con el n ucleo.

Funciones:

computeRK(kernel, lower=dom(kernel)[[1]], upper=dom(kernel)[[2]],

subdivisions = 25)

computeK4(kernel, lower=dom(kernel)[[1]], upper=dom(kernel)[[2]],

subdivisions = 25)

computeMu(i, kernel, lower=dom(kernel)[[1]], upper=dom(kernel)[[2]],

subdivisions = 25)

computeMu0(kernel, lower=dom(kernel)[[1]], upper=dom(kernel)[[2]],

subdivisions = 25)

Kconvol(kernel,lower=dom(kernel)[[1]],upper=dom(kernel)[[2]],

subdivisions = 25)

donde:

lower, upper: son los lmites de integracion inferior y superior.

Valor devuelto por las funciones: estas funciones devuelven un valor numerico

que son del tipo:

computeK4: es el cuarto n de autoconvolucion de K.

computeRK: es el segundo n de autoconvolucion de K.

2.3. LIBRO LOCPOL 31

computeMu0: es el integrante de K.

computeMu2: es el segundo momento de orden K.

computeMu: es el i-esimo momento de orden K.

Kconvol : es la autoconvolucion de K.

Ejemplo de uso:

> g <- function(kernels)

+ {

+ mu0 <- sapply(kernels,function(x) computeMu0(x,))

+ mu0.ok <- sapply(kernels,mu0K)

+ mu2 <- sapply(kernels,function(x) computeMu(2,x))

+ mu2.ok <- sapply(kernels,mu2K)

+ Rk.ok <- sapply(kernels,RK)

+ RK <- sapply(kernels,function(x) computeRK(x))

+ K4 <- sapply(kernels,function(x) computeK4(x))

+ res <- data.frame(mu0,mu0.ok,mu2,mu2.ok,RK,Rk.ok,K4)

+ res

+ }

> g(kernels=c(EpaK,gaussK,TriweigK,TrianK))

mu0 mu0.ok mu2 mu2.ok RK Rk.ok K4

1 1 1 0.2000000 0.200000 0.6000000 0.6000000 0.4337657

2 1 1 1.0000000 1.000000 0.2820948 0.2820948 0.1994711

3 1 1 0.1111111 0.111111 0.8158508 0.8158510 0.5879019

4 1 1 0.1666667 0.166667 0.6666667 0.6666670 0.4793655

## Sacamos los valores de cada funcion individualmente pero

## son los mismos que se observan en la tabla anterior.

> EpaK

function (x)

ifelse(abs(x) <= 1, 3/4 * (1 - x^2), 0)

attr(,"RK")

[1] 0.6

attr(,"RdK")

[1] 1.5

32 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

attr(,"mu0K")

[1] 1

attr(,"mu2K")

[1] 0.2

attr(,"K4")

[1] 0.4337657

attr(,"dom")

[1] -1 1

> gaussK

function (x)

dnorm(x, 0, 1)

attr(,"RK")

[1] 0.2820948

attr(,"RdK")

[1] 0.1410474

attr(,"mu0K")

[1] 1

attr(,"mu2K")

[1] 1

attr(,"K4")

[1] 0.1994711

attr(,"dom")

[1] -Inf Inf

> TriweigK

function (x)

ifelse(abs(x) <= 1, 35/32 * (1 - x^2)^3, 0)

attr(,"RK")

[1] 0.815851

attr(,"RdK")

[1] 3.18182

attr(,"mu0K")

[1] 1

attr(,"mu2K")

[1] 0.111111

attr(,"K4")

[1] 0.5879012

attr(,"dom")

2.3. LIBRO LOCPOL 33

[1] -1 1

> TrianK

function (x)

ifelse(abs(x) <= 1, (1 - abs(x)), 0)

attr(,"RK")

[1] 0.666667

attr(,"RdK")

[1] 2

attr(,"mu0K")

[1] 1

attr(,"mu2K")

[1] 0.166667

attr(,"K4")

[1] 0.4793729

attr(,"dom")

[1] -1 1

Funci on denCVBwSelC

Descripcion: calcula el selector mediante validacion cruzada del ancho de banda

para el estimador de la densidad de Parsen-Rosenblatt.

Funcion:

denCVBwSelC(x, kernel = gaussK, weig = rep(1, length(x)),

interval = .lokestOptInt)

donde:

weig: es un vector de pesos para las observaciones.

Valor devuelto por la funcion: esta funcion devuelve un valor numerico con

el ancho de banda.

Ejemplo de uso:

> stdy <- function(size=100,rVar=rnorm,dVar=dnorm,kernel=gaussK,x=NULL)

+ {

34 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

+ if( is.null(x) ) x <- rVar(size)

+ Tc <- system.time( dbwc <- denCVBwSelC(x,kernel) )[3]

+ ucvT <- system.time( ucvBw <- bw.ucv(x,lower=0.00001,upper=2.0) )[3]

+ nrdT <- system.time( nrdBw <- bw.nrd(x) )[3]

+ {

+ xeval <- seq( min(x)+dbwc , max(x)-dbwc ,length=50)

+ hist(x,probability=TRUE)

+ lines(xeval,trueDen <- dVar(xeval),col="red")

+ lines(density(x),col="cyan")

+ xevalDenc <- PRDenEstC(x,xeval,dbwc,kernel)

+ dencMSE <- mean( (trueDen-xevalDenc)^2 )

+ xevalucvDen <- PRDenEstC(x,xeval,ucvBw,kernel)

+ ucvMSE <- mean( (trueDen-xevalucvDen)^2 )

+ xevalDenNrd <- PRDenEstC(x,xeval,nrdBw,kernel)

+ nrdMSE <- mean( (trueDen-xevalDenNrd)^2 )

+ lines(xevalDenc,col="green")

+ lines(xevalucvDen,col="blue")

+ lines(xevalDenNrd,col="grey")

+ }

+ return( cbind( bwVal=c(evalC=dbwc,ucvBw=ucvBw,nrdBw=nrdBw),

+ mse=c(dencMSE,ucvMSE,nrdMSE),

+ time=c(Tc,ucvT,nrdT) ) )

+ }

> stdy(100,kernel=gaussK)

bwVal mse time

evalC 0.1806189 0.5476062 6.92

ucvBw 0.1846771 0.5474982 0.06

nrdBw 0.3460004 0.5448560 0.01

> stdy(100,rVar=rexp,dVar=dexp,kernel=gaussK)

bwVal mse time

evalC 0.1197885 4.646692 7.59

ucvBw 0.1209562 4.646678 0.00

nrdBw 0.3183121 4.647766 0.00

> stdy(200,rVar=rexp,dVar=dexp,kernel=gaussK)

2.3. LIBRO LOCPOL 35

bwVal mse time

evalC 0.06563341 8.532414 33.04

ucvBw 0.06655133 8.532399 0.01

nrdBw 0.28667317 8.533728 0.00

## check stdy with other kernel, distributions

Histogram of x

x

D

e

n

s

i

t

y

2 1 0 1

0

.

0

0

.

1

0

.

2

0

.

3

0

.

4

0

.

5

Figura 2.9: Locpol de denCVBwSelC

1

Histogram of x

x

D

e

n

s

i

t

y

0 1 2 3 4 5

0

.

0

0

.

2

0

.

4

0

.

6

0

.

8

Figura 2.10: Locpol de denCVBwSelC

2

36 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

Histogram of x

x

D

e

n

s

i

t

y

0 2 4 6 8

0

.

0

0

.

1

0

.

2

0

.

3

0

.

4

0

.

5

0

.

6

Figura 2.11: Locpol de denCVBwSelC

3

Funci on equivKernel

Descripcion: calcula el n ucleo equivalente asociado a la estimacion polinomica

local de la funcion de regresion o sus derivadas.

Funcion:

equivKernel(kernel,nu,deg,lower=dom(kernel)[[1]],upper=dom(kernel)[[2]],

subdivisions=25)

donde:

nu: es el orden de derivadas a estimar.

Valor devuelto por la funcion: esta funcion devuelve un vector cuyas com-

ponentes son el n ucleo equivalente utilizado para calcular el estimador polinomial

local de las derivadas de la funcion de regresion.

Ejemplo de uso:

> curve(EpaK(x),-3,3,ylim=c(-.5,1))

> f <- equivKernel(EpaK,0,3)

> curve(f(x),-3,3,add=TRUE,col="blue")

> curve(gaussK(x),-3,3,add=TRUE)

2.3. LIBRO LOCPOL 37

> f <- equivKernel(gaussK,0,3)

> curve(f(x),-3,3,add=TRUE,col="blue")

> ## Draw several Equivalent local polynomial kernels

> curve(EpaK(x),-3,3,ylim=c(-.5,1))

> for(p in 1:5){

+ curve(equivKernel(gaussK,0,p)(x),-3,3,add=TRUE)

+ }

3 2 1 0 1 2 3

0

.

5

0

.

0

0

.

5

1

.

0

x

E

p

a

K

(

x

)

Figura 2.12: Locpol de equivKernel

3 2 1 0 1 2 3

0

.

5

0

.

0

0

.

5

1

.

0

x

E

p

a

K

(

x

)

Figura 2.13: Locpol de equivKernel

38 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

3 2 1 0 1 2 3

0

.

5

0

.

0

0

.

5

1

.

0

x

E

p

a

K

(

x

)

Figura 2.14: Locpol de equivKernel

3 2 1 0 1 2 3

0

.

5

0

.

0

0

.

5

1

.

0

x

E

p

a

K

(

x

)

Figura 2.15: Locpol de equivKernel

2.3. LIBRO LOCPOL 39

Funci on KernelChars

Descripcion: para un determinado n ucleo devuelve algunos de los valores numeri-

cos mas com unmente utilizados para funciones relacionadas con ellos.

Funciones: aqu tenemos las mismas que en el punto 2.2.1.

-- RK(K)

-- RdK(K)

-- mu2K(K)

-- mu0K(K)

-- K4(K)

-- dom(K)

Valor devuelto por las funciones: estas funciones devuelven un valor numerico.

Ejemplo de uso:

> g <- function(kernels)

+ {

+ mu0 <- sapply(kernels,function(x) computeMu0(x,))

+ mu0.ok <- sapply(kernels,mu0K)

+ mu2 <- sapply(kernels,function(x) computeMu(2,x))

+ mu2.ok <- sapply(kernels,mu2K)

+ Rk.ok <- sapply(kernels,RK)

+ RK <- sapply(kernels,function(x) computeRK(x))

+ K4 <- sapply(kernels,function(x) computeK4(x))

+ res <- data.frame(mu0,mu0.ok,mu2,mu2.ok,RK,Rk.ok,K4)

+ res

+ }

> g(kernels=c(EpaK,gaussK,TriweigK,TrianK))

mu0 mu0.ok mu2 mu2.ok RK Rk.ok K4

1 1 1 0.2000000 0.200000 0.6000000 0.6000000 0.4337657

2 1 1 1.0000000 1.000000 0.2820948 0.2820948 0.1994711

40 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

3 1 1 0.1111111 0.111111 0.8158508 0.8158510 0.5879019

4 1 1 0.1666667 0.166667 0.6666667 0.6666670 0.4793655

Funci on kernelCte

Descripcion: estos son los valores en funcion del n ucleo y del grado del poli-

nomio local que se utilizan en la seleccion del ancho de banda, tal como se propone

en Fan y Gijbels, 1996.

Funciones:

cteNuK(nu,p,kernel,lower=dom(kernel)[[1]],upper=dom(kernel)[[2]],

subdivisions= 25)

adjNuK(nu,p,kernel,lower=dom(kernel)[[1]],upper=dom(kernel)[[2]],

subdivisions= 25)

donde:

p: es el grado del polinomio local a estimar.

Valor devuelto por las funciones: ambas funciones devuelven valores numeri-

cos.

Funci on Kernels

Descripcion: denicion de los n ucleos utilizados en la estimacion polinomial

local.

Funciones:

-- CosK(x)

-- EpaK(x)

-- Epa2K(x)

-- gaussK(x)

-- ...

2.3. LIBRO LOCPOL 41

Funci on locCteWeights

Descripcion: pesos asociados al estimador polinomial local de grado cero (o

grado uno, locLinWeightsC.

Funciones:

locCteWeightsC(x, xeval, bw, kernel, weig = rep(1, length(x)))

locLinWeightsC(x, xeval, bw, kernel, weig = rep(1, length(x)))

locWeightsEval(lpweig, y)

locWeightsEvalC(lpweig, y)

donde:

xeval: es un vector con los puntos de evaluacion de los pesos.

lpweig: son pesos (X

T

WX)

1X

T

W evaluados en la matriz xeval.

Valor devuelto por las funciones:

locCteWeightsC y locLinWeightsC devuelven una lista con dos componentes

que son:

den : estimacion de (n bw f(x))

p

+ 1.

locWeig : (X

T

WX)

1X

T

W evaluado en la matriz xeval.

locWeightsEvalC y locWeightsEval devuelven un vector con la estimacion. Y

realizan el producto matricial entre locWeig y y, para obtener la estimacion

dada por los puntos de xeval.

Ejemplo de uso:

> size <- 200

> sigma <- 0.25

42 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

> deg <- 1

> kernel <- EpaK

> bw <- .25

> xeval <- 0:100/100

> regFun <- function(x) x^3

> x <- runif(size)

> y <- regFun(x) + rnorm(x, sd = sigma)

> d <- data.frame(x, y)

> lcw <- locCteWeightsC(d$x, xeval, bw, kernel)$locWeig

> lce <- locWeightsEval(lcw, y)

> lceB <- locCteSmootherC(d$x, d$y, xeval, bw, kernel)$beta0

> mean((lce-lceB)^2)

[1] 1.582489e-32

> llw <- locLinWeightsC(d$x, xeval, bw, kernel)$locWeig

> lle <- locWeightsEval(llw, y)

> lleB <- locLinSmootherC(d$x, d$y, xeval, bw, kernel)$beta0

> mean((lle-lleB)^2)

[1] 5.319263e-32

Funci on locpol (caso 1)

Descripcion: formula para el calculo asociado la estimacion polinomial local.

Funcion:

locpol(formula,data,weig=rep(1,nrow(data)),bw=NULL,kernel=EpaK,deg=1,

xeval=NULL,xevalLen=100)

confInterval(x)

## S3 method for class locpol:

residuals(object,...)

## S3 method for class locpol:

fitted(object,deg=0,...)

## S3 method for class locpol:

2.3. LIBRO LOCPOL 43

summary(object,...)

## S3 method for class locpol:

print(x,...)

## S3 method for class locpol:

plot(x,...)

donde:

xevalLen: es la longitud de xeval si este no se especica.

Valor devuelto por la funcion: devuelve una lista que contiene entre otros

componentes los siguientes:

mf: modelo de marco para los datos y la formula.

data: hoja de datos con datos.

weig: vector de pesos para cada observaciones.

xeval: vector de puntos de evaluacion.

bw: suavizado de parametros, ancho de banda.

kernel: n ucleo usado, ver n ucleos.

kName: nombre del n ucleo, una cadena con el nombre del n ucleo.

deg: estimacion del grado (p) del polinomio local.

X,Y: nombre de los datos de la respuesta y de la covarianza. Tambien, se

utilizan en lpFit para el nombre de los datos ajustados.

residuals: residuos del polinomio local ajustado.

lpFit: hoja de datos con el ajuste polinomico local, que contiene la covariable,

la respuesta, la derivada estimada, la densidad estimada X y la estimacion de

la varianza.

44 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

Ejemplo de uso:

> N <- 250

> xeval <- 0:100/100

> ## ex1

> d <- data.frame(x = runif(N))

> d$y <- d$x^2 - d$x + 1 + rnorm(N, sd = 0.1)

> r <- locpol(y~x,d)

> plot(r)

> ## ex2

> d <- data.frame(x = runif(N))

> d$y <- d$x^2 - d$x + 1 + (1+d$x)*rnorm(N, sd = 0.1)

> r <- locpol(y~x,d)

> plot(r)

> ## length biased data !!

> d <- data.frame(x = runif(10*N))

> d$y <- d$x^2 - d$x + 1 + (rexp(10*N,rate=4)-.25)

> posy <- d$y[ whichYPos <- which(d$y>0) ];

> d <- d[sample(whichYPos, N,prob=posy,replace=FALSE),]

> rBiased <- locpol(y~x,d)

> r <- locpol(y~x,d,weig=1/d$y)

> plot(d)

> points(r$lpFit[,r$X],r$lpFit[,r$Y],type="l",col="blue")

> points(rBiased$lpFit[,rBiased$X],rBiased$lpFit[,rBiased$Y],type="l")

> curve(x^2 - x + 1,add=TRUE,col="red")

+

+

+

+

+

+

+

+

++

+

+

++

+

+

++

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

++++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

0.0 0.2 0.4 0.6 0.8 1.0

0

.5

0

.6

0

.7

0

.8

0

.9

1

.0

1

.1

95% Conf. Int. for xPoints

x

y

Figura 2.16: Locpol de locpol

1

2.3. LIBRO LOCPOL 45

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+ +

+

+

+

++

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

++

+

+

+

+

+

+

+

+

+

0.0 0.2 0.4 0.6 0.8 1.0

0

.4

0

.6

0

.8

1

.0

1

.2

1

.4

95% Conf. Int. for xPoints

x

y

Figura 2.17: Locpol de locpol

2

0.0 0.2 0.4 0.6 0.8 1.0

0

.5

1

.0

1

.5

2

.0

x

y

Figura 2.18: Locpol de locpol

3

0.0 0.2 0.4 0.6 0.8 1.0

0

.5

1

.0

1

.5

2

.0

x

y

Figura 2.19: Locpol de locpol

4

46 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

Funci on locpol (caso 2)

Descripcion: calcula directamente la estimacion polinomial local de la funcion

de regresion.

Funcion:

locCteSmootherC(x, y, xeval, bw, kernel, weig = rep(1, length(y)))

locLinSmootherC(x, y, xeval, bw, kernel, weig = rep(1, length(y)))

locCuadSmootherC(x, y, xeval, bw, kernel, weig = rep(1, length(y)))

locPolSmootherC(x, y, xeval, bw, deg, kernel, DET = FALSE,

weig = rep(1, length(y)))

looLocPolSmootherC(x, y, bw, deg, kernel, weig = rep(1, length(y)),

DET = FALSE)

donde:

DET: es el Booleano que se pide para calcular el calculo del determinante si

la matriz es X

T

WX.

Valor devuelto por las funciones: devuelven una hoja de datos cuyos com-

ponentes dan los puntos de la evaluacion, el estimador de regresion para la funcion

m(x) y sus derivadas en cada punto, y la estimacion de la densidad marginal de x

para el grado p + 1. Estos componentes estan dados por:

x: evaluacion de puntos.

beta0, beta1, beta2,...: estimacion de la i-esima derivada de la funcion de re-

gresion.

den: estimacion de (n bw f(x))

p

+ 1.

Ejemplo de uso:

> N <- 100

> xeval <- 0:10/10

> d <- data.frame(x = runif(N))

2.3. LIBRO LOCPOL 47

> d

> bw <- 0.125

> fx <- xeval^2 - xeval + 1

> fx

[1] 1.00 0.91 0.84 0.79 0.76 0.75 0.76 0.79 0.84 0.91 1.00

> ## Non random

> d$y <- d$x^2 - d$x + 1

> d$y

[1] 0.7612712 0.7559905 0.7522013 0.8848619 0.8160407 0.7507679 0.7964555

[8] 0.7856257 0.9741636 0.9471402 0.9154741 0.8486005 0.7595106 0.7562525

[15] 0.9431480 0.9800950 0.9716219 0.8589399 0.7505613 0.7940482 0.7525843

[22] 0.7895587 0.7531085 0.8553279 0.7591280 0.9631150 0.9631849 0.8603828

[29] 0.7903537 0.7556701 0.7860397 0.8094275 0.7536389 0.7867965 0.8181295

[36] 0.9376779 0.7546431 0.8301950 0.7556629 0.8893358 0.9162690 0.7812961

[43] 0.7538522 0.7552131 0.7965644 0.8778957 0.8928852 0.7509552 0.8604513

[50] 0.7935019 0.7500432 0.8074889 0.8835923 0.7947588 0.7504915 0.7627245

[57] 0.9235209 0.9114959 0.7629582 0.8350024 0.8640522 0.7598914 0.8609709

[64] 0.9384282 0.7897166 0.7922242 0.7500432 0.7503208 0.9851169 0.7852533

[71] 0.7550881 0.9455074 0.9149992 0.9838134 0.8332296 0.7501226 0.8569621

[78] 0.9153462 0.8034103 0.8810769 0.7504405 0.9838679 0.7711603 0.8152093

[85] 0.7521302 0.9085868 0.9313345 0.7854696 0.7500239 0.9594925 0.8544892

[92] 0.7874924 0.8297123 0.7909301 0.7507330 0.7631920 0.9656503 0.8223636

[99] 0.7850518 0.7722768

> cuest <- locCuadSmootherC(d$x, d$y ,xeval, bw, EpaK)

> cuest

x beta0 beta1 beta2 den

1 0.0 1.00 -1.00000e+00 2 0.02372248

2 0.1 0.91 -8.00000e-01 2 8.02909644

3 0.2 0.84 -6.00000e-01 2 23.31658125

4 0.3 0.79 -4.00000e-01 2 11.78540653

5 0.4 0.76 -2.00000e-01 2 38.67861685

6 0.5 0.75 1.93709e-16 2 35.01524608

7 0.6 0.76 2.00000e-01 2 28.50127243

8 0.7 0.79 4.00000e-01 2 6.56710512

9 0.8 0.84 6.00000e-01 2 19.20445392

10 0.9 0.91 8.00000e-01 2 8.74252631

11 1.0 1.00 1.00000e+00 2 0.01881323

48 CAP

ITULO 2. SOFTWARE DISPONIBLE EN R

> lpest2 <- locPolSmootherC(d$x, d$y , xeval, bw, 2, EpaK)

> lpest2

x beta0 beta1 beta2

1 0.0 1.00 -1.00000e+00 2

2 0.1 0.91 -8.00000e-01 2

3 0.2 0.84 -6.00000e-01 2

4 0.3 0.79 -4.00000e-01 2

5 0.4 0.76 -2.00000e-01 2

6 0.5 0.75 9.48996e-16 2

7 0.6 0.76 2.00000e-01 2

8 0.7 0.79 4.00000e-01 2

9 0.8 0.84 6.00000e-01 2

10 0.9 0.91 8.00000e-01 2

11 1.0 1.00 1.00000e+00 2

> print(cbind(x = xeval, fx, cuad0 = cuest$beta0, lp0 = lpest2$beta0,

cuad1 = cuest$beta1, lp1=lpest2$beta1))

x fx cuad0 lp0 cuad1 lp1

[1,] 0.0 1.00 1.00 1.00 -1.00000e+00 -1.00000e+00

[2,] 0.1 0.91 0.91 0.91 -8.00000e-01 -8.00000e-01

[3,] 0.2 0.84 0.84 0.84 -6.00000e-01 -6.00000e-01

[4,] 0.3 0.79 0.79 0.79 -4.00000e-01 -4.00000e-01

[5,] 0.4 0.76 0.76 0.76 -2.00000e-01 -2.00000e-01

[6,] 0.5 0.75 0.75 0.75 1.93709e-16 9.48996e-16

[7,] 0.6 0.76 0.76 0.76 2.00000e-01 2.00000e-01

[8,] 0.7 0.79 0.79 0.79 4.00000e-01 4.00000e-01

[9,] 0.8 0.84 0.84 0.84 6.00000e-01 6.00000e-01

[10,] 0.9 0.91 0.91 0.91 8.00000e-01 8.00000e-01

[11,] 1.0 1.00 1.00 1.00 1.00000e+00 1.00000e+00

> d$y <- d$x^2 - d$x + 1 + rnorm(d$x, sd = 0.1)

> d$y

[1] 0.6723636 0.8448013 0.6243922 0.8162543 0.7436355 0.6866786 0.7271204

[8] 0.8505989 1.0953380 0.9551620 0.8478272 0.9471580 0.8222345 0.7517749

[15] 0.9601393 1.0679246 1.1700375 0.7825367 0.6269945 0.7835987 0.7351159

[22] 0.8048367 0.6544773 0.9297912 0.7927135 1.0375346 1.1104370 0.7743744

[29] 0.7696472 0.7438772 0.8958657 0.8276265 0.7252702 0.8883434 0.6869968

[36] 0.8876989 0.9026008 0.8190183 0.9027349 0.6894363 0.9984543 0.8354297

[43] 0.6733276 0.6779314 0.7221547 0.8123858 0.8134340 0.8745750 0.8664553

2.3. LIBRO LOCPOL 49

[50] 0.8047627 0.8801028 0.6856138 0.9211008 0.8376500 0.7492864 0.5999255

[57] 0.8460743 1.0463443 0.6829823 0.8607412 0.9401312 0.7307411 0.6731402