Documente Academic

Documente Profesional

Documente Cultură

Analisis Parametrico y No Paramétrico

Încărcat de

gioyauroDrepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Analisis Parametrico y No Paramétrico

Încărcat de

gioyauroDrepturi de autor:

Formate disponibile

ANALISIS PARAMTRICO Y NO PARAMTRICO

Un parmetro, es un dato que es tomado como necesario para analizar o valorar

una situacin. A partir del parmetro, una determinada circunstancia puede

entenderse o situarse en perspectiva. Por ejemplo: Si nos basamos en los

parmetros habituales, resultar imposible comprender esta situacin, El

paciente est evolucionando de acuerdo a los parmetros esperados, Estamos

investigando pero no hay parmetros que nos permitan establecer una relacin

con el caso anterior, La actuacin del equipo en el torneo local es el mejor

parmetro para realizar un pronstico sobre su participacin en el campeonato

mundial.

La utilidad de los parmetros estadsticos se encuentra ante la dificultad para

manejar una gran cantidad de datos individuales de una misma poblacin. Este

tipo de parmetros permite obtener un panorama general de la poblacin y realizar

comparaciones y predicciones.

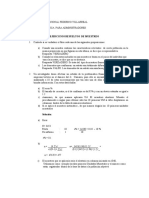

A continuacin se muestra una tabla en que se clasifican las variables como

paramtricas y no paramtricas:

Ejemplos de Variables

Variable

Genero

Comuna

dimensin

cdigo

Observaciones.

hombre

mujer

Variable nominal. El cdigo esta expresado

en nmero que no se puede sumar; son

excluyentes

Norte

sur

Poniente

Oriente

Sur Oriente

Variable nominal. Se ubica la comuna del

lugar de residencia y se asigna el cdigo

teniendo como base de clasificacin los

puntos cardinales para la comuna de

Santiago y empleados por el Sistema

Nacional de Servicios de Salud y de

Educacin.

Los cdigos no se suman;

edad

aos

Variable paramtrica u ordinal; el nmero

significa aos de edad; se puede sumar.

Notas

Nmero de 1 a 7

Variable ordinal. Los cdigos se pueden

sumar y cada valor tiene un significado

Colegio

Municipal

Particular

subvencionado

Particular

otro

Variable nominal o no paramtricas

PRUEBAS O ANALISIS PARAMTRICOS

Se llaman as porque su clculo implica una estimacin de los parmetros de la

poblacin con base en muestras estadsticas. Mientras ms grande sea la muestra

ms exacta ser la estimacin, mientras ms pequea, ms distorsionada ser la

media de las muestras por los valores raros extremos.

Son valores numricos dados.

Los anlisis paramtricos partes de los siguientes supuestos:

La distribucin poblacional de la variable dependiente es normal: el

universo tiene distribucin normal.

El nivel de medicin de las variables es por intervalos de razn.

Cuando dos o ms poblaciones son estudiadas, tienen una varianza

homognea: las poblaciones en cuestin poseen una dispersin similar en

sus distribuciones.

Como estos criterios son muy rigurosos, algunos investigadores slo basan sus

anlisis en el tipo de Hi y los niveles de medicin de las variables.

Las pruebas paramtricas ms utilizadas son (HFB2):

Coeficiente de correlacin de Pearson y regresin lineal.

Prueba t.

Prueba de contraste de las diferencias de proporciones.

Anlisis de varianza unidireccional (ANOVA en un solo sentido o oneway)

Anlisis de Varianza factorial (ANOVA)

Anlisis de covarianza (ANCOVA)

Descripcin. (Otra lista de pruebas paramtricas):

Prueba del valor Z de la distribucin normal

Prueba T de Student para datos relacionados (muestras dependientes)

Prueba T de Student para datos no relacionados (muestras independientes)

Prueba T de Student-Welch para dos muestras independientes con

varianzas no homogneas

Prueba de ji cuadrada de Bartlett para demostrar la homogeneidad de

varianzas

Prueba F (anlisis de varianza o ANOVA)

El coeficiente de Correlacin de Pearson (r)

Es una prueba estadstica para analizar la relacin entre dos variables medidas en

un nivel por intervalos o de razn.

Prueba Hi del tipo de A mayor X, mayor Y; A mayor X, menor Y; etc.

La prueba en si no considera a una como independiente y la otra como

dependiente, porque no evala la causalidad, solo la relacin mutua (correlacin).

El coeficiente se calcula a partir de las puntuaciones obtenidas en una muestra de

dos variables. Se relacionan las puntuaciones obtenidas de una variable con las

puntuaciones obtenidas de otra variable, en los mismos sujetos.

Regresin Lineal

Es modelo matemtico para estimar el efecto de una variable sobre otra. Est

asociado con el coeficiente r de Pearson.

Sirve para resolver Hi correlacionales y causales.

Mide variables de Intervalos y de razn.

La regresin lineal se determina con base al diagrama de dispersin. Este

consiste en una grfica donde se relacionan las puntuaciones de una muestra en

dos variables, como la de estatura y peso del ejemplo anterior.

Prueba t (paramtrica)

En estadstica, una prueba t de Student, prueba t-Student, o Test-T es cualquier

prueba en la que el estadstico utilizado tiene una distribucin t de Student si la

hiptesis nula es cierta. Se aplica cuando la poblacin se asume ser normal pero

el tamao muestral es demasiado pequeo como para que el estadstico en el que

est basada la inferencia est normalmente distribuido, utilizndose una

estimacin de la desviacin tpica en lugar del valor real.

En probabilidad y estadstica, la distribucin t (de Student) es una distribucin de

probabilidad que surge del problema de estimar la media de una poblacin

normalmente distribuida cuando el tamao de la muestra es pequeo.

Aparece de manera natural al realizar la prueba t de Student para la determinacin

de las diferencias entre dos medias muestrales y para la construccin del intervalo

de confianza para la diferencia entre las medias de dos poblaciones cuando se

desconoce la desviacin tpica de una poblacin y sta debe ser estimada a partir

de los datos de una muestra.

Es una prueba estadstica para evaluar si dos grupos difieren estadsticamente

entre s, de manera significativa respecto a sus medias (HFB384). Es una prueba

apropiada para comparar los promedios de dos grupos, y especialmente

apropiado como anlisis para el diseo experimental de solo postest de dos

grupos al azar.

Mide variables de intervalo o de razn.

El valor t se obtiene de muestras grandes mediante la frmula:

Anlisis de varianza unidireccional (ANOVA en un solo sentido o

oneway)

El objetivo principal de muchos experimentos consiste en determinar el efecto que

sobre alguna variable dependiente Y tienen distintos niveles de algn factor X

(variable independiente y discreta). El factor puede ser la temperatura, la empresa

que ha producido el bien, el da de la semana, etc. Esencialmente, el diseo para

el anlisis simple de la varianza consistir en obtener muestras aleatorias e

independientes del valor de Y asociado a cada uno de los distintos niveles del

factor X1, X2,..., Xn . Entonces podremos determinar si los diferentes niveles del

factor tienen un efecto significativo sobre el valor de la variable dependiente. El

funcionamiento de la tcnica ANOVA simple es, a grandes rasgos, el siguiente: a

fin de comparar las medias de Y asociadas a los distintos niveles del factor (X1,

X2,..., Xn), compararemos una medida de la variacin entre diferentes niveles

(MS-factor) con una medida de la variacin dentro de cada nivel (MS-error). Si el

MS-factor es significativamente mayor que el MS-error, concluiremos que las

medias asociadas a diferentes niveles del factor son distintas. Esto significa que el

factor influye significativamente sobre la variable dependiente Y. Si, por el

contrario, el MS-factor no es significativamente mayor que el MS-error, no

rechazaremos la hiptesis nula de que todas las medias, asociadas a diferentes

niveles del factor, coinciden.

Anlisis de Varianza factorial (ANOVA)

El procedimiento anlisis de la varianza nos permite contrastar la hiptesis nula de

que las medias de k grupos no difieren entre si ms all de lo que cabra esperar

por los efectos del azar. Este procedimiento nos permite adems realizar un

elevado nmero de pruebas posteriores con el fin de obtener la mxima

informacin posible sobre la relacin existente entre la variable independiente y la

dependiente.

Anlisis de covarianza (ANCOVA)

El anlisis de la covarianza o ANCOVA, acrnimo del ingls analysis of

covariance, es un modelo lineal general con una variable cuantitativa y uno o ms

factores. El ANCOVA es una fusin del ANOVA y de la regresin lineal mltiple. Es

un procedimiento estadstico que permite eliminar la heterogeneidad causada en

la variable de inters (variable dependiente) por la influencia de una o ms

variables cuantitativas (covariables). Bsicamente, el fundamento del ANCOVA es

un ANOVA al que a la variable dependiente se le ha eliminado el efecto predicho

por una o ms covariables por regresin lineal mltiple. La inclusin de covariables

puede aumentar la potencia estadstica porque a menudo reduce la variabilidad.

ANLISIS NO PARAMTRICOS

Se denominan pruebas no paramtricas aquellas que no presuponen una

distribucin de probabilidad para los datos, por ello se conocen tambin como de

distribucin libre (distribution free). En la mayor parte de ellas los resultados

estadsticos se derivan nicamente a partir de procedimientos de ordenacin y

recuento, por lo que su base lgica es de fcil comprensin. Cuando trabajamos

con muestras pequeas (n < 10) en las que se desconoce si es vlido suponer la

normalidad de los datos, conviene utilizar pruebas no paramtricas, al menos para

corroborar los resultados obtenidos a partir de la utilizacin de la teora basada en

la normal.

Aunque el trmino no paramtrico sugiere que la prueba no est basada en un

parmetro, hay algunas pruebas no paramtricas que dependen de un parmetro

tal como la media. Las pruebas no paramtricas, sin embargo, no requieren una

distribucin particular, de manera que algunas veces son referidas como pruebas

de libre distribucin. Aunque libre distribucin es una descripcin ms exacta, el

trmino no paramtrico es ms comnmente usado. Las siguientes son las

mayores ventajas y desventajas de los mtodos no paramtricos.

Ventajas de los Mtodos No Paramtricos

1. Los mtodos no paramtricos pueden ser aplicados a una amplia variedad

de situaciones porque ellos no tienen los requisitos rgidos de los mtodos

paramtricos correspondientes. En particular, los mtodos no paramtricos

no requieren poblaciones normalmente distribuidas.

2. Diferente a los mtodos paramtricos, los mtodos no paramtricos pueden

frecuentemente ser aplicados a datos no numricos, tal como el gnero de

los que contestan una encuesta.

3. Los

mtodos

no

paramtricos

usualmente

involucran

simples

computaciones que los correspondientes en los mtodos paramtricos y

son por lo tanto, ms fciles para entender y aplicar.

Desventajas de los Mtodos No Paramtricos

1. Los mtodos no paramtricos tienden a perder informacin porque datos

numricos exactos son frecuentemente reducidos a una forma cualitativa.

2. Las pruebas no paramtricas no son tan eficientes como las pruebas

paramtricas, de manera que con una prueba no paramtrica generalmente

se necesita evidencia ms fuerte (as como una muestra ms grande o

mayores diferencias) antes de rechazar una hiptesis nula.

Cuando los requisitos de la distribucin de una poblacin son satisfechos, las

pruebas no paramtricas son generalmente menos eficientes que sus contrapartes

paramtricas, pero la reduccin de eficiencia puede ser compensada por un

aumento en el tamao de la muestra.

Segn HFyB, Para realizar anlisis no paramtricos debe partirse de las siguientes

consideraciones:

La mayora de estos anlisis no requiere n de presupuestos acerca de la

forma de la distribucin poblacional. Aceptan distribuciones no normales.

Las variables no necesariamente deben estar medidas en un nivel para

intervalos o de razn, pueden analizar datos nominales u ordinales. De

hecho, si se quiere aplicar anlisis no paramtricos a datos de intervalos o

razn, stos deben ser resumidos a categoras discretas (a unas cuantas).

Las variables deben ser categricas.

Mtodos o pruebas estadsticas no paramtricas ms utilizados.

La ji cuadrada o x2

Los coeficientes de correlacin en independencia para tabulaciones

cruzadas.

Los coeficientes de correlacin por rangos ordenados de Spearman y

Kendall.

La ji Cuadrada o x2

En estadstica, la distribucin de Pearson, llamada tambin ji cuadrada(o) o chi

cuadrado(a) (), es una distribucin de probabilidad continua con un parmetro

que representa los grados de libertad de la variable aleatoria

Donde

son

variables

aleatorias normales independientes de media cero

y varianza uno. El que la variable aleatoria

representa habitualmente as:

tenga sta distribucin se

La distribucin tiene muchas aplicaciones en inferencia estadstica. La ms

conocida es la de la denominada prueba utilizada como prueba de

independencia y como prueba de bondad de ajuste y en la estimacin de

varianzas. Pero tambin est involucrada en el problema de estimar la media de

una poblacin normalmente distribuida y en el problema de estimar la pendiente

de una recta de regresin lineal, a travs de su papel en la distribucin t de

Student.

Aparece tambin en todos los problemas de anlisis de varianza por su relacin

con la distribucin F de Snedecor, que es la distribucin del cociente de dos

variables aleatorias independientes con distribucin .

Los coeficientes de correlacin en independencia para tabulaciones

cruzadas.

Este son otros coeficientes para evaluar si las variables incluidas en la tabla de

contingencia o tabulacin cruzada estn correlacionadas; algunos coeficientes son

los siguientes:

Phi, Coeficiente de contingencia o C de Pearson, V de Gramer, Lamdba , Gamma,

Tau-b de Kendall(Tau-b) , D de Somers, Eta. etc.

Coeficientes de Correlacin por Rangos Ordenados de Spearman y

Kendall

Los coeficientes rhoi de Spearman, simbolizado por rs, y tau de Kendall,

simbolizado como t, son medidas de correlacin para variables en un nivel de

medicin ordinal, de tal modo que los individuos u objetos de la muestra pueden

ordenarse

por

rangos

UNIVERSIDAD SAN CARLOS DE GUATEMALA

CENTRO UNIVERSITARIO DE PETEN (CUDEP)

SECCIN POPTN

ESTADISTICA

jerarquas.

ING. MARIO RIVERA

MTODOS DE ANALISIS DE DATOS PARAMTRICOS Y NO PARAMTRICOS

KAREN AMABILIA HICHO OROZCO

CARN: 201343773

LICENCIATURA EN TRABAJO SOCIAL

POPTN, PETN 08 DE MAYO 2016.

S-ar putea să vă placă și

- Pruebas ParamétricasDocument20 paginiPruebas ParamétricasRosmeri Navarro100% (1)

- Semana 11 Diseño Poblacion y MuestraDocument28 paginiSemana 11 Diseño Poblacion y MuestraElvis Sierra SolisÎncă nu există evaluări

- Fundamentos de Gestión y GerenciaDocument79 paginiFundamentos de Gestión y GerenciaAlex Arzubialde Zamalloa0% (1)

- Coeficiente de Correlación de Pearson y Spearman - Dr. Enrique SierraDocument30 paginiCoeficiente de Correlación de Pearson y Spearman - Dr. Enrique Sierraluisarriolaguillen89% (44)

- Libro La Investigación Científica y Laas Formas de TitulaciónDocument168 paginiLibro La Investigación Científica y Laas Formas de TitulaciónMaite Zabala100% (2)

- Ramas de La EstadisticaDocument5 paginiRamas de La EstadisticaItzel MartinezÎncă nu există evaluări

- Análisis de Datos CuantitativosDocument14 paginiAnálisis de Datos CuantitativosRubén PalaciosÎncă nu există evaluări

- Inves.2.8.3 (Pruebas Estadisticas Parametricas)Document9 paginiInves.2.8.3 (Pruebas Estadisticas Parametricas)Wendy NietoÎncă nu există evaluări

- Técnicas de Análisis de DatosDocument10 paginiTécnicas de Análisis de DatosJuanJoseAguilarPeña100% (1)

- Análisis de Varianza (ANOVADocument16 paginiAnálisis de Varianza (ANOVADaniel RodriguezÎncă nu există evaluări

- Diseño experimental y análisis de varianza (ANOVA) para contrastar la igualdad de varianzasDocument21 paginiDiseño experimental y análisis de varianza (ANOVA) para contrastar la igualdad de varianzasloraine morenoÎncă nu există evaluări

- Pruebas EstadIsticas Parametricas y No ParamEtricas WordDocument7 paginiPruebas EstadIsticas Parametricas y No ParamEtricas WordDiego Mellado100% (1)

- Proceso e Interpretacion Coeficiente de PearsonDocument8 paginiProceso e Interpretacion Coeficiente de PearsonLorena DelgadoÎncă nu există evaluări

- Las Pruebas EstadísticasDocument7 paginiLas Pruebas EstadísticasBetho CoronadoÎncă nu există evaluări

- Análisis paramétricos y pruebas estadísticas enDocument4 paginiAnálisis paramétricos y pruebas estadísticas enCarmen MedinaÎncă nu există evaluări

- Estudios viborantes: comparación de medias y proporcionesDocument6 paginiEstudios viborantes: comparación de medias y proporcionesCybertec CAÎncă nu există evaluări

- Interpretar resultados experimentalesDocument3 paginiInterpretar resultados experimentalesAna RodriguezÎncă nu există evaluări

- Clase 12 Mic 2021 Tecnicas para El Anális e Interpretación de DatosDocument24 paginiClase 12 Mic 2021 Tecnicas para El Anális e Interpretación de DatosJuana Karina Cobeñas TamaniÎncă nu există evaluări

- Prueba No ParamétricasDocument20 paginiPrueba No Paramétricasmaiorme1Încă nu există evaluări

- Reusmen Capitulo 15Document6 paginiReusmen Capitulo 15Kevin BriceñoÎncă nu există evaluări

- Análisis de La VarianzaDocument20 paginiAnálisis de La VarianzaGerman RiveraÎncă nu există evaluări

- Glosario de Analisis EstadisticoDocument22 paginiGlosario de Analisis EstadisticoAlfonso Caracuel RomeroÎncă nu există evaluări

- Analisis Parametrico y No ParametricoDocument7 paginiAnalisis Parametrico y No ParametricoLuis PerezÎncă nu există evaluări

- ESTADISTICA Analisis Parametricos y No ParametricosDocument19 paginiESTADISTICA Analisis Parametricos y No Parametricosalberto rojasÎncă nu există evaluări

- Informe AnovaDocument11 paginiInforme AnovaJani LagosÎncă nu există evaluări

- Analisis Parametricos y No ParametricosDocument19 paginiAnalisis Parametricos y No ParametricosHarold VargasÎncă nu există evaluări

- Tarea 4Document8 paginiTarea 4Alex ZamoraÎncă nu există evaluări

- Análisis de varianza (ANOVA) enDocument12 paginiAnálisis de varianza (ANOVA) enHarold La Fuente PalominoÎncă nu există evaluări

- Investigación - PRUEBAS DE LA SIGNIFICACIÓN PARA LA REGRESIÓN LINEALDocument7 paginiInvestigación - PRUEBAS DE LA SIGNIFICACIÓN PARA LA REGRESIÓN LINEALMARIA JOSE SOLIS DURANÎncă nu există evaluări

- Act 8 Unidad 5 Estadistica Inferencial 4to TrimestreDocument7 paginiAct 8 Unidad 5 Estadistica Inferencial 4to TrimestreMiriel AlejandraÎncă nu există evaluări

- Estadística AplicadaDocument4 paginiEstadística AplicadafiorellaÎncă nu există evaluări

- Pruebas Paramã - Tricas o de Comparaciã - NDocument22 paginiPruebas Paramã - Tricas o de Comparaciã - NEstrella ToralÎncă nu există evaluări

- PruebasHipótesisComparaciónMuestrasDocument6 paginiPruebasHipótesisComparaciónMuestrasGilberto Efren Rodriguez LomeliÎncă nu există evaluări

- Analisis Sensorial (METODOS ESTADISTICOS)Document8 paginiAnalisis Sensorial (METODOS ESTADISTICOS)Angiie DilÎncă nu există evaluări

- Inferencial, Chi CuadradaDocument3 paginiInferencial, Chi CuadradaGabriela Isabel Roca MenesesÎncă nu există evaluări

- INTRODUCCIÓNDocument8 paginiINTRODUCCIÓNLiyiPaterninaÎncă nu există evaluări

- Estadísticos PDFDocument5 paginiEstadísticos PDFJavierÎncă nu există evaluări

- Parametric AsDocument73 paginiParametric Asalfredo RamirezÎncă nu există evaluări

- Supuestos Análisis de La VarianzaDocument6 paginiSupuestos Análisis de La Varianzaestadistico17100% (1)

- Los Test EstadísticosDocument16 paginiLos Test EstadísticosSonia MamaniÎncă nu există evaluări

- Trabajo Isra 22Document8 paginiTrabajo Isra 22Yhonatan Arias JaimesÎncă nu există evaluări

- Tarea 6Document8 paginiTarea 6Abreu AbreuÎncă nu există evaluări

- Informe - ANOVADocument2 paginiInforme - ANOVAcarlosÎncă nu există evaluări

- Resumen de Algunos Temas de Metodología de La Investigación Social III (Cohen)Document4 paginiResumen de Algunos Temas de Metodología de La Investigación Social III (Cohen)Federico AbiusoÎncă nu există evaluări

- Cuestionario AnovaDocument5 paginiCuestionario AnovaDhayanara Abilia Cardenas HuamanÎncă nu există evaluări

- Apuntes Con DefinicionesDocument49 paginiApuntes Con DefinicionesSera LopezÎncă nu există evaluări

- Analisis de La Varianza FinalDocument19 paginiAnalisis de La Varianza Finalpaloma100% (1)

- Tcuadrado PDFDocument17 paginiTcuadrado PDFDaniel Fernando Juarez SandovalÎncă nu există evaluări

- Técnicas de AnálisisDocument5 paginiTécnicas de AnálisisAndres AristizabalÎncă nu există evaluări

- Pruebas Paramétricas 25 10 21Document4 paginiPruebas Paramétricas 25 10 21Kevin S. LucasÎncă nu există evaluări

- Examen MultivarianteDocument12 paginiExamen MultivariantePablo Fernández CarballeiraÎncă nu există evaluări

- MTG ResumenPruebasHipótesisNoParamétricasDocument15 paginiMTG ResumenPruebasHipótesisNoParamétricasMaggie TretoÎncă nu există evaluări

- Estimación Puntual y Por IntervalosDocument8 paginiEstimación Puntual y Por IntervalosJorge Luis LlerenaÎncă nu există evaluări

- Metodos ParametricosDocument13 paginiMetodos ParametricosBrandon Barrera CruzadoÎncă nu există evaluări

- GLOSARIO DE ESTADÍSTICAS UpelDocument9 paginiGLOSARIO DE ESTADÍSTICAS UpeldiazalemarÎncă nu există evaluări

- Expo BioestadisticaDocument14 paginiExpo BioestadisticaAnthony Fernando Arias MaldonadoÎncă nu există evaluări

- ANOVA-UN-FACTORDocument13 paginiANOVA-UN-FACTORJonnathan Javier Tene PuchaycelaÎncă nu există evaluări

- ¿Qué Es Un Modelo Estadístico LinealDocument5 pagini¿Qué Es Un Modelo Estadístico LinealJose Alberto Sobrino MarÎncă nu există evaluări

- Estadística No ParametricaDocument8 paginiEstadística No ParametricaJoana Sarahi Aguilar RomeroÎncă nu există evaluări

- Diferencias Significativas de MuestrasDocument10 paginiDiferencias Significativas de MuestrasmatildecesariÎncă nu există evaluări

- Introducción A Las Ciencias PolíticasDocument10 paginiIntroducción A Las Ciencias PolíticasgioyauroÎncă nu există evaluări

- Educación Integral y SexualidadDocument1 paginăEducación Integral y SexualidadgioyauroÎncă nu există evaluări

- Caso de Procesal PenalDocument5 paginiCaso de Procesal PenalgioyauroÎncă nu există evaluări

- Ciencias PolíticasDocument2 paginiCiencias PolíticasgioyauroÎncă nu există evaluări

- El FuncionalismoDocument30 paginiEl FuncionalismogioyauroÎncă nu există evaluări

- Estructura Del Estado de GuatemalaDocument9 paginiEstructura Del Estado de Guatemalagioyauro77% (13)

- Movimiento FeministaDocument14 paginiMovimiento FeministagioyauroÎncă nu există evaluări

- Presupuesto Del Gobierno PDFDocument173 paginiPresupuesto Del Gobierno PDFJulio Antonio LópezÎncă nu există evaluări

- El FuncionalismoDocument30 paginiEl FuncionalismogioyauroÎncă nu există evaluări

- Cláusula Arbitral PDFDocument1 paginăCláusula Arbitral PDFgioyauroÎncă nu există evaluări

- T.penal UrgenteDocument37 paginiT.penal UrgentegioyauroÎncă nu există evaluări

- Diferencia Entre Proceso y Procedimiento-Tarea 1-1Document2 paginiDiferencia Entre Proceso y Procedimiento-Tarea 1-1gioyauroÎncă nu există evaluări

- Diferencia Juicios Ejecutivos Comun y Via de ApremioDocument6 paginiDiferencia Juicios Ejecutivos Comun y Via de ApremiogioyauroÎncă nu există evaluări

- Principios Generales Del Derecho NotarialDocument6 paginiPrincipios Generales Del Derecho NotarialgioyauroÎncă nu există evaluări

- Temario Oral de Derecho Procesal Civil y Mercantil PDFDocument123 paginiTemario Oral de Derecho Procesal Civil y Mercantil PDFgioyauroÎncă nu există evaluări

- El Plan de Dios para Los Matrimonios y El Hogar Por Willie AlvarengaDocument85 paginiEl Plan de Dios para Los Matrimonios y El Hogar Por Willie AlvarengaHelga de Matie100% (1)

- Temario Oral de Derecho Procesal Civil y Mercantil PDFDocument123 paginiTemario Oral de Derecho Procesal Civil y Mercantil PDFgioyauroÎncă nu există evaluări

- Que Es La InterpelacionDocument5 paginiQue Es La InterpelaciongioyauroÎncă nu există evaluări

- Modulo 3 Regresion LinealDocument8 paginiModulo 3 Regresion LinealRamiro C CruzÎncă nu există evaluări

- Reforzamiento Examen ParcialDocument5 paginiReforzamiento Examen ParcialAndree JaraÎncă nu există evaluări

- EJERCICIOSDocument5 paginiEJERCICIOSFabian arrieta comasÎncă nu există evaluări

- Practica Dirigida de Pronostico UCDocument3 paginiPractica Dirigida de Pronostico UCBrayan Ccari LindoÎncă nu există evaluări

- Actividad 5 EstadisticaDocument11 paginiActividad 5 EstadisticaPaola Marcela Urueña MartinezÎncă nu există evaluări

- Diseño de Experimentos-Evidenica 3Document7 paginiDiseño de Experimentos-Evidenica 3Reynaldo GutiérrezÎncă nu există evaluări

- Intervalos de Confianza para Una PoblaciónDocument37 paginiIntervalos de Confianza para Una PoblaciónOver MarzolaÎncă nu există evaluări

- Análisis de diseño experimental sobre pérdida de peso de frutasDocument10 paginiAnálisis de diseño experimental sobre pérdida de peso de frutasmarcelaÎncă nu există evaluări

- Taller Clase 16Document2 paginiTaller Clase 16Camilo MolinaÎncă nu există evaluări

- PREIMERA ACTIVIDAD ConsultaDocument11 paginiPREIMERA ACTIVIDAD ConsultaLILIANA A. RESTREPOÎncă nu există evaluări

- MuestreoEstadísticoDocument9 paginiMuestreoEstadísticojequite55100% (2)

- Ejercicios de Diseños Factoriales Nicol Ruiz y Andres DelgadoDocument13 paginiEjercicios de Diseños Factoriales Nicol Ruiz y Andres DelgadoANDRES DAVID DELGADO ALDANAÎncă nu există evaluări

- Formulario Estadística AvanzadaDocument2 paginiFormulario Estadística AvanzadaRoger FloresÎncă nu există evaluări

- Experimentos Generales de Un Solo FactorDocument44 paginiExperimentos Generales de Un Solo FactorDebbie GarcíaÎncă nu există evaluări

- Ejercicios Resueltos de MuestreoDocument5 paginiEjercicios Resueltos de MuestreoDAMARIS100% (1)

- Ejercicios de Diseños Experimentales de BloquesDocument5 paginiEjercicios de Diseños Experimentales de BloquesEspinoza Beltrán Kathia Sarahí100% (1)

- Unidad I - Metodos EstadisticosDocument140 paginiUnidad I - Metodos EstadisticosFiorela SegoviaÎncă nu există evaluări

- Pregunta 3Document4 paginiPregunta 3Estefany Chamorro50% (2)

- Practica N°2 - Pronosticos EMRMDocument24 paginiPractica N°2 - Pronosticos EMRMManuel RiveraÎncă nu există evaluări

- Distribuciones MuestralesDocument26 paginiDistribuciones MuestralesAndrea PelaezÎncă nu există evaluări

- Tarea 9 ANOVA ResueltaDocument20 paginiTarea 9 ANOVA ResueltaNaye EfronÎncă nu există evaluări

- Correlación de Pearson y SpearmanDocument35 paginiCorrelación de Pearson y SpearmannoeÎncă nu există evaluări

- Confiabilidad y Validez de Redes SocialesDocument12 paginiConfiabilidad y Validez de Redes SocialesWaldo Calderon BulnesÎncă nu există evaluări

- Monografia ZikaDocument3 paginiMonografia ZikaDianaHuachacaCorneteroÎncă nu există evaluări

- Prueba de Hipótesis T-StudentDocument15 paginiPrueba de Hipótesis T-StudentErnesto NerioÎncă nu există evaluări

- Guia de Eta CuadradoDocument6 paginiGuia de Eta CuadradoRUIZ JORGEÎncă nu există evaluări

- Gelatina Sabor YogurtDocument61 paginiGelatina Sabor YogurtKellyVictorioÎncă nu există evaluări

- 1er ExamenDocument9 pagini1er ExamenJACK ANGEL RUBEN SALVATIERRA CACERESÎncă nu există evaluări

- Ago 30-20 Taller 2 Medidas de Dispersión y Asimetría PDFDocument9 paginiAgo 30-20 Taller 2 Medidas de Dispersión y Asimetría PDFJUAN TAPASCOÎncă nu există evaluări

- Análisis e Interpretación de DatosDocument17 paginiAnálisis e Interpretación de DatosrosarioÎncă nu există evaluări