Documente Academic

Documente Profesional

Documente Cultură

Cadena de Markov en Tiempo Discreto

Încărcat de

Gricelda Prado Ordonez0 evaluări0% au considerat acest document util (0 voturi)

26 vizualizări5 paginiUna cadena de Markov es un proceso estocástico con un número finito de estados con probabilidades de transición estacionarias, es decir, si se conoce la historia del sistema hasta su instante actual, su estado presente resume toda la información relevante para describir en probabilidad su estado futuro.

Drepturi de autor

© © All Rights Reserved

Formate disponibile

DOCX, PDF, TXT sau citiți online pe Scribd

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentUna cadena de Markov es un proceso estocástico con un número finito de estados con probabilidades de transición estacionarias, es decir, si se conoce la historia del sistema hasta su instante actual, su estado presente resume toda la información relevante para describir en probabilidad su estado futuro.

Drepturi de autor:

© All Rights Reserved

Formate disponibile

Descărcați ca DOCX, PDF, TXT sau citiți online pe Scribd

0 evaluări0% au considerat acest document util (0 voturi)

26 vizualizări5 paginiCadena de Markov en Tiempo Discreto

Încărcat de

Gricelda Prado OrdonezUna cadena de Markov es un proceso estocástico con un número finito de estados con probabilidades de transición estacionarias, es decir, si se conoce la historia del sistema hasta su instante actual, su estado presente resume toda la información relevante para describir en probabilidad su estado futuro.

Drepturi de autor:

© All Rights Reserved

Formate disponibile

Descărcați ca DOCX, PDF, TXT sau citiți online pe Scribd

Sunteți pe pagina 1din 5

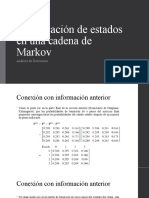

CLASIFICACIN DE ESTADOS DE UNA CADENA DE MARKOV EN

TIEMPO DISCRETO

DEFINICIN DE CADENA DE MARKOV

Una cadena de Markov es un proceso estocstico con un nmero

finito de estados con probabilidades de transicin estacionarias,

es decir, si se conoce la historia del sistema hasta su instante

actual, su estado presente resume toda la informacin relevante

para describir en probabilidad su estado futuro.

Una cadena de Markov es una secuencia X1, X2, X3,..., de variables

aleatorias. El rango de estas variables, es llamado espacio

estado, el valor de Xn es el estado del proceso en el tiempo n. Si

la distribucin de probabilidad condicional de Xn+1 en estados

pasados es una funcin de Xn por si sola, entonces:

Prob{Xn+1=j|X0=k0, X1=k1, ..., Xn-1=kn-1, Xn=i}= Prob{Xn+1=j|Xt=1}

Donde Xi es el estado del proceso en el instante i. La identidad

mostrada es la Propiedad de Markov.

Algunos resultados tericos que tienen relacin con la existencia

y clculo de una distribucin para la Cadena de Markov en el largo

plazo (conocida tambin como distribucin estacionaria).

Previamente, se enumeran algunas definiciones que clasifican los

estados de una cadena. Para ello consideraremos el ejemplo que

utilizamos para introducir una Cadena de Markov en Tiempo

Discreto, asumiendo la probabilidad de lluvia al inicio (y final

del da) en un 20% (p=0,2). El grafo que resume las probabilidades

de transicin es el siguiente:

Clasificacin de Estados de una Cadena de Markov

Un estado j se dice accesible desde el estado i ssi para algn n:

Lo anterior implica que existe una probabilidad no nula que

comenzando en el estado i se puede llegar al estado j al cabo de n

etapas. En nuestro ejemplo el estado 2 es accesible desde el

estado 0 (dado que desde 0 se puede acceder a 1 y desde 1 se puede

acceder a 2). Es trivial demostrar en este contexto que el estado

2 es accesible desde 1 (como tambin 1 lo es desde 2).

Adicionalmente si tanto el estado i es accesible desde j como

viceversa decimos que los estados i y j se comunican. Notar que 1

es accesible desde 0 (como 0 tambin es accesible desde 1) por

tanto 0 y 1 se comunican. Tambin es posible demostrar que 1 y 2

se comunican. Luego por transitividad el estado 0 y 2 se

comunican. Lo anterior deja en evidencia que en el ejemplo todos

los estados se comunican entre s, por lo cual pertenecen a la

misma clase de estados. Una cadena es irreducible si tiene una

nica clase de estados.

Un estado se dice que tiene periodo d, para el mayor valor del

entero d que cumple:

Slo para valores de n pertenecientes al conjunto {d, 2d, 3d, .}.

Si d=1 decimos que el estado es aperidico. En otras palabras, un

estado es peridico si, partiendo de ese estado, slo es posible

volver a l en un nmero de etapas que sea mltiplo de un cierto

nmero entero mayor que uno. En el ejemplo se puede volver a cada

estado con probabilidad no nula al cabo de una etapa, condicin

suficiente (pero no necesaria) para afirmar que los estados

son aperidicos.

Se denota por Fk(i,i) la probabilidad de que el proceso retorne al

estado i por primera vez al cabo de k etapas. De modo que:

Es la probabilidad que partiendo en i, el proceso regrese al

estado i alguna vez. SiF(i,i)=1 se dice que el estado

es recurrente (en caso contrario, es decir, F(i,i)<1, el estado

es transciente). La demostracin matemtica de que un estado es

recurrente no resulta siempre trivial, no obstante en el ejemplo

estamos frente a una cadena irreducible con un nmero finito de

estados, por tanto dichos estados son recurrentes positivos. El

concepto de recurrente positivo se refiere a que el valor esperado

del nmero de etapas que le toma al proceso volver al estado i por

primera vez, partiendo del estado i es un nmero finito.

ELEMENTOS Y PROPIEDADES DE LAS CADENAS DE MARKOV

Toda cadena de Markov tiene los siguientes elementos:

Un conjunto finito de M estados, exhaustivos y mutuamente

excluyentes (ejemplo: estados de la enfermedad)

Ciclo de markov (paso) : periodo de tiempo que sirve de base

para examinar las transiciones entre estados (ejemplo, un mes)

Probabilidades de transicin entre estados, en un ciclo (matriz P)

Distribucin inicial del sistema entre los M estados posibles.

Toda cadena de Markov cumple con las siguientes propiedades:

Propiedad Markoviana:

Un proceso estocstico tiene la propiedad markoviana si las

probabilidades de transicin en un paso slo dependen del estado

del sistema en el perodo anterior (memoria limitada).

P{Xt+1=j| Xt=i}=Pij

Las probabilidades son estacionarias:

P{Xt+1=j| Xt=i}=P{X1=j|X0=i}=Pij

P{Xt+n=j| Xt=i}=P{Xn=j|X0=i}=Pij^(n)

Existe un conjunto de probabilidades iniciales:

P{X0=i}

Existe una matriz de transicin:

La matriz de transicin es aquella que contiene todas las

probabilidades de transicin.

Las probabilidades de transicin indican la probabilidad de que

partiendo de un estado i se llegue al estado j en n perodos.

P(n)es la matriz de transicin en n pasos, de orden (M+1)x(M+1)

Clculo de Probabilidades de Transicin en n pasos:

Clculo de Vector de Probabilidades no condicionadas

S-ar putea să vă placă și

- Mapeo de ProcesosDocument60 paginiMapeo de ProcesosJesusGSASG100% (2)

- Cadenas de MarkovDocument17 paginiCadenas de MarkovOskarSanchezÎncă nu există evaluări

- Cadenas de Markov 2010 IIDocument129 paginiCadenas de Markov 2010 IIroberto1809100% (3)

- Cadenas de MarkovDocument50 paginiCadenas de Markovjuanvega1234550% (2)

- Cadenas de MarkovDocument6 paginiCadenas de MarkovCindy J Lauper100% (1)

- Cadenas de Markov PDFDocument6 paginiCadenas de Markov PDFMayra Serrano100% (1)

- Inv - Ope.2 - UNIDAD IVDocument22 paginiInv - Ope.2 - UNIDAD IVJonathan Millan RodríguezÎncă nu există evaluări

- Cadenas de MárkovDocument10 paginiCadenas de MárkovEzdine ViescaÎncă nu există evaluări

- Curso Gratuito Formacion de Capacitadores CertificadosDocument102 paginiCurso Gratuito Formacion de Capacitadores CertificadosCarlos RiveraÎncă nu există evaluări

- Clasificación de Estados de Una Cadena de Markov en Tiempo DiscretoDocument5 paginiClasificación de Estados de Una Cadena de Markov en Tiempo DiscretoGricelda Prado OrdonezÎncă nu există evaluări

- Cadenas de Markov Act1 Tema 4Document8 paginiCadenas de Markov Act1 Tema 4Papeleria vatisÎncă nu există evaluări

- Problemas Resueltos Cadenas de MarkovDocument7 paginiProblemas Resueltos Cadenas de MarkovPaco Zavala100% (1)

- Inves RochaDocument12 paginiInves RochaJesus PerezÎncă nu există evaluări

- Cadenas MarkovDocument51 paginiCadenas MarkovYsmar Laisney Lucena Perdomo0% (2)

- Cadenas de MarkovDocument2 paginiCadenas de Markovgeo2805Încă nu există evaluări

- Carlos CuetoDocument5 paginiCarlos CuetoCarlos Cueto RìosÎncă nu există evaluări

- Cadenas MarkovDocument14 paginiCadenas MarkovAdriana SuarezÎncă nu există evaluări

- Cadenas de Markov (Resumen)Document6 paginiCadenas de Markov (Resumen)Anonymous gR34gQÎncă nu există evaluări

- Cadenas de MarkovDocument21 paginiCadenas de MarkovangieebiirofbÎncă nu există evaluări

- Trabajo Investigación Investigación de Operaciones 2Document14 paginiTrabajo Investigación Investigación de Operaciones 2Marco CastañazaÎncă nu există evaluări

- Cadena Markov PDFDocument10 paginiCadena Markov PDFManuel VásquezÎncă nu există evaluări

- Actividad 9 - Cadenas de Markov - Carlos Agustin Hernandez HernandezDocument5 paginiActividad 9 - Cadenas de Markov - Carlos Agustin Hernandez HernandezCarlos HernandezÎncă nu există evaluări

- Cadenas de Marko-ResumenDocument16 paginiCadenas de Marko-ResumenArturo CLorcaÎncă nu există evaluări

- Modelos Estocasticos Markov ContinuoDocument18 paginiModelos Estocasticos Markov ContinuoJose Manuel Hernandez CarratalaÎncă nu există evaluări

- Procesos de Markov PDFDocument3 paginiProcesos de Markov PDFDanny MartínezÎncă nu există evaluări

- Unidad 4 y 5Document43 paginiUnidad 4 y 5Karla LiceaÎncă nu există evaluări

- CADENAS DE MARKOV Matrices de Transición de N PasosDocument20 paginiCADENAS DE MARKOV Matrices de Transición de N PasosIngrid Carolina Sanchez RamirezÎncă nu există evaluări

- Cadenas de MarkovDocument6 paginiCadenas de MarkovDaniel Ordaz AlvarezÎncă nu există evaluări

- Modelo de MarkovDocument105 paginiModelo de MarkovEliezer VerasÎncă nu există evaluări

- 8 - Cadenas de Markov P2Document37 pagini8 - Cadenas de Markov P2Jimmy ButtonÎncă nu există evaluări

- Tecnológico Nacional de México: PeríodoDocument20 paginiTecnológico Nacional de México: PeríodoWendy Estefania Saldivar CuervoÎncă nu există evaluări

- 2 Cadenas de MarkovDocument43 pagini2 Cadenas de MarkovgustavobenitesÎncă nu există evaluări

- Eduardo - Cristian U3 Parte 1 - Cadenas MarkovDocument14 paginiEduardo - Cristian U3 Parte 1 - Cadenas MarkovEduardo LesseyÎncă nu există evaluări

- Cadena de MarkovDocument27 paginiCadena de MarkovLeo MessiÎncă nu există evaluări

- Aio5b.4.1 Cadenas de MarkovDocument6 paginiAio5b.4.1 Cadenas de MarkovGera NavaÎncă nu există evaluări

- Aplicaciones y Técnicas en El Uso de MarkovDocument10 paginiAplicaciones y Técnicas en El Uso de MarkovReyna Cristina Chucuya ApazaÎncă nu există evaluări

- Trabajo de Procesos Estocásticos IIIDocument10 paginiTrabajo de Procesos Estocásticos IIILening SegoviaÎncă nu există evaluări

- Paper Cadenas ErgódicasDocument5 paginiPaper Cadenas ErgódicasRomario AguirreÎncă nu există evaluări

- CLASE 2 OpDocument13 paginiCLASE 2 OpFlor Chilla VillaltaÎncă nu există evaluări

- Análisis de MacdonaldDocument5 paginiAnálisis de MacdonaldJohan ArjonaÎncă nu există evaluări

- Cadenas de MarkovDocument5 paginiCadenas de MarkovAlx GarciaÎncă nu există evaluări

- 4.1 Fernandez Lopez AdrianDocument12 pagini4.1 Fernandez Lopez AdrianAdrian FernandezÎncă nu există evaluări

- Cadena de Markov1Document7 paginiCadena de Markov1anon_615179342Încă nu există evaluări

- Tarea 2 IO2Document6 paginiTarea 2 IO2Marco CastañazaÎncă nu există evaluări

- E3T1 Coronado López Alejandra MarcelaDocument8 paginiE3T1 Coronado López Alejandra MarcelaALEJANDRA MARCELA CORONADO LOPEZÎncă nu există evaluări

- Conceptos P2 - IO2Document4 paginiConceptos P2 - IO2Franco Stark DiuwÎncă nu există evaluări

- Qué EsDocument96 paginiQué EsFelix Americo QuispeÎncă nu există evaluări

- CADENAS DE MARKOV (1) .En - EsDocument14 paginiCADENAS DE MARKOV (1) .En - EsKevin FloresÎncă nu există evaluări

- Clase6 IOCadenasMarkovDocument36 paginiClase6 IOCadenasMarkovJuan Paredes Campos0% (1)

- Probabilidad de Transicion Estacionaria de Estados Estables EsthelaDocument6 paginiProbabilidad de Transicion Estacionaria de Estados Estables EsthelaJefr FloresÎncă nu există evaluări

- ActExtra - U4 Rodriguez Santiago Pedro AlejandroDocument16 paginiActExtra - U4 Rodriguez Santiago Pedro AlejandroPEDRO ALEJANDRO RODRIGUEZ SANTIAGOÎncă nu există evaluări

- Clasificación de Estados en Una Cadena de MarkovDocument45 paginiClasificación de Estados en Una Cadena de MarkovPAOLA TAPIA DUARTEÎncă nu există evaluări

- Cadena de Markov Ejerciciodocx PDFDocument26 paginiCadena de Markov Ejerciciodocx PDFPaolaÎncă nu există evaluări

- La Cadena de MarkovDocument13 paginiLa Cadena de MarkovMarlonmitchel Guevara CarrascoÎncă nu există evaluări

- Cadema MarkovDocument22 paginiCadema Markovxabok41698Încă nu există evaluări

- Cadenas de Markov 12Document40 paginiCadenas de Markov 12Astrid SandovalÎncă nu există evaluări

- Cadenas de MarkovDocument10 paginiCadenas de MarkovLUIS EMANUEL RAMOS ARZATEÎncă nu există evaluări

- Procesos Estocásticos 2019 PDFDocument56 paginiProcesos Estocásticos 2019 PDFstephanie leivaÎncă nu există evaluări

- Teoria Sobre El Proyecto de Cadenas de MarkovDocument6 paginiTeoria Sobre El Proyecto de Cadenas de MarkovWilmar RØdriguezÎncă nu există evaluări

- Plantilla para Investigación - Cadenas Ergódicas de MarkovDocument5 paginiPlantilla para Investigación - Cadenas Ergódicas de MarkovDavid RojasÎncă nu există evaluări

- 3B CuadernilloDocument81 pagini3B CuadernilloGricelda Prado OrdonezÎncă nu există evaluări

- Los Elementos de La MusicaDocument5 paginiLos Elementos de La MusicaGricelda Prado OrdonezÎncă nu există evaluări

- El Grabado en MéxicoDocument4 paginiEl Grabado en MéxicoGricelda Prado OrdonezÎncă nu există evaluări

- Rejillas en El Tratamiento Primario de Aguas ResidualesDocument13 paginiRejillas en El Tratamiento Primario de Aguas ResidualesGricelda Prado OrdonezÎncă nu există evaluări

- Capacidad de CargaDocument4 paginiCapacidad de CargaGricelda Prado OrdonezÎncă nu există evaluări

- Rejillas en El Tratamiento Primario de Aguas ResidualesDocument13 paginiRejillas en El Tratamiento Primario de Aguas ResidualesGricelda Prado OrdonezÎncă nu există evaluări

- Arte Del Antiguo EgiptoDocument30 paginiArte Del Antiguo EgiptoGricelda Prado OrdonezÎncă nu există evaluări

- Antecedentes Del Comportamiento Del Consumidor MexicanoDocument5 paginiAntecedentes Del Comportamiento Del Consumidor MexicanoGricelda Prado OrdonezÎncă nu există evaluări

- Cuento de PinochoDocument4 paginiCuento de PinochoCatalina GonsalesÎncă nu există evaluări

- El Grabado en MéxicoDocument4 paginiEl Grabado en MéxicoGricelda Prado OrdonezÎncă nu există evaluări

- El Grabado de Europa A AméricaDocument2 paginiEl Grabado de Europa A AméricaGricelda Prado OrdonezÎncă nu există evaluări

- El Modelo Dicotómico de SaussureDocument3 paginiEl Modelo Dicotómico de SaussureGricelda Prado Ordonez100% (1)

- Importancia Del Comercio InternacionalDocument7 paginiImportancia Del Comercio InternacionalGricelda Prado OrdonezÎncă nu există evaluări

- Arte Del Antiguo EgiptoDocument30 paginiArte Del Antiguo EgiptoGricelda Prado OrdonezÎncă nu există evaluări

- Fiebre Por ChikungunyaDocument4 paginiFiebre Por ChikungunyaGricelda Prado OrdonezÎncă nu există evaluări

- Arte RococoDocument20 paginiArte RococoGricelda Prado OrdonezÎncă nu există evaluări

- El TabaquismoDocument5 paginiEl TabaquismoGricelda Prado OrdonezÎncă nu există evaluări

- La SemánticaDocument3 paginiLa SemánticaGricelda Prado OrdonezÎncă nu există evaluări

- Psicología de La Percepción de MensajesDocument2 paginiPsicología de La Percepción de MensajesGricelda Prado OrdonezÎncă nu există evaluări

- Comunicación VisualDocument4 paginiComunicación VisualGricelda Prado OrdonezÎncă nu există evaluări

- PresocraticosDocument6 paginiPresocraticosGricelda Prado OrdonezÎncă nu există evaluări

- Tipología Del ConsumidorDocument3 paginiTipología Del ConsumidorGricelda Prado OrdonezÎncă nu există evaluări

- Qué Son Las MiodesopsiasDocument2 paginiQué Son Las MiodesopsiasGricelda Prado OrdonezÎncă nu există evaluări

- El SidaDocument18 paginiEl SidaMichelle GenéÎncă nu există evaluări

- Las Emociones y Su Relación Con El ColorDocument4 paginiLas Emociones y Su Relación Con El ColorGricelda Prado OrdonezÎncă nu există evaluări

- Sistema Tipográfico de MedidasDocument5 paginiSistema Tipográfico de MedidasGricelda Prado OrdonezÎncă nu există evaluări

- Cachorro de León en SerbiaDocument2 paginiCachorro de León en SerbiaGricelda Prado OrdonezÎncă nu există evaluări

- SÁLPIDOSDocument2 paginiSÁLPIDOSGricelda Prado OrdonezÎncă nu există evaluări

- Academia Amantes Del Conocimiento: Ciclo Repaso San Marcos 2023 - IDocument11 paginiAcademia Amantes Del Conocimiento: Ciclo Repaso San Marcos 2023 - IDiego Dueñas VelardeÎncă nu există evaluări

- Timpanis MoDocument52 paginiTimpanis MoCris MartinezÎncă nu există evaluări

- Cebichería La FoquitaDocument3 paginiCebichería La Foquitalesly100% (3)

- Cadmo y HarmoníaDocument21 paginiCadmo y HarmoníaLorena SotoÎncă nu există evaluări

- Diseño Y Operación de Un Aero Refrigerador Adiabático: Alumno: Alejandro Pérez VerdúDocument126 paginiDiseño Y Operación de Un Aero Refrigerador Adiabático: Alumno: Alejandro Pérez VerdúIng. Cecilia GutierrezÎncă nu există evaluări

- 6167-BT-02 Membrana Celular y Transporte 2020Document16 pagini6167-BT-02 Membrana Celular y Transporte 2020franciscaÎncă nu există evaluări

- Examen de Recursos Humanos FinalDocument13 paginiExamen de Recursos Humanos FinalLeda Mora Bogantes0% (1)

- Sistemas de Agua LluviaDocument5 paginiSistemas de Agua LluviaGustavoPaezRodriguezÎncă nu există evaluări

- Guia de Instalacion de GLPI en LinuxDocument37 paginiGuia de Instalacion de GLPI en LinuxIvanik BlancoÎncă nu există evaluări

- Ejercicios Programacion Lineal Selectividad 2011Document11 paginiEjercicios Programacion Lineal Selectividad 2011sir18_0% (2)

- Prueba de HemoaglutinaciónDocument2 paginiPrueba de HemoaglutinaciónDaniel LgÎncă nu există evaluări

- Pictogram ADocument2 paginiPictogram ASabadoGrisÎncă nu există evaluări

- 1ESO 16 Consolidacion U4 Operaciones Con FraccionesDocument1 pagină1ESO 16 Consolidacion U4 Operaciones Con FraccionesSara PpmÎncă nu există evaluări

- BDD 1.1Document174 paginiBDD 1.1Tonyy MariscaalÎncă nu există evaluări

- Presentacion Derecho Penal IIIDocument5 paginiPresentacion Derecho Penal IIIIngles pnl AIFEÎncă nu există evaluări

- Acción de La Sustancia Transmisora en La Neurona PostsinápticaDocument2 paginiAcción de La Sustancia Transmisora en La Neurona PostsinápticaJohnny Mauricio0% (1)

- Caso Clínico Ii - Anatomía Funcional: Tania Hernández Agudelo Lency Camila Núñez Leyton Juliana Gil DuqueDocument18 paginiCaso Clínico Ii - Anatomía Funcional: Tania Hernández Agudelo Lency Camila Núñez Leyton Juliana Gil DuqueTania HernandezÎncă nu există evaluări

- Unidad3 GestionDocument8 paginiUnidad3 GestionMario JimenezÎncă nu există evaluări

- PR301-01A3 Manual de Instrucciones v01Document42 paginiPR301-01A3 Manual de Instrucciones v01Jay Cee RizoÎncă nu există evaluări

- Geoindicadores 2Document4 paginiGeoindicadores 2dila gonzalezÎncă nu există evaluări

- FORJADO - MonografiaDocument16 paginiFORJADO - MonografiaDelia Araoz Quiroz0% (1)

- Actividad # 3 Estudio de Caso Métodos de Interpretación JuridicaDocument20 paginiActividad # 3 Estudio de Caso Métodos de Interpretación Juridicaxiomara benitezÎncă nu există evaluări

- Grados de Viscosidad Sae para MotoresDocument10 paginiGrados de Viscosidad Sae para MotoresDaniel Tenezaca BejaranoÎncă nu există evaluări

- Escobar Modulo I DirectivasDocument3 paginiEscobar Modulo I DirectivasJesús AlejandroÎncă nu există evaluări

- Calculo en Instalaciones NeomaticasDocument12 paginiCalculo en Instalaciones NeomaticasRoberto MartinezÎncă nu există evaluări

- Modelo OsiDocument8 paginiModelo OsiJohanes Sarmiento CuentaOficialÎncă nu există evaluări

- Profesorado Segunda Enseñanza Pedagogía EspecialidadDocument1 paginăProfesorado Segunda Enseñanza Pedagogía EspecialidadcomputadoraÎncă nu există evaluări

- 1a - ESTADOS DE CARGADocument13 pagini1a - ESTADOS DE CARGACris Quea PomaÎncă nu există evaluări