Documente Academic

Documente Profesional

Documente Cultură

Análisis de Regresión

Încărcat de

Centro J y NDrepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Análisis de Regresión

Încărcat de

Centro J y NDrepturi de autor:

Formate disponibile

Análisis de Regresión

En análisis de regresión es una herramienta de frecuente uso en Estadística

que permite estudiar y valorar las relaciones entre diferentes variables

cuantitativas tenidas en cuenta mediante la construcción de una ecuación.

El esquema básico de análisis de regresión plantea un proceso o modelo en

el cual se analiza la relación entre una variable dependiente (porque es influida por

el resto) y una o varias variables independientes o fijas (las que influyen en el

objeto de estudio). Gracias procesos de regresión estadística es posible entender

el modo en que la dependiente es afectada por cambios en los valores de las

independientes.

Aplicaciones Prácticas del Análisis de Regresión

Este tipo de estudios tiene aplicaciones para la vida cotidiana, desde el

estudio de accidentes de tráfico en una determinada zona geográfica hasta

comprobar si un plan de estudios es recomendable o no desde el punto de vista

de la tasa de abandono escolar, por ejemplo.

Crítica al Análisis de Regresión

Una crítica común a este tipo de modelo de predicción matemática es no

son óptimo, pues suele confundir correlación con causalidad. Esto quiere decir que

las conclusiones que aporta este tipo de procesos están siempre sujetas a

factores que pueden influir en su exactitud, como la falta de información sobre lo

estudiado o la existencia de fallos en la medición o recolección de datos.

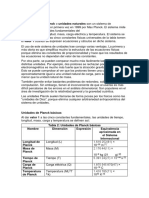

Objetivo del Análisis de Regresión

El objeto de un análisis de regresión es investigar la relación estadística que

existe entre una variable dependiente (Y) y una o más variables independientes

(,...). Para poder realizar esta investigación, se debe postular una relación

funcional entre las variables. Debido a su simplicidad analítica, la forma funcional

que más se utiliza en la práctica es la relación lineal. Cuando solo existe una

variable independiente, esto se reduce a una línea recta:

donde los coeficientes b0 y b1 son parámetros que definen la posición e

inclinación de la recta. (Nótese que hemos usado el símbolo especial para

representar el valor de Y calculado por la recta. Como veremos, el valor real de Y

rara vez coincide exactamente con el valor calculado, por lo que es importante

hacer esta distinción.)

El parámetro b0, conocido como la "ordenada en el origen," nos indica

cuánto es Y cuando X = 0. El parámetro b1, conocido como la "pendiente," nos

indica cuánto aumenta Y por cada aumento de una unidad en X. Nuestro

problema consiste en obtener estimaciones de estos coeficientes a partir de una

muestra de observaciones sobre las variables Y y X. En el análisis de regresión,

estas estimaciones se obtienen por medio del método de mínimos cuadrados.

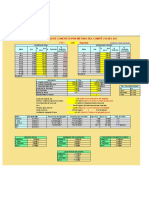

Diagrama de Dispersión

Un diagrama de dispersión o gráfica de dispersión o gráfico de dispersión

es un tipo de diagrama matemático que utiliza las coordenadas cartesianas para

mostrar los valores de dos variables para un conjunto de datos.

Se emplea cuando una o varias variables está bajo el control del

experimentador. Si existe un parámetro que se incrementa o disminuye de forma

sistemática por el experimentador, se le denomina parámetro de control o variable

independiente y habitualmente se representa a lo largo del eje horizontal (eje de

las abscisas). La variable medida o dependiente usualmente se representa a lo

largo del eje vertical (eje de las ordenadas). Si no existe una variable dependiente,

cualquier variable se puede representar en cada eje y el diagrama de dispersión

mostrará el grado de correlación (no causalidad) entre las dos variables.

Un diagrama de dispersión puede sugerir varios tipos de correlaciones entre

las variables con un intervalo de confianza determinado. La correlación puede ser

positiva (aumento), negativa (descenso), o nula (las variables no están

correlacionadas). Se puede dibujar una línea de ajuste (llamada también "línea de

tendencia") con el fin de estudiar la correlación entre las variables.

Prueba de Hipótesis

Es una regla que especifica si se puede aceptar o rechazar una afirmación acerca

de una población dependiendo de la evidencia proporcionada por una muestra de

datos.

Una prueba de hipótesis examina dos hipótesis opuestas sobre una

población: la hipótesis nula y la hipótesis alternativa. La hipótesis nula es el

enunciado que se probará. Por lo general, la hipótesis nula es un enunciado de

que "no hay efecto" o "no hay diferencia". La hipótesis alternativa es el enunciado

que se desea poder concluir que es verdadero de acuerdo con la evidencia

proporcionada por los datos de la muestra.

Con base en los datos de muestra, la prueba determina si se puede

rechazar la hipótesis nula. Usted utiliza el valor p para tomar esa decisión. Si el

valor p es menor que el nivel de significancia (denotado como α o alfa), entonces

puede rechazar la hipótesis nula.

Un error común de percepción es que las pruebas estadísticas de hipótesis

están diseñadas para seleccionar la más probable de dos hipótesis. Sin embargo,

al diseñar una prueba de hipótesis, establecemos la hipótesis nula como lo que

queremos desaprobar. Puesto que establecemos el nivel de significancia para que

sea pequeño antes del análisis (por lo general, un valor de 0.05 funciona

adecuadamente), cuando rechazamos la hipótesis nula, tenemos prueba

estadística de que la alternativa es verdadera. En cambio, si no podemos rechazar

la hipótesis nula.

S-ar putea să vă placă și

- Acidos nucleidos-GIOIADocument6 paginiAcidos nucleidos-GIOIACentro J y NÎncă nu există evaluări

- Foro, Determinación Del Precio. 19-6-21Document1 paginăForo, Determinación Del Precio. 19-6-21Centro J y NÎncă nu există evaluări

- La FlotacionDocument1 paginăLa FlotacionCentro J y NÎncă nu există evaluări

- Tarea 15-5-21Document2 paginiTarea 15-5-21Centro J y NÎncă nu există evaluări

- AgronomíaDocument7 paginiAgronomíaCentro J y NÎncă nu există evaluări

- 5 ObtaculosDocument1 pagină5 ObtaculosCentro J y NÎncă nu există evaluări

- Centro Educativo Nuestra Señora Del Valle-Juliana-Enero-2023Document2 paginiCentro Educativo Nuestra Señora Del Valle-Juliana-Enero-2023Centro J y NÎncă nu există evaluări

- Centro Educativo Nuestra Señora Del Valle-Encabezados JulianaDocument1 paginăCentro Educativo Nuestra Señora Del Valle-Encabezados JulianaCentro J y NÎncă nu există evaluări

- Centro Educativo Nuestra Señora Del Valle-Juliana-1S-Mayo-2021Document2 paginiCentro Educativo Nuestra Señora Del Valle-Juliana-1S-Mayo-2021Centro J y NÎncă nu există evaluări

- Centro Educativo Nuestra Señora Del Valle-Evaluacion Mes de Junio - JulianaDocument1 paginăCentro Educativo Nuestra Señora Del Valle-Evaluacion Mes de Junio - JulianaCentro J y NÎncă nu există evaluări

- Qué Es La Administración CientíficaDocument18 paginiQué Es La Administración CientíficaCentro J y NÎncă nu există evaluări

- Presonalidad 3y 4...Document8 paginiPresonalidad 3y 4...Centro J y NÎncă nu există evaluări

- Centro Educativo Nuestra Señora Del Valle-Evaluacion Mes de Diciembre 2022 - JulianaDocument3 paginiCentro Educativo Nuestra Señora Del Valle-Evaluacion Mes de Diciembre 2022 - JulianaCentro J y NÎncă nu există evaluări

- Actividad 1 Módulo 2 - Silenys Mercedes Sanchez BatistaDocument3 paginiActividad 1 Módulo 2 - Silenys Mercedes Sanchez BatistaCentro J y NÎncă nu există evaluări

- Centro Educativo Nuestra Señora Del Valle-Evaluacion Mes de Junio - Juliana-2do SDocument1 paginăCentro Educativo Nuestra Señora Del Valle-Evaluacion Mes de Junio - Juliana-2do SCentro J y NÎncă nu există evaluări

- Problemas de Ciencia o Teoría Científica de La Educación FísicaDocument3 paginiProblemas de Ciencia o Teoría Científica de La Educación FísicaCentro J y NÎncă nu există evaluări

- Modulo 7Document10 paginiModulo 7Centro J y NÎncă nu există evaluări

- Observaciones PreliminaresDocument12 paginiObservaciones PreliminaresCentro J y NÎncă nu există evaluări

- Revolución Del 24 de Abril Del 1965Document3 paginiRevolución Del 24 de Abril Del 1965Centro J y NÎncă nu există evaluări

- Hombres y Mujeres Que Aportaron Al Desarrollo Histórico de La TrigonometríaDocument1 paginăHombres y Mujeres Que Aportaron Al Desarrollo Histórico de La TrigonometríaCentro J y NÎncă nu există evaluări

- Formato Creacion de ProveedoresDocument1 paginăFormato Creacion de ProveedoresCentro J y NÎncă nu există evaluări

- Trabajo MonchitoDocument5 paginiTrabajo MonchitoCentro J y NÎncă nu există evaluări

- Haciendo Uso de Recortes de Papel-LeidyDocument1 paginăHaciendo Uso de Recortes de Papel-LeidyCentro J y NÎncă nu există evaluări

- 03 Secuencia El LetreroDocument24 pagini03 Secuencia El LetreroCentro J y NÎncă nu există evaluări

- La Etica.Document3 paginiLa Etica.Centro J y NÎncă nu există evaluări

- COLOREA A LA MUJER-leidyDocument1 paginăCOLOREA A LA MUJER-leidyCentro J y NÎncă nu există evaluări

- Analisis Los AmosDocument2 paginiAnalisis Los AmosCentro J y NÎncă nu există evaluări

- Manuel Antonio Cabral TavarezDocument1 paginăManuel Antonio Cabral TavarezCentro J y NÎncă nu există evaluări

- Conceptos de EducacionDocument2 paginiConceptos de EducacionCentro J y NÎncă nu există evaluări

- Cuaderno de Trabajo Quimica Basica Qui-014Document80 paginiCuaderno de Trabajo Quimica Basica Qui-014Centro J y NÎncă nu există evaluări

- Ventana de Bienvenida Con JframeDocument24 paginiVentana de Bienvenida Con JframeNoelÎncă nu există evaluări

- Práctica 6: Opción EscogidaDocument4 paginiPráctica 6: Opción EscogidaBf BÎncă nu există evaluări

- Laboratorio Integral IIDocument6 paginiLaboratorio Integral IIGabriela Bernal AnotaÎncă nu există evaluări

- Tarea 4 de EsperanzaDocument2 paginiTarea 4 de EsperanzaBrayan García RodríguezÎncă nu există evaluări

- Auto Evaluación de Números Reales 3º ESODocument3 paginiAuto Evaluación de Números Reales 3º ESORafael Merelo Guervós100% (1)

- Tema 6 - El Diseño Muestral en La Encuesta Con Cuestionario EstandarizadoDocument8 paginiTema 6 - El Diseño Muestral en La Encuesta Con Cuestionario EstandarizadopruebaÎncă nu există evaluări

- Transcad Curso Final General123 PDFDocument109 paginiTranscad Curso Final General123 PDFJuan TolentinoÎncă nu există evaluări

- Algoritmo LMS PDFDocument147 paginiAlgoritmo LMS PDFAlfredo Valle HernándezÎncă nu există evaluări

- Matemática OctavosDocument14 paginiMatemática OctavosCristian AstudilloÎncă nu există evaluări

- Teoria de Juegos Ejercicios Resueltos Final PDFDocument28 paginiTeoria de Juegos Ejercicios Resueltos Final PDFEnrique Forner Diaz100% (1)

- 003-Expresiones Algebraicas Racionales e IrracionalesDocument6 pagini003-Expresiones Algebraicas Racionales e IrracionalesAnalia NuñezÎncă nu există evaluări

- Componentes Radial y TransversalDocument1 paginăComponentes Radial y TransversalIsra Mm's50% (2)

- Estructura de Visual BasicDocument11 paginiEstructura de Visual BasicDaniel alejandro castro agudeloÎncă nu există evaluări

- Avance de Tarea de Fundamentos MatematicosDocument13 paginiAvance de Tarea de Fundamentos MatematicosDaniel RamirezÎncă nu există evaluări

- Actividad de Puntos Evaluables - Escenario 2 - Primer Bloque-Ciencias Basicas - Calculo II - (Grupo b06) .2Document4 paginiActividad de Puntos Evaluables - Escenario 2 - Primer Bloque-Ciencias Basicas - Calculo II - (Grupo b06) .2elkin centenoÎncă nu există evaluări

- Logica MatematicaDocument37 paginiLogica MatematicaGalo YambayÎncă nu există evaluări

- Leonardo - y Su Obsesion Por VolarDocument4 paginiLeonardo - y Su Obsesion Por VolarPamela CardosoÎncă nu există evaluări

- Continuidad de FuncionesDocument7 paginiContinuidad de FuncionesAlex GonzalezÎncă nu există evaluări

- Diferencias Entre Las Vertebras de La Columna VertebralDocument6 paginiDiferencias Entre Las Vertebras de La Columna VertebralLEYDI ARIANA CRUZ GARCIAÎncă nu există evaluări

- Diseño y Análisis en Investigación EducativaDocument25 paginiDiseño y Análisis en Investigación EducativaYukinaGomezÎncă nu există evaluări

- Familia de Disenos para Comparar TratamientosDocument24 paginiFamilia de Disenos para Comparar Tratamientossamuel denilson tocto peñaÎncă nu există evaluări

- DISEÑO DE MEZCLA F'C 210Document1 paginăDISEÑO DE MEZCLA F'C 210alexis chirre riveraÎncă nu există evaluări

- 14-Vm de Angulos Diedros-2 ParteDocument21 pagini14-Vm de Angulos Diedros-2 Partealaia123sintesisÎncă nu există evaluări

- Manual de LaboratorioDocument12 paginiManual de LaboratorioBELÉN MILLARAY MARTINÎncă nu există evaluări

- Articulo y VerboDocument5 paginiArticulo y VerboMaria LazarteÎncă nu există evaluări

- Matematica BasicaDocument2 paginiMatematica Basicafoker01Încă nu există evaluări

- Cuadro Comparativo Distribuciones D Probabilidad Discretas y ContinuasDocument8 paginiCuadro Comparativo Distribuciones D Probabilidad Discretas y Continuastamiz arvizuÎncă nu există evaluări

- Proceso de InvestigacionDocument19 paginiProceso de InvestigacionKim Salazar ReyesÎncă nu există evaluări

- Sistema Natural y Sitemas de Unidades de Medida TradicionalesDocument5 paginiSistema Natural y Sitemas de Unidades de Medida TradicionalesArnold Llancay50% (2)

- Marco Teorico. FiolaDocument4 paginiMarco Teorico. FiolaTania CruzÎncă nu există evaluări