Documente Academic

Documente Profesional

Documente Cultură

Métodos de Extrapolación

Încărcat de

maria camposTitlu original

Drepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Métodos de Extrapolación

Încărcat de

maria camposDrepturi de autor:

Formate disponibile

Se conocen varios métodos de extrapolación para mejorar la tasa de convergencia, y así

desarrollar una extrapolación aún más rápida, uno de estos procedimientos se basa en el

paso Anderson-Bjorck utilizado para encontrar una raíz simple de una ecuación no

lineal.

Cada uno de los métodos de extrapolación puede derivarse aplicando el método secante

a una función adecuada.

El subpaso de extrapolación consiste entonces en una aplicación del método secante

para g.

g n+1

x ´n+2=x n +1−( x n−x n+1 )

g n−gn +1

Donde gn=g ( x¿ ¿ n)=x n−x n−1 ¿ y gn−1=g( x¿¿ n−1)=x n+1−x n +2 ¿. Pero podemos

alcanzar una tasa de convergencia más alta simplemente reteniendo, en cada paso,

información retenida del paso anterior. Por cada paso subsiguiente, aplique un paso de

método secante a la función relacionada.

Así se muestra un nuevo procedimiento de iteración basado en el paso de extrapolación

Anderson-Bjorck

La siguiente idea se basa en esto: Si xi y xi+1 no contienen, el punto

Anderson - Algoritmo de Björk

Suponga que en la iteración k -ésima el intervalo es [ a k , b k ] y que el valor funcional

de la nueva estimación calculada c k tiene el mismo signo que f ( b k ) . En este caso,

el nuevo intervalo [ a k + 1 , b k + 1 ] = [ a k , c k ] y el punto final izquierdo se ha

retenido. (Hasta ahora, eso es lo mismo que Regula Falsi ordinario y el algoritmo de

Illinois).

Pero, mientras que el algoritmo de Illinois multiplicaría f ( un k ) por 1 / 2 , Anderson -

algoritmo Björk lo multiplica por m , donde m tiene uno de los dos valores siguientes:

f (c k )

m=1−

f (b k )

si ese valor de m es positivo, de lo contrario, dejemos

1

m=

2

Para raíces simples, Anderson-Björk fue el claro ganador en las pruebas numéricas de

Galdino. Para las raíces múltiples, ningún método fue mucho más rápido que la

bisección. De hecho, los únicos métodos que fueron tan rápidos como la bisección

fueron tres nuevos métodos introducidos por Galdino. Pero incluso ellos eran solo un

poco más rápidos que la bisección.

Consideraciones prácticas

Al resolver una ecuación, o solo unas pocas, usando una computadora, el

método de bisección es una opción adecuada. Aunque la bisección no es tan

rápida como los otros métodos, cuando están en su mejor momento y no

tienen un problema, la bisección sin embargo está garantizada para converger a

una velocidad útil, reduciendo a la mitad aproximadamente el error con cada

iteración, obteniendo aproximadamente un decimal lugar de precisión con cada

3 iteraciones.

Para el cálculo manual, por calculadora, uno tiende a querer usar métodos más

rápidos, y generalmente, pero no siempre, convergen más rápido que la

bisección. Pero una computadora, incluso usando bisección, resolverá una

ecuación, con la precisión deseada, tan rápidamente que no hay necesidad de

tratar de ahorrar tiempo usando un método menos confiable, y cada método es

menos confiable que la bisección.

Una excepción sería si el programa de computadora tuviera que resolver

ecuaciones muchas veces durante su ejecución. Entonces, el tiempo ahorrado

por los métodos más rápidos podría ser significativo.

Entonces, un programa podría comenzar con el método de Newton y, si Newton

no está convergiendo, cambiar a regular falsi , tal vez en una de sus versiones

mejoradas, como las versiones de Illinois o Anderson-Bjőrk. O, si incluso eso no

converge tan bien como lo haría la bisección, cambie a la bisección, que

siempre converge a una velocidad útil, si no espectacular.

Cuando el cambio en y se ha vuelto muy pequeño, y x también está

cambiando muy poco, entonces el método de Newton probablemente no

tendrá problemas y convergerá. Entonces, bajo esas condiciones favorables, uno

podría cambiar al método de Newton si quisiera que el error fuera muy

pequeño y quisiera una convergencia muy rápida.

S-ar putea să vă placă și

- Metodo de BrentDocument5 paginiMetodo de BrentFEDRA FARCA VILLAVICENCIOÎncă nu există evaluări

- Algoritmos CuánticosDocument30 paginiAlgoritmos CuánticosJhon Silva AleÎncă nu există evaluări

- Multiplicacion Rusa en C y Demostracion Por InduccionDocument4 paginiMultiplicacion Rusa en C y Demostracion Por InduccionDiego CarvajalÎncă nu există evaluări

- Problemas MNDocument20 paginiProblemas MNAnonymous W1mMU5ZÎncă nu există evaluări

- Problemas Mn1 2Document4 paginiProblemas Mn1 2hvillafuertebÎncă nu există evaluări

- LinealizacionDocument9 paginiLinealizacionNanmateÎncă nu există evaluări

- Ensayo Ajuste de CurvasDocument4 paginiEnsayo Ajuste de CurvasaidaÎncă nu există evaluări

- Problemas mn1-2Document4 paginiProblemas mn1-2Junior C. Hurtado0% (1)

- Trabajo Grupal (Primer Parcial) Grupo 3Document10 paginiTrabajo Grupal (Primer Parcial) Grupo 3Andii FlokkiÎncă nu există evaluări

- Me NumericosDocument14 paginiMe NumericosYtuza Puma JehordanyÎncă nu există evaluări

- Metodo de Newton Raphson y SecanteDocument8 paginiMetodo de Newton Raphson y SecanteDway Jamell Cuello OrozcoÎncă nu există evaluări

- Informe N°4. Brent PDFDocument12 paginiInforme N°4. Brent PDFPiero Archi VioÎncă nu există evaluări

- Semana 7 Jean Michael Cornelio 118-5693Document28 paginiSemana 7 Jean Michael Cornelio 118-5693Maicol CornelioÎncă nu există evaluări

- Manual de Teoria y Codigos de Metodos Numericos 2° A PDFDocument313 paginiManual de Teoria y Codigos de Metodos Numericos 2° A PDFAriicell GonzalezÎncă nu există evaluări

- Metodos Numericos DiapositivasDocument22 paginiMetodos Numericos DiapositivasJosé Silva FeraudÎncă nu există evaluări

- Metodos Numericos Proyecto U5Document11 paginiMetodos Numericos Proyecto U5Gustavo Nuñez MtzÎncă nu există evaluări

- Unitarios 3 Segundo Laboratorio 1 AmurrioDocument6 paginiUnitarios 3 Segundo Laboratorio 1 AmurrioLeonardo TonazzolliÎncă nu există evaluări

- Metodos Numericos Actividad 3 Proyecto Integrador Etapa 1 - CompressDocument17 paginiMetodos Numericos Actividad 3 Proyecto Integrador Etapa 1 - CompressJUCA AvaradoÎncă nu există evaluări

- T3 19 MilagrosJCoronadoDocument11 paginiT3 19 MilagrosJCoronadoelvisÎncă nu există evaluări

- Clase 05-Resolución de Ecuaciones No Lineales PDFDocument57 paginiClase 05-Resolución de Ecuaciones No Lineales PDFMili Tipe AnayaÎncă nu există evaluări

- Reporte Unidad 4Document24 paginiReporte Unidad 4karmenÎncă nu există evaluări

- Documentacion Metodos Numericos MatlabDocument27 paginiDocumentacion Metodos Numericos MatlabSalazar AnonimoÎncă nu există evaluări

- Ejercicios de Aplicacion Integracion FinalDocument14 paginiEjercicios de Aplicacion Integracion FinalJORGE GONZALEZÎncă nu există evaluări

- Proyecto de MetodoDocument6 paginiProyecto de MetodoJean MurilloÎncă nu există evaluări

- Sin RestriccionesDocument11 paginiSin RestriccionesradioactiveÎncă nu există evaluări

- Método de Fibonacci y Búsqueda de La Sección DoradaDocument6 paginiMétodo de Fibonacci y Búsqueda de La Sección DoradaAlberto SilvaÎncă nu există evaluări

- NotasDocument75 paginiNotasJuan Sebastian Mejia RinconÎncă nu există evaluări

- Trabajo Colaborativo No. 1 Grupo 224Document12 paginiTrabajo Colaborativo No. 1 Grupo 224Nivlek Abdala100% (2)

- NEWTON RAPHSON Modelado FINALDocument5 paginiNEWTON RAPHSON Modelado FINALJonathan Andrés PullasÎncă nu există evaluări

- Informe 3Document13 paginiInforme 3Mircala AnayaÎncă nu există evaluări

- Integración MúltipleDocument7 paginiIntegración MúltipleJesús Brito100% (1)

- Dever 2Document14 paginiDever 2David Padilla100% (1)

- Regla de SimpsonDocument12 paginiRegla de SimpsonJUAN AGUILARÎncă nu există evaluări

- Aplicacion A La FisicaDocument17 paginiAplicacion A La FisicaYahaira Ramirez GomezÎncă nu există evaluări

- ADA 1 - Métodos NuméricosDocument29 paginiADA 1 - Métodos NuméricosTyler Durden0% (1)

- Taller 3 Del Primer Corte - T00050802Document20 paginiTaller 3 Del Primer Corte - T00050802Josue PerezÎncă nu există evaluări

- Ley Elipse StodolaDocument6 paginiLey Elipse Stodolajorgeesteban1Încă nu există evaluări

- LinealizacionDocument19 paginiLinealizacionJose ZhawÎncă nu există evaluări

- Computacion CuanticaDocument14 paginiComputacion Cuanticaalejandro salazarÎncă nu există evaluări

- (Equipo 1) Metodo de BiseccionDocument16 pagini(Equipo 1) Metodo de BiseccionAriicell GonzalezÎncă nu există evaluări

- Informe DinámicaDocument6 paginiInforme DinámicaAriel GálvezÎncă nu există evaluări

- Metodo de La SecanteDocument8 paginiMetodo de La SecanteJosé Carlos Turpo QuiroÎncă nu există evaluări

- Deber Metodos 4Document8 paginiDeber Metodos 4Jose SanmartinÎncă nu există evaluări

- Reporte Datos ExperimentalesDocument8 paginiReporte Datos Experimentalesnanmate8664Încă nu există evaluări

- El Método de Búsqueda S2 o SimplexDocument31 paginiEl Método de Búsqueda S2 o SimplexPatty Carolina Cando MolinaÎncă nu există evaluări

- Notas Metodos Cap 1Document41 paginiNotas Metodos Cap 1Stivens MestraÎncă nu există evaluări

- Taller3 Coutts RamosDocument11 paginiTaller3 Coutts RamosFERNANDO COUTTSÎncă nu există evaluări

- Método de La SecanteDocument9 paginiMétodo de La SecanteDanielElorzaÎncă nu există evaluări

- Informe FISICADocument7 paginiInforme FISICAMadeCaroÎncă nu există evaluări

- Problemas Raíces de FuncionesDocument34 paginiProblemas Raíces de Funcionesdanisaa351Încă nu există evaluări

- Avance de Metodos NumericosDocument14 paginiAvance de Metodos NumericosIrvin Flores YucraÎncă nu există evaluări

- Metodo SimplexDocument14 paginiMetodo SimplexRigoRiveraPandoÎncă nu există evaluări

- Capitulo 4Document19 paginiCapitulo 4Cesar pariÎncă nu există evaluări

- Tarea 3 Dinamica - Elizabeth SilvaDocument19 paginiTarea 3 Dinamica - Elizabeth SilvaElines Carolina Lárez RojasÎncă nu există evaluări

- Integracion NumericaDocument23 paginiIntegracion Numericacristian navarroÎncă nu există evaluări

- Proyecto Optimización de TurbinasDocument14 paginiProyecto Optimización de TurbinasAlberto Junior Gonzales SilesÎncă nu există evaluări

- Metodo de La SecanteDocument6 paginiMetodo de La SecanteWeslyVillamilÎncă nu există evaluări

- Calculos Realizados en El CBRDocument7 paginiCalculos Realizados en El CBRpepepakoÎncă nu există evaluări

- Sistema TernarioDocument1 paginăSistema Ternariomaria camposÎncă nu există evaluări

- Tension de VaporDocument17 paginiTension de Vapormaria123Încă nu există evaluări

- AcetanilidaDocument2 paginiAcetanilidamaria camposÎncă nu există evaluări

- IllinoisDocument4 paginiIllinoismaria camposÎncă nu există evaluări

- El Estado GaseosoDocument1 paginăEl Estado Gaseosomaria camposÎncă nu există evaluări

- Métodos de ExtrapolaciónDocument2 paginiMétodos de Extrapolaciónmaria camposÎncă nu există evaluări

- Conductancia ElectrolíticaDocument1 paginăConductancia Electrolíticamaria camposÎncă nu există evaluări

- EliminarDocument1 paginăEliminarmaria camposÎncă nu există evaluări

- 1Document1 pagină1maria camposÎncă nu există evaluări

- Métodos de ExtrapolaciónDocument2 paginiMétodos de Extrapolaciónmaria camposÎncă nu există evaluări

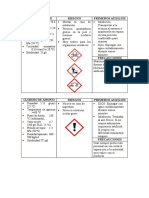

- Pictogrmas Labo1 AnalisisDocument3 paginiPictogrmas Labo1 Analisismaria camposÎncă nu există evaluări

- Function RegulaDocument3 paginiFunction Regulamaria camposÎncă nu există evaluări

- Exp 3Document3 paginiExp 3maria camposÎncă nu există evaluări

- Informe 3Document16 paginiInforme 3maria camposÎncă nu există evaluări

- TermodinamicaDocument18 paginiTermodinamicamaria camposÎncă nu există evaluări

- Labo 1 QuimicaDocument19 paginiLabo 1 Quimicamaria camposÎncă nu există evaluări

- Quimica Analitica-Redox2Document15 paginiQuimica Analitica-Redox2Carlos Camacho CaeroÎncă nu există evaluări

- Exp 3Document3 paginiExp 3maria camposÎncă nu există evaluări

- Exp 3Document3 paginiExp 3maria camposÎncă nu există evaluări

- Informe Nº5 Fisica IDocument23 paginiInforme Nº5 Fisica Imaria camposÎncă nu există evaluări

- Corriente AlternaDocument9 paginiCorriente Alternamaria camposÎncă nu există evaluări

- Densidad y Tension SuperficialDocument4 paginiDensidad y Tension SuperficialdiegoÎncă nu există evaluări

- Laboratorio #03Document9 paginiLaboratorio #03maria123Încă nu există evaluări

- Conductancia ElectrolíticaDocument1 paginăConductancia Electrolíticamaria camposÎncă nu există evaluări

- Tabla para Pictogramas Labo 9Document1 paginăTabla para Pictogramas Labo 9maria camposÎncă nu există evaluări

- CALORIMETRÍADocument6 paginiCALORIMETRÍAmaria123Încă nu există evaluări

- Diagrama de Fases SólidoDocument2 paginiDiagrama de Fases Sólidomaria camposÎncă nu există evaluări

- Laboratorio #03 Fisica IDocument11 paginiLaboratorio #03 Fisica Imaria camposÎncă nu există evaluări

- Control de Lectura de La Apología de SócratesDocument4 paginiControl de Lectura de La Apología de Sócratesmaria camposÎncă nu există evaluări

- Informe Camino Mas CortoDocument14 paginiInforme Camino Mas CortoDUVAN FELIPE PARADA RUIZÎncă nu există evaluări

- Documento 6 Condiciones Simples Compuestas y Operadores 1Document8 paginiDocumento 6 Condiciones Simples Compuestas y Operadores 1victor molinaÎncă nu există evaluări

- Actividad No. 2 - Teoria de Grafos - Paula Andrea David Petro - Juan Camilo Avilés RiveroDocument6 paginiActividad No. 2 - Teoria de Grafos - Paula Andrea David Petro - Juan Camilo Avilés Riveropaula andrea david petroÎncă nu există evaluări

- Taller Sobre GrafosDocument11 paginiTaller Sobre GrafosFernando CarreñoÎncă nu există evaluări

- Transformar ConquistarDocument115 paginiTransformar ConquistarANDREW POLD JACOBO CASTILLOÎncă nu există evaluări

- Fundamentos de Visual BasicDocument13 paginiFundamentos de Visual BasicJorgeldrÎncă nu există evaluări

- Tarea 2 Expresiones RegularesDocument5 paginiTarea 2 Expresiones RegularesJose Alfredo Roman CruzÎncă nu există evaluări

- Pruebas de EscritorioDocument15 paginiPruebas de EscritorioMaricarmen Rodriguez Gomez0% (1)

- 8 Contenedores AsociativosDocument11 pagini8 Contenedores AsociativosGabriel CaballeroÎncă nu există evaluări

- Arboles 1Document70 paginiArboles 1Jeffrey PintoÎncă nu există evaluări

- Pauta Pep 2 2018 DiurnaDocument5 paginiPauta Pep 2 2018 DiurnaMichelle Varela CáceresÎncă nu există evaluări

- L Ogica Computacional 2016-2, Nota de Clase 9 Formas Normales en L Ogica de PredicadosDocument8 paginiL Ogica Computacional 2016-2, Nota de Clase 9 Formas Normales en L Ogica de PredicadosAldehuarteMextliÎncă nu există evaluări

- TALLER1Document2 paginiTALLER1SchneiderAlvarezÎncă nu există evaluări

- Taller Sobre Los Ciclos RepetitivosDocument15 paginiTaller Sobre Los Ciclos RepetitivosdarioÎncă nu există evaluări

- Montículo de FibonacciDocument5 paginiMontículo de FibonacciALEX MARTIN URUETA ACUÑAÎncă nu există evaluări

- Filo3 PDFDocument15 paginiFilo3 PDFsamuel piñon gaciaÎncă nu există evaluări

- Representación de GrafosDocument6 paginiRepresentación de GrafosKatty Estrella PalaciosÎncă nu există evaluări

- AAC16 Examen Final Matematicas DiscretasDocument7 paginiAAC16 Examen Final Matematicas DiscretasWILKER EDISON ATALAYA RAMIREZÎncă nu există evaluări

- Casos Especiales Método SimplexDocument28 paginiCasos Especiales Método SimplexNAYELIS PAOLA VILLEGAS MORALESÎncă nu există evaluări

- Práctica 2 LFyADocument2 paginiPráctica 2 LFyAAlejandro Díaz-CaroÎncă nu există evaluări

- Clase Conversiones de Hexagesimal A BinarioDocument7 paginiClase Conversiones de Hexagesimal A BinarioingridamorÎncă nu există evaluări

- Complejidad de AlgoritmosDocument45 paginiComplejidad de AlgoritmosCarlos RiveroÎncă nu există evaluări

- Redes Investigacion de OperacionesDocument12 paginiRedes Investigacion de OperacionesShalom VideosÎncă nu există evaluări

- 2 HerenciaDocument12 pagini2 HerenciaManuelÎncă nu există evaluări

- AlgoritmosDocument6 paginiAlgoritmosGabriel MalpartidaÎncă nu există evaluări

- Autómatas de PilaDocument26 paginiAutómatas de PilaWilliam GaelÎncă nu există evaluări

- Algebra Lineal Actividad Semana 02Document6 paginiAlgebra Lineal Actividad Semana 02Ivan SubiasÎncă nu există evaluări

- Temario Matematicas de ComputadorasDocument2 paginiTemario Matematicas de Computadorasj acÎncă nu există evaluări

- Clustering K-MeansDocument33 paginiClustering K-MeansZundarÎncă nu există evaluări

- Arboles PDFDocument40 paginiArboles PDFJuan David CastañoÎncă nu există evaluări