Documente Academic

Documente Profesional

Documente Cultură

Tesis Redes Neuron Ales Jmfa

Încărcat de

leonloaDrepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Tesis Redes Neuron Ales Jmfa

Încărcat de

leonloaDrepturi de autor:

Formate disponibile

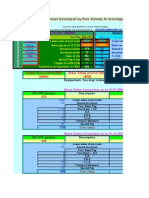

CENTRO DE INVESTIGACI

ON Y DE ESTUDIOS AVANZADOS DEL

INSTITUTO POLIT

ECNICO NACIONAL

Unidad Ciudad de Mexico

Departamento de Control Automatico

CINVESTAV-IPN

Aprendizaje Neuronal para el Control de Sistemas No Lineales

Tesis que presenta:

Jose Martn Flores Albino

1

Para obtener el grado de

Doctor en Ciencias

En la especialidad de

Control Automatico

Directores de Tesis:

Dr.Ieroham Solomon Barouh

Dr. Juan Carlos Martnez Garca

Mexico, D. F. 28 de Mayo del 2004

1

Becario CONACYT, No. 72355

.

En este documento se utilizan:

L

A

T

E

X2e

compilador:

MiKTeX 2.1

http://www.miktex.org

editor:

WinEdt ver. 5

http://www.winedt.com

dibujos:

CorelDraw ver. 5.00.E2

Simulacion y Gracas:

MatLab ver. 5.2.0.3084

Simulink

.

Agradecimientos

Ha sido muy largo el tiempo que he tomado para terminar este trabajo, el resultado de todo sera evaluado al momento

de que sea de utilidad para otros, este ha sido el objetivo desde su inicio.

El que se dedica a la investigacion, en frenta el reto del necesario aislamiento en que las reexiones se conciben.

Lo com un es que no halla alguien cerca cuando se logra un despeje exitoso de la variable que tanto se buscaba; ni se

escuchan aplausos al ver que una simulacion por computadora no se va al innito. Pero aquello que nos alimenta a seguir

es la curiosidad Que pasa s...? C omo ocurre ...? Etcetera.

Pero cuando se desciende de esta nube de aparente aislamiento, notamos que nunca se estuvo solo, que hay muchas

personas que han apoyado de forma directa y otras que sin darse cuenta nos han dando su aliento para continuar.

Gracias a todos...

Dr. Ieroham Solomon Barouh

Sin su apoyo y ejemplo este trabajo jamas se

hubiese concluido.

Dr. Juan Carlos Martnez Garca

Por conar en mi esfuerzo.

Departamento de Control Automatico

Y

Centro de Investigaci on y Estudios Avanzados

Por ser el lugar donde conoc a mis profesores y

compa neros.

Consejo Nacional de Ciencia y Tecnol ogia

Por ser la instituci on que me brind o el apoyo

econ omico para lograr este objetivo.

Instituto de Investigaci on y Desarrollo Tecnol ogico

Secretara de Marina, Armada de Mexico

Por ser el lugar que me abrio las puertas para desarrollarme

y me darme la oportunidad de terminar este trabajo.

A mi mama y hermanas

Por su innita paciencia y comprensi on.

Liliana Vicente no Loya

Por todo tu cari no.

Edited by Foxit Reader

Copyright(C) by Foxit Software Company,2005-2008

For Evaluation Only.

.

Resumen

En las siguientes paginas se presenta el trabajo realizado durante mi estancia en el Centro de Investigaci on y de

Estudios Avanzados del Instituto Politecnico Nacional con el prop osito de obtener el grado de Doctor en Ciencias del

Departamento de Control Automatico.

La investigacion se enfoco en el estudio de una arquitectura de Red Neuronal Recurrente y su algoritmo de aprendizaje

del tipo retropropagacion dinamico para su aplicacion en tareas de identicacion y control de sistemas no lineales. Se

realizaron implementaciones en simulacion y en un prototipo en tiempo real para el control de un motor de corriente

directa. Los resultados producidos han sido alentadores y animan a plantearse metas de mayor complejidad.

El deseo nal de este escrito es el de generar nuevas preguntas y retos en la aplicacion de las redes neuronales para

el control de sistemas complejos.

Jose Martn Flores Albino, 8 de mayo de 2004

.

Indice general

Indice general I

Indice de guras IV

Indice de tablas VIII

Historia XI

Simbologa XIII

1. Introducci on: Redes Neuronales 1

1.1. Redes Neuronales Biol ogicas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.1.1. Modelo Matematico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

1.2. Redes Neuronales Articiales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.2.1. Topologas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

1.2.2. Redes Neuronales Articiales Estaticas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

1.2.3. Redes Neuronales Articiales Dinamicas (Recurrentes) . . . . . . . . . . . . . . . . . . . . . . . 9

1.2.4. Proceso de Aprendizaje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.3. Conclusi on . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

2. Red Neuronal Recurrente Entrenable 21

2.1. Estructura de una RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 21

2.2. Propiedades de Observabilidad y Controlabilidad . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

2.2.1. Observabilidad . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2.2.2. Controlabilidad . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

2.3. Red Neuronal Recurrente Entrenable . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 26

2.3.1. Ley de Aprendizaje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

2.4. Red Neuronal Recurrente de Tres Capas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

2.4.1. Ley de Aprendizaje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

2.5. RNRE con Prediccion de la Salida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

2.5.1. Ley de Aprendizaje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

2.6. RNRE con Retardo en la Retroalimentacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

2.6.1. Ley de Aprendizaje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

2.7. RNRE con Estados Acotados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

I

INDICE GENERAL

INDICE GENERAL

2.7.1. Ley de Aprendizaje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

2.8. Condici on de Estabilidad para los Pesos J . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

2.9. Pesos de Compensacion c

i0

, b

i0

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

2.10. Escalamiento de la Funci on de Activacion, (x) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

2.11. Conclusi on . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42

3. Identicaci on de Sistemas 43

3.1. Aproximacion de Funciones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43

3.1.1. Redes Neuronales Estaticas en la Aproximacion de Funciones . . . . . . . . . . . . . . . . . . . . 44

3.2. Identicacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

3.3. Metodos de Identicacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52

3.3.1. Algoritmo de Proyeccion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52

3.3.2. Algoritmo de Proyeccion Ortogonal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

3.3.3. Algoritmo de Mnimos Cuadrados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

3.3.4. Exitacion Persistente . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60

3.3.5. Algoritmos de Identicacion Clasicos y Redes Neuronales . . . . . . . . . . . . . . . . . . . . . . 62

3.4. Identicacion de Sistema Usando Redes Neuronales Estaticas . . . . . . . . . . . . . . . . . . . . . . . . 63

3.4.1. Sistemas Lineales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63

3.4.2. Sistemas No Lineales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65

3.5. Identicacion de Sistemas Usando Redes Neuronales Dinamicas . . . . . . . . . . . . . . . . . . . . . . . 67

3.6. Identicacion de Sistemas Utilizando RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

3.6.1. Identicacion. del Modelo de Vel. de un Motor de cc. usando una RNRE . . . . . . . . . . . . . 70

3.6.2. Identicacion no Lineal Usando RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72

3.6.3. Identicacion de un Sistema no Lineal de dos Entradas dos Salidas . . . . . . . . . . . . . . . . . 74

3.6.4. Identicacion M ultimodelo con RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 76

3.6.5. Identicacion en Tiempo Real de un Motor de cc. . . . . . . . . . . . . . . . . . . . . . . . . . . 80

3.7. Complejidad Computacional . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 86

3.8. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 87

4. Control de Sistemas 89

4.1. Redes Neuronales en el Control de Sistemas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 90

4.2. Modelado de controlador . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 91

4.3. Control por modelo inverso . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94

4.4. Control Adaptable . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102

4.4.1. Control Adaptable Indirecto . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104

4.4.2. Control Adaptable Directo, [16] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 112

4.5. Control por Modelo de Referencia . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117

4.5.1. Control por modelo de referencia: Enfoque neuronal [28] . . . . . . . . . . . . . . . . . . . . . . 117

4.5.2. Control por modelo de referencia: Sistemas lineales . . . . . . . . . . . . . . . . . . . . . . . . . 121

4.6. Control por Modelo Interno, [58] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

4.6.1. Control por Modelo Interno Redes Neuronales . . . . . . . . . . . . . . . . . . . . . . . . . . . 129

4.7. Control de Sistemas por medio de RNRE. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

ii JMFA

INDICE GENERAL

INDICE GENERAL

4.7.1. Sistemas de Control Adaptable Indirecto Usando los Parametros Obtenidos por la RNRE . . . . . 131

4.7.2. Sistemas de Control Adaptable Directo Usando RNRE . . . . . . . . . . . . . . . . . . . . . . . 136

4.7.3. Control en Tiempo Real de un Motor de Corriente Continua . . . . . . . . . . . . . . . . . . . . 140

4.8. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 144

Conclusiones Generales y Perspectivas 145

Bibliografa 147

A. Artculos Publicados 151

A.1. Congresos Nacionales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 151

A.2. Congresos Internacionales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 151

A.3. Revistas Nacionales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 152

A.4. Anexos en Libros . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 152

B. Programas de C omputo 153

B.1. Aproximacion de una Funci on No Lineal por Medio de una RNMC . . . . . . . . . . . . . . . . . . . . . 153

B.2. Aproximacion de una Funci on No Lineal por Medio de una RNFRB . . . . . . . . . . . . . . . . . . . . . 155

B.3. Algoritmo de Proyeccion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 156

B.4. Algoritmo de Proyeccion Ortogonal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 158

B.5. Algoritmo de Mnimos Cuadrados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 159

B.6. Ident. Vel. Motor cc. con RN Estatica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 160

B.7. Ident. No lineal con RN Estatica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 163

B.8. Ident. Vel. Motor cc. con RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 166

B.9. Ident. No Lineal con RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 169

B.10.Ident. No Lineal MIMO con RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 171

B.11.Ident. M ultimodelo No Lineal MIMO con RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 174

B.12.Modelado de Controlador . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 180

B.13.Cinematica Inversa de dos Eslabones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 183

B.14.Cinematica Directa de dos Eslabones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 186

B.15.Ctrl. Inverso: Ident. Mod. Directo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 189

B.16.Ctrl. Inverso: Metodo especializado . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 192

B.17.Ctrl. Adaptable Indirecto . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 194

B.18.Ctrl. Adaptable Indirecto 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 198

B.19.Ctrl. Adaptable Directo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 203

B.20.Ctrl. por Modelo de Referencia: Motor de CD . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 205

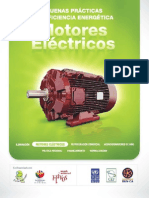

C. Motor de Corriente Continua 207

C.1. Modelo Matematico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 207

C.2. Motor de cc de Iman Permanente . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 208

C.3. Control de Velocidad en Regimen Estacionario . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 209

C.4. Modelo Discreto de un Motor de cc . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 209

JMFA iii

INDICE GENERAL

INDICE GENERAL

D. Ecuaciones de Entrenamiento para Redes Neuronales Recurrentes 213

D.1. Red Neuronal Recurrente . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 213

D.1.1. Pesos de la Capa de Salida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 213

D.1.2. Pesos de la Capa Oculta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 214

D.1.3. Pesos de la Capa de Entrada . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 214

D.2. RNR con Tres Capas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 215

D.2.1. Pesos de la Capa de Salida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 215

D.2.2. Pesos de la Capa Oculta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 215

D.2.3. Pesos de Entrada . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 215

D.3. Prediccion de la Salida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 216

D.3.1. Pesos de la Capa de Salida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 216

D.3.2. Pesos de la Capa Oculta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 217

D.3.3. Pesos de la Capa de Entrada . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 217

D.4. Estados Acotados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 217

D.4.1. Pesos de la Capa de Salida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 217

D.4.2. Pesos de la Capa Oculta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 218

D.4.3. Pesos de la Capa de Entrada . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 218

E. Prototipo Experimental 219

E.1. Descripcion General . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 219

E.2. Control Proporcional Integral Derivativo Discreto . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 221

E.3. Filtrado . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 221

F. Algoritmo de Retropropagaci on 227

G. Representaci on de Sistemas 231

G.1. Modelos Discretos de Sistemas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 231

G.1.1. Modelo DARMA . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 231

G.1.2. Modelo Regresor . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 232

G.1.3. Modelo en Variables de Estado . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 232

Indice alfabetico 235

iv JMFA

Indice de guras

1.1. Estructura de una neurona biol ogica. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

1.2. Neurona articial elemental. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

1.3. Funciones de activacion comunes. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

1.4. Derivadas de las funciones de activaci on. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

1.5. Topologas de redes neuronales articiales. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

1.6. Tipos de redes neuronales. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

1.7. Red neuronal de m ultiples capas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

1.8. Red neuronal de funciones radiales basicas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

1.9. Neurona de Hopeld. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

1.10. Red de Hopeld con tres neuronas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

1.11. Maquina de Boltzmann. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

1.12. Estructuras de redes neuronales recurrentes (local-recurrent-global-feedforward). . . . . . . . . . . . . . . 12

1.13. Modelos para un sistema desconocido no lineal discreto de una entrada y una salida. . . . . . . . . . . . 13

1.14. Estructura de la red de Jordan y de Elman. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

1.15. Division del Aprendizaje. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

1.16. Paradigmas de Aprendizaje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

1.17. Red Neuronal con tres capas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

1.18. Modelo de sensibilidad. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

1.19. Retropropagacion a traves del tiempo. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.1. Estructura general de una red neuronal hibrda. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

2.2. Ejemplo de una red neuronal recurrente entrenable. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

2.3. Diagrama a bloques de una red neuronal recurrente. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2.4. Red neuronal recurrente entrenable. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 26

2.5. Red neuronal recurrente de tres capas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

2.6. Red neuronal recurrente con prediccion de la salida. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

2.7. Red neuronal con retardo en la retroalimentacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

2.8. Red neuronal recurrente con estados acotados. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

2.9. Funci on de Activacion tanh(x). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

3.1. Proceso de proximacion en lnea de una funci on. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46

3.2. Aproximacion de una funci on a traves de una red neuronal m ulticapa. . . . . . . . . . . . . . . . . . . . 47

3.3. Aproximacion de una funci on no lineal utilizando una red neuronal de funciones radiales basicas. . . . . . 49

V

INDICE DE FIGURAS

INDICE DE FIGURAS

3.4. Problema de identicacion de sistemas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

3.5. Algoritmo de proyeccion- Interpretacion geometrica. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

3.6. Interpretacion del algoritmo de proyeccion. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

3.7. Operacion del algoritmo de proyeccion. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 54

3.8. Operacion del algoritmo de proyeccion ortogonal. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56

3.9. Operacion del algoritmo de mnimos cuadrados. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

3.10. Redes neuronales en los algoritmos de identicacion. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62

3.11. Identicacion de un sistema lineal. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63

3.12. Identicacion de un sistema lineal (entrenamiento). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

3.13. Identicacion de un sistema lineal (generalizacion). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65

3.14. Identicacion no lineal usando una RN Estatica (Entrenamiento). . . . . . . . . . . . . . . . . . . . . . 66

3.15. Identicacion no lineal usando una RN Estatica-Generalizacion. . . . . . . . . . . . . . . . . . . . . . . . 67

3.16. Red neuronal estatica en lazo cerrado. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

3.17. Modelo general de una red neuronal recurrente. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

3.18. Modelo de red neuronal recurrente simplifacada. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69

3.19. Identicacion de la vel. Motor de cc. usando una RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . 71

3.20. Identicacion de un sist. no lineal usando RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73

3.21. Identicacion de un sist. no lineal MIMO Usando RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . 75

3.22. Identicacion M ultimodelo Usando RNRE

+

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

3.23. Identicacion M ultimodelo Usando RNRE

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 78

3.24. Identicacion M ultimodelo Usando RNRE

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 79

3.25. Lugar de las races sis tema retroalimentado. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 80

3.26. Identicacion en tiempo real de un motor de cc. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 82

3.27. Identicacion multimodelo en tiempo real de un motor de cc. . . . . . . . . . . . . . . . . . . . . . . . . 84

3.28. Identicacion multimodelo en tiempo real de un motor de cc. . . . . . . . . . . . . . . . . . . . . . . . . 85

4.1. Modelado de controlador. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 91

4.2. Ejemplo del esquema por modelado de controlador. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 92

4.3. Resultados del esquema de modelado de controlador. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 93

4.4. Control por modelo inverso. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 96

4.5. Modelo inverso. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 97

4.6. Descripcion de un mecanismo de dos eslabones. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 98

4.7. Cinematica directa del mecanismo. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 99

4.8. Cinematica inversa del mecanismo. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 99

4.9. Posicion de los eslabones. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

4.10. Control inverso especializado. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101

4.11. Control por modelo inverso (Metodo especializado) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103

4.12. Control Adaptable . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104

4.13. Control Adaptable Indirecto Identicacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 109

4.14. Control Adaptable Indirecto Control . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110

4.15. Control Adaptable Indirecto -En lnea . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 111

vi JMFA

INDICE DE FIGURAS

INDICE DE FIGURAS

4.16. Componentes del control directo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113

4.17. Control Adaptable Directo -

Epoca 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 115

4.18. Control Adaptable Directo -

Epoca 100 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 116

4.19. Control por modelo de Referencia . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117

4.20. Grado relativo: linealizacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 118

4.21. Diagrama a bloques del Ctl. Modelo de Referencia. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 119

4.22. Diagrama a bloques del Ctl. Modelo de Referencia -Redes Neuronales. . . . . . . . . . . . . . . . . . . . 120

4.23. Control por modelo de Referencia 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 123

4.24. Control por Modelo de Referencia Motor de CC. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 125

4.25. Control por Modelo Interno . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 127

4.26. Control por Modelo Interno Eq. Lazo cerrado . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 129

4.27. Control por Modelo Interno Redes Neuronales. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 130

4.28. Control por Modelo Interno Entrenamiento. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 130

4.29. Control Adaptable Indirecto RNRE. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

4.30. Control Adaptable Indirecto P, PI. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 134

4.31. Control Adaptable Indirecto Seguimiento de Trayectoria. . . . . . . . . . . . . . . . . . . . . . . . . . . 136

4.32. Control Adaptable Directo Modelo Inverso. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 137

4.33. Control Adaptable Directo Modelo Inverso. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 139

4.34. Plataforma experimental . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 140

4.35. Esquema de control en tiempo real de un Motor CC. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 141

4.36. Control en Tiempo Real de un Motor de CC Posicion. . . . . . . . . . . . . . . . . . . . . . . . . . . . 142

4.37. Control en Tiempo Real de un Motor de CC Velocidad. . . . . . . . . . . . . . . . . . . . . . . . . . . 143

C.1. Motor de corriente continua. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 207

C.2. Modelo matematico de un motor de c.c. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 210

C.3. Transformada de Laplace de un motor de cc. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 210

C.4. Respuesta al escalon Motor de c.c. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 212

D.1. Red neuronal recurrente 2, 3, 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 213

D.2. Red neuronal recurrente con tres capas 2, 3, 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 215

D.3. Red neuronal recurrente con prediccion a la salida 2, 3, 2 . . . . . . . . . . . . . . . . . . . . . . . . . 216

D.4. Estados acotados 2, 3, 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 218

E.1. Prototipo experimental de laboratorio. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 219

E.2. Respuesta al escalon del motor de cc. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 220

E.3. Diagrama de Bode de un derivador. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 222

E.4. Diagrama de Bode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 222

E.5. Diagrama de Bode de un ltro Butterworth pasa-altos. . . . . . . . . . . . . . . . . . . . . . . . . . . . 223

E.6. Diagrama de Bode de un ltro Butterworth pasa-bajos. . . . . . . . . . . . . . . . . . . . . . . . . . . 223

E.7. Diagrama de Bode de un ltro pasa-banda (continuo). . . . . . . . . . . . . . . . . . . . . . . . . . . . 224

E.8. Diagrama de Bode de un ltro pasa-banda (Discreto). . . . . . . . . . . . . . . . . . . . . . . . . . . . 224

E.9. Diagrama de Bode de un ltro Butterworth pasa-bajos de tercer orden. . . . . . . . . . . . . . . . . . . 224

JMFA vii

INDICE DE FIGURAS

INDICE DE FIGURAS

E.10. Diagrama de Bode de un ltro pasa-banda. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 224

E.11. Filtro digital pasa banda . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 225

F.1. Esquema del metodo de aprendizaje por retropropagacion. . . . . . . . . . . . . . . . . . . . . . . . . . 230

viii JMFA

Indice de tablas

1.1. Topologa de una red neuronal m ultiples capas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

3.1. Resumen de resultados de generalizaci on para el ejemplo 3.1. . . . . . . . . . . . . . . . . . . . . . . . . 48

3.2. Resumen de resultados de generalizaci on para el ejemplo 3.2. . . . . . . . . . . . . . . . . . . . . . . . . 50

3.3. Resumen del algoritmo de identicacion de proyeccion. . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

3.4. Resumen del algoritmo de identicacion de proyeccion ortogonal. . . . . . . . . . . . . . . . . . . . . . . 57

3.5. Resumen del algoritmo de identicacion de mnimos cuadrados. . . . . . . . . . . . . . . . . . . . . . . . 61

3.6. Parametros de una RNRE-Identicaci on de un Motor en tiempo real. . . . . . . . . . . . . . . . . . . . . 81

3.7. Parametros de una RNRE-Identicaci on de un Motor en tiempo real. . . . . . . . . . . . . . . . . . . . . 83

3.8. Desempe no entre una RN estatica y una RNRE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 87

4.1. Resultados del modelo neuronal inverso. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

C.1. Parametros de un motor de cc. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 212

IX

INDICE DE TABLAS

INDICE DE TABLAS

x JMFA

Historia

1990 Narendra & Partasaraty . . . . . . . . . . Presentan el algortimo Retropropacion Dinamico para entrenar redes

m ulticapas para identicacion y control de sistemas.

1988 Anderson & Rosenfeld . . . . . . . . . . . Presentan las Funciones Radiales Basicas (RBF) como alternativa

para los perceptrones m ulticapa.

1986 Rumerlhart & MacClelland . . . . . . . Presentan el algoritmo Retropropagacion para el entrenamiento del

perceptron m ulticapa.

1985 Ack, Hinton & Sejnowski . . . . . . . . Denen el aprendizaje estocastico para la maquina de Boltzmann.

1983 Barto, Sutton & Anderson . . . . . . . Denen el aprendizaje reforzado (Reinforcement Learning).

1983 Kirkpatrick, Galatt & Vecchi . . . . . Presentan el aprendizaje por templado simulado (simulated-

annealing) para resolver problemas de optimizacion.

1982 Kohonen . . . . . . . . . . . . . . . . . . . . . . . . Presentan sus mapas auto-organizados.

1983 Cihen & Grossberg . . . . . . . . . . . . . . Presentan las memorias direccionadas por contenido (content-

addressable memories).

1982 Hopeld . . . . . . . . . . . . . . . . . . . . . . . . Presenta una red neuronal dinamica, dene su funci on de energa

considerando simetra en los pesos.

1980 Grossberg . . . . . . . . . . . . . . . . . . . . . . . Trabaja con el aprendizaje competitivo, establece el nuevo principio

de auto-organizacion.

1979 Utley . . . . . . . . . . . . . . . . . . . . . . . . . . . Integra la teora de las comunicaciones de Shanon con el aprendizaje

sinaptico neuronal.

1973 Malsburg . . . . . . . . . . . . . . . . . . . . . . . Presenta los mapas auto-organizados entrenados por una ley de

aprendizaje competitiva.

1972 Anderson, Kohonen & Nakano . . . Presentan una ley de aprendizaje en una matriz de correlaci on.

1969 Minski & Papert . . . . . . . . . . . . . . . . Presentan el perceptron de una capa y de m ultiples capas.

1962 Widrow . . . . . . . . . . . . . . . . . . . . . . . . . Presenta una estructura para adalines de m ultiples capas (Madaline).

1960 Widrow & Ho . . . . . . . . . . . . . . . . . . Presentan el algoritmo de mnimos cuadrados, usado para el entre-

namiento de Adaline (adaptive learning element).

1958 Rosenblatt . . . . . . . . . . . . . . . . . . . . . . Teorema de convergencia del Perceptron.

1958 Rosenblatt . . . . . . . . . . . . . . . . . . . . . . Presenta su modelo del Perceptron.

1954 Minsky . . . . . . . . . . . . . . . . . . . . . . . . . . Presenta su tesis Doctoral Theory of Neural-Analogue Reinforcement

System and its Applications to the Brain-Model Problem.

1956 Holland, Habitt & Duda . . . . . . . . . Presentan una simulacion por computadora de la ley de aprendizaje

de Hebb.

1949 Hebb . . . . . . . . . . . . . . . . . . . . . . . . . . . Explica una regla de aprendizaje siologica para la modicaci on sinap-

tica.

1948 Wiener . . . . . . . . . . . . . . . . . . . . . . . . . . Establece las bases para la teora del control, comunicaciones y el

aprendizaje.

1943 MacCulloch & Pitts . . . . . . . . . . . . . Describen la operacion de una red neuronal y su modelo.

XI

INDICE DE TABLAS

INDICE DE TABLAS

xii JMFA

Simbologa

t R

+

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Tiempo continuo.

k Z

+

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . N umero de muestra (tiempo discreto).

i, j, n, r Z

+

. . . . . . . . . . . . . . . . . . . . . . Enteros positivos (ndices).

w

ij

, T

ij

R . . . . . . . . . . . . . . . . . . . . . . . . . . Peso de la conexion que va desde la salida de la neurona j hasta la

entrada de la neurona i.

() . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Funci on de activacion.

x R

nm

: [x]

T

. . . . . . . . . . . . . . . . . . . . . . . Transpuesta del matriz x.

f

(x),

f(x),

d

dx

f(x) . . . . . . . . . . . . . . . . . . . Derivada de la funci on f(x).

(A) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Si A es una matriz, (A) es el espectro de A (conjunto de valores

propios).

Ker(C) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Espacio nulo de la transformacion lineal denida por C.

det(A) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Determinante de la matriz A.

A1 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Indica que el subespacio 1 es invariante bajo la transformaci on lineal A.

B = Im(B) . . . . . . . . . . . . . . . . . . . . . . . . . . Espacio imagen de la transformacion lineal B.

o

=< A, B > . . . . . . . . . . . . . . . . . . . . . . . Espacio de alcanzable del par (A, B).

O

c

= O

c

(A, B) . . . . . . . . . . . . . . . . . . . . . . Es el espacio coordenado A-invariante mas grande incluido en el Ker(C).

J(k), E(k) R . . . . . . . . . . . . . . . . . . . . . . . Funci on de costo.

E(k)

wij

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Derivada parcial de E(k) con respecto a w

ij

.

Si y(k), x(x) R

n

:

y(k)

x(x)

. . . . . . . . . . . . . Jacobiano de y(x) con respecto al vector x(k).

Si y(k) R y x(x) R

n

:

y(k)

x(x)

. . . . . . . Gradiente de y(x) con respecto al vector x(k).

s

l

i

(k) =

n

l1

r=1

w

ir

x

n

l1

r

. . . . . . . . . . . . . . . Combinacion lineal de las entradas a la neurona i del nivel l.

l

i

(k) =

E(k)

s

l

i

(k)

. . . . . . . . . . . . . . . . . . . . . . . . Gradiente local del nodo i en el nivel l.

q

1

x(k + 1) x(k) . . . . . . . . . . . . . . . . . . Operador retardo.

M

1

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Matriz inversa de M.

dim

o

= n . . . . . . . . . . . . . . . . . . . . . . . . . Dimension del supespacio

o

.

XIII

INDICE DE TABLAS

INDICE DE TABLAS

xiv JMFA

Captulo 1

Introduccion: Redes Neuronales

En este captulo se exponen algunos de los fundamentos que introduce a la compresion de las redes neuronales, sus

principios biol ogicos y los modelos matematicos propuestos.

1.1. Redes Neuronales Biologicas

Las redes neuronales articiales son una muestra mas del interes humano por emular alguna de las capacidades

naturales de los seres vivos. Las redes neuronales biol ogicas exhiben caractersticas importantes que las hacen muy

atractivas para imitar; entre estas caractersticas se pueden citar las siguientes: memorizacion, especializaci on, paralelismo,

robustez, densidad, generalizacion y aprendizaje.

Los estudios sobre el sistema nervioso se remonta al a no de 1889, por las observaciones realizadas por el cientco

espa nol Santiago Ramon y Cajal (1852-1934, premio Nobel de Medicina 1906). Ramon y Cajal report o que el sistema

nervioso esta compuesto de unidades individuales que son estructuralmente independientes, cuyo contenido interno no

entra en contacto directo. Estas unidades son las celulas neuronales. A esta hip otesis se le conoce como teora neuronal.

Los seres vivos (agentes) poseen la habilidad de adaptarse a su ambiente. Los cambios externos son los estmulos y

las reacciones son su respuesta. En los seres mas simples la relacion causa-efecto es directa; esto signica que la presencia

de un estimulo dispara una reaccion determinada. En los seres mas complejos la respuesta a los estmulos implica la

integracion y sincronizacion de varios eventos de distintas partes del cuerpo, lo anterior es posible por la presencia de un

mecanismo de control (controlador) entre los estmulos y las reacciones. En los organismos multicelulares este controlador

emplea dos tipos de sistemas: la regulacion qumica y la regulacion nerviosa. En la regulacion qumica, sustancias llamadas

hormonas son fabricadas por un grupo bien denido de celulas y transportadas por la sangre a otras partes de cuerpo en

donde existen celulas objetivo, aqu las hormonas alteran el metabolismo de estas celulas o incitan la sntesis de otras

sustancias.

El sistema nervioso se dene como un grupo organizado de celulas llamadas neuronas, dedicadas a la conducci on de

impulsos (cambio breve de la carga electrica en la membrana de la celula) desde un receptor sensorial que atraviesa una

red de nervios hasta un efector. El sistema nervioso esta especializado en la conducci on de impulsos electricos, lo que

permite una rapida reaccion a los estmulos del ambiente.

En el ser humano se estima que existen 10, 000, 000, 000 de neuronas. En el cuerpo de una celula neuronal se identican

tres estructuras: el soma, el axon y las dentritas. El soma es el cuerpo principal de la neurona, en el se concentran los

organos responsables de su metabolismo y del intercambio electroqumico producido como respuesta de la neurona. El

axon es la extremidad mas larga de la neurona, es por donde se transmiten los impulsos nerviosos hacia otras neuronas,

es decir, representa la terminal de salida de la neurona. Las dentritas son varias extremidades de longitud mas corta

que el axon, su funci on es de ser las terminales receptoras de los impulsos provenientes de otras neuronas. Al punto de

transicion entre axon-dentrita se le llama sinapsis, en la gura 1.1 se presenta un dibujo de una celula neuronal, en

donde se pueden identicar las estructuras que la integran.

El mecanismo de conducci on de los impulsos nerviosos en las neuronas es diferente al usado por los metales. En las

neuronas la transmision electrica se debe al intercambio de iones (atomos que han ganado o perdido electrones); por el

1

1.1. Redes Neuronales Biol ogicas Captulo 1. Introducci on: Redes Neuronales

Axn

Soma

Dentrita

Sinapsis

Figura 1.1: Estructura de una neurona biol ogica. Se dis-

tinguen tres estructuras en una celula neuronal: el soma,

el ax on y las dentritas. La uni on dentrita-ax on se le llama

sinapsis. En el sistema nervioso se transmiten impulsos

electricos entre las neuronas. Los neurotransmisores son

sustancias qumicas que pasan de una celula a otra, y de-

nen el acomplamiento electrico entre ellas.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

contrario, en los metales la conducci on electrica es debido a la gran cantidad de electrones libres en ellos. Pero ademas

las neuronas utilizan un medio qumico para el acoplamiento electrico entre ellas. Los neurotransmisores son sustancias

qumicas que pasan de una celula a otra, estimulando un potencial electrico en la membrana de la celula receptora.

1.1.1. Modelo Matematico

En [1] se presenta un modelo matematico del comportamiento de una neurona biol ogica. Como en todo modelo se

intenta describir los procesos mas importantes que ocurren en el interior de una neurona descartando los efectos menos

perceptibles.

Sean u

j

el potencial electrico de la membrana de la neurona j y T

ij

f

j

(u

j

) la transformacion que este potencial

sufre al pasar por la sinapsis que lo conecta a la neurona i. El valor de T

ij

puede ser positivo o negativo de forma que

represente los iones positivos de potacio y sodio, K

+

, Na

+

; o negativos de cloro, Cl

en el cuerpo de la neurona.

La concentracion de potencial de la neurona i por esta uni on es la integral en el tiempo:

_

t

T

ij

f

j

(u

j

)d. (1.1)

El potencial que llega por cada uni on de la neurona i depende del tiempo; entre mas tarde en llegar el potencial a la

neurona, menos contribuye al potencial acumulado en la membrana. Para considerar este efecto se modica la ecuaci on

(1.1) incluyendo una funci on que es monot onicamente decreciente, h:

_

t

h(t +)T

ij

f

j

(u

j

) d, (1.2)

en donde h() una funci on que decae exponencialmente con el tiempo. La funci on h se suele seleccionar como una

exponencial decreciente en el tiempo:

h(t) =

1

i

e

i

, (1.3)

en donde

i

es la constante de tiempo de la neurona i;

i

> 0. De esta forma s olo los potenciales mas recientes (entre

t = 0 hasta aproximadamente t = 4

i

) contribuyen al potencial total.

En el modelo de la neurona se considera el caso de que exista una entrada independiente; es decir, que no proviene

de otra neurona. Para la neurona i esta entrada es denotada como I

i

. Por tanto, la contribuci on de esta entrada al

potencial de la neurona es igual a la expresion:

_

t

h(t +)I

j

()d. (1.4)

2 JMFA

Captulo 1. Introducci on: Redes Neuronales 1.2. Redes Neuronales Articiales

Ahora, como la neurona i recibe potenciales de varias otras, todas estas deben ser sumadas para determinar el

potencial total en la membrana de la neurona i. Si n es el n umero de estas conexiones, se establece que el potencial

total u

i

(t) es igual al termino:

u

i

(t) =

n

j=1

_

t

h(t +)T

ij

f

j

(u

j

) +

_

t

h(t +)I

i

()d. (1.5)

Para facilitar el tratamiento se preere la forma diferencial de la ecuacion (1.5). Entonces, sustituyendo (1.3) y

ordenando los componentes de (1.5) se logra la ecuacion:

d

dt

u

i

(t) =

d

dt

_

t

i

e

i

_

_

n

j=1

T

ij

f

j

(u

j

()) +I

i

()

_

_

d. (1.6)

Pasando la derivada dentro de la integral en (1.6) y aplicando la regla de la derivada para el producto, regla de

Leibnitz, la ecuacion (1.6) se transforma de la manera siguiente:

d

dt

u

i

(t) =

_

t

_

_

_

1

i

e

i

d

d

_

_

n

j=1

T

ij

f

j

(u

i

() +I

i

())

_

_

d

1

i

e

i

_

_

n

j=1

T

ij

f

j

(u

i

() +I

i

())

_

_

d

_

_

_

. (1.7)

El valor de la primera integral en (1.7) se obtiene al sustituir por t, y sustituyendo en el segundo termino la parte

que corresponde a u

i

. De este modo la expresion para el potencial de la neurona u

i

(1.7) adquiere la estructura nal:

i

d

dt

u

i

(t) = u

i

() +

_

_

n

j=1

T

ij

f

j

(u

i

() +I

i

())

_

_

; i = 1, ..., n.

i

> 0. (1.8)

De la expresion (1.8) se desea destacar que a un en este modelo simplicado de una celula neuronal se observa que

su comportamiento esta matematicamente modelado por un sistema dinamico.

Los valores que toman los parametros T

ij

depende de la interaccion de la neurona con su ambiente, es por esto

que se estima que la informacion en la neurona esta jado por los valores de los parametros T

ij

. La respuesta de cada

neurona depende del efecto que tienen las neuronas con las que esta conectada. Se forma una estructura de neuronas

interconectadas; la transferencia de informacion se realiza entre las sinapsis y la respuesta de cada neurona depende del

potencial en su cuerpo.

En la seccion 1.2 se describen algunos de los modelos matematicos para las redes neuronales articiales, sus topologas

y los paradigmas de aprendizaje.

1.2. Redes Neuronales Articiales

Con la denominacion de Redes Neuronales Articiales, desde el punto de vista computacional, se conoce a todos los

modelos matematicos y de calculo que intentan imitar las capacidades y caractersticas de sus semejantes biol ogicos.

La redes neuronales articiales estan formadas por elementos relativamente simples de calculo, todos ellos inter-

conectados con una cierta organizacion (topologa). Las neuronas, llamadas perceptrones (Rossenblatt, 1958) o Adaline

(Widrow y Ho) que integran la red pueden ser tan simples como s olo puntos de suma, hasta elementos dinamicos

complejos.

El modelo basico de una neurona esta constituido por los siguientes elementos:

Un conjunto de sinapsis, que son las entradas de la neurona ponderadas, por un peso. Se identica al peso que

conecta a la entrada x

j

de la neurona i por smbolo w

ij

. Se incluye un peso independiente, w

i0

, que se adquiere

al suponer una entrada constante a la neurona i

1

1

El peso w

i0

se le llama de compensaci on (bias) cuando la entrada asociada tiene valor de 1, y se le llama umbral (threshold) cuando

la entrada asociada tiene valor de 1.

JMFA 3

1.2. Redes Neuronales Articiales Captulo 1. Introducci on: Redes Neuronales

Un sumador, que simula el cuerpo de la neurona y ja el nivel de exitacion.

Una funci on de activacion, que genera la salida de la neurona y es la transformacion del nivel de exitaci on de la

neurona y restringe el nivel de salida.

Opcionalmente en [2], se incluye entre el sumador y la funci on de activacion una dinamica lineal de primer orden,

o un retardo en su forma continua o discreta, al hacer esto, se implica una dinamica interna al comportamiento de la

neurona. En otra seccion se trata este tema (seccion 1.2.3).

En su forma basica, la salida de una neurona esta jada por la expresion:

y

i

=

_

n

r=1

w

ir

x

r

w

i0

_

, (1.9)

en donde n indica el n umero de entradas a la neurona i.

Notar que el argumento de la funci on de activacion es la combinacion lineal de las entradas de la neurona. Si se

considera al conjunto de entradas y los pesos de la neurona i como un vector de dimension (n + 1), la expresi on (1.9)

puede escribirse de la siguiente forma:

y

i

=

_

w

T

i

x

_

; x = [1, x

1

, . . . , x

n

]

T

, w

i

= [w

i0

, w

i1

, . . . , w

in

]

T

, (1.10)

en donde []

T

indica la transposi on del vector. En la gura 1.2 se presenta el esquema de una neurona o perceptr on.

(

*

)

wi0

wi1

win

x1

xn

-1

y

i

Pesos

sinapticos

Entradas

Sumador

compensacin

(bias)

s(

*

)

Funcin

de Activacin

Figura 1.2: Neurona articial elemental. Ca-

da elemento b asico de calculo en una red neu-

ronal esta formado por un grupo de constantes

que ponderan la entrada a un sumador y la

salida es acotada por la funci on de activaci on.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

En lo que se reere a los tipos de funciones de activacion, las mas utilizadas son la funci on a) escal on, b) sigmoide,

c) tangente hiperb olica y d) saturacion, gura 1.3.

Tangente Hiperblico:

Tanh(x)

1

-1

Escaln: (x)

1

-1

Sigmoide: Sigm(x)

1

0.5

Saturacin: Sat(x)

1

-1

Figura 1.3: Funciones de activaci on co-

munes. a) Escal on. b) Sigmoide. c) Tangente

hiperbolica. d) Saturaci on. La funci on de acti-

vaci on en una neurona acota el nivel de salida.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4 JMFA

Captulo 1. Introducci on: Redes Neuronales 1.2. Redes Neuronales Articiales

Estas funciones de activacion estan denidas por las expresiones:

(a (x) =

_

1 si x 0

0 si x < 0

(b sigm(x) =

1

1+e

x

,

(c tanh(x) =

1e

2x

1+e

2x

, (d sat(x) =

_

_

1 si x < 1

x si [x[ 1

1 si x > 1

.

(1.11)

Una propiedad de las funciones sigmode y tangente hiperb olica es que su derivada existe y es una funci on continua.

El calculo de la derivada de la funci on de activacion sigmoide se realiza de la siguiente manera:

d

dx

(sigm(x)) =

d

dx

_

1

1 +e

x

_

=

e

x

(1 +e

x

)

2

=

e

x

1 +e

x

1

1 +e

x

,

=

1 1 +e

x

1 +e

x

1

1 +e

x

=

_

1

1

1 +e

x

_

1

1 +e

x

= [1 sigm(x)] sigm(x). (1.12)

La derivada de la funci on de activacion tangente hiperb olica esta descrita por la expresion:

d

dx

(tanh(x)) =

d

dx

_

senh(x)

cosh(x)

_

=

cosh(x)

2

sen(x)

2

cosh(x)

2

=

= 1 tanh(x)

2

. (1.13)

De esta manera, las derivadas de estas funciones de activacion quedan en funci on de ellas mismas, esto sera util para

interpretar el algoritmo de ajuste de los pesos de la red neuronal como un proceso transferencia de informaci on en sentido

contrario, ver seccion 1.2.4. En la gura 1.4, se presentan las gracas de las derivadas de las funciones de activaci on.

1

Derivada Tangente Hiperblico

d/dx[Tanh(x)]

0.25

Derivada Sigmoide

d/dx[Sigm(x)]

Derivada Saturacin

d/dx[Sat(x)]

1

-1

Derivada Escaln

Delta de Dirac

d/dx[ (x)]= (x)

1

Figura 1.4: Derivadas de las funciones

de activaci on. Las derivadas de las fun-

ciones de activaci on sigmoide y tangente

hiperbolica son funciones continuas.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

La ecuacion (1.9) es com un a diferentes modelos de neuronas. En cada uno de los pesos w las neuronas almacenan

la informacion sobre su forma de responder a la exitacion en la entrada. Pero tambien es importante reexionar sobre la

organizacion que las neuronas conservan dentro de una red, debido a que la respuesta colectiva potencializa la capacidad

de las neuronas individuales.

JMFA 5

1.2. Redes Neuronales Articiales Captulo 1. Introducci on: Redes Neuronales

1.2.1. Topologas

Como se ha mostrado en las secciones anteriores, las redes neuronales biol ogicas y articiales estan construidas en

base a elementos de calculo relativamente simples, que son capaces de aprender de su ambiente y modicar su forma

de reaccionar ante el. Al modo en que las neuronas se organizan en la red se le conoce como Topologa. En las redes

neuronales articiles se clasican en tres organizaciones elementales: una sola capa, de m ultiples capas, y en malla, ver

la gura 1.5.

Red Neuronal

de

Mltiples capas

Red Neuronal

en malla

Red Neuronal

de

una capa

Figura 1.5: Topologas de redes neuronales articiales. Se clasican en tres estructuras los

arreglos de neuronas: en una capa, m ultiples capas y en malla.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

En las redes neuronales, el modelo usado para las neuronas es quien le provee de su capacidad de adaptaci on, debido

al conjunto de pesos ajustables que tiene. Pero otras caractersticas importantes de las redes se basan en la organizaci on

que conserva cada neurona en la red; por ejemplo: de la dimensiones de la red puede depender que esta sea capaz de

asimilar la informacion que los patrones de entrenamiento contienen. Las siguientes son algunas caractersticas que las

redes neuronales tiene por su organizacion interna.

Caractersisticas

de las redes neuronales

debidas a su topologa.

_

_

Paralelismo.

Representaci on y calculo distribuido.

Inherente procesamiento contextual de la informacion.

Tolerancia a fallas.

Otra clasicacion para las redes neuronales se basa en la manera en que la informacion se transmite en la red. Se dividen

en dos grupos: redes con conexiones hacia adelante (estaticas) y redes neuronales recurrentes (con retroalimentaciones)

o dinamicas, ver la gura 1.6.

En la pr oxima seccion se presentan las redes neuronales estaticas, se dan sus modelos y principales caractersticas.

1.2.2. Redes Neuronales Articiales Estaticas

Si la respuesta de una red neuronal depende unicamente de sus entradas se dice que es una red neuronal estatica; es

decir, que realiza un mapeo desde el espacio de entrada al espacio de salida, y por tanto, la respuesta de la red neuronal

para cada entrada no depende del tiempo en el cual se aplica, ni de se nales de instantes anteriores.

Existen dos tipos de redes neuronales estaticas que han sido extensamente estudiadas, estas son: Las redes neuronales

de m ultiples capas o niveles (RNMC), y las redes neuronales de funciones radiales basicas (RNFRB).

Redes Neuronales de M ultiples Capas

Estas redes neuronales estan construidas por neuronas organizadas en capas. Cada nivel de la red tiene como entrada

a todas o un conjunto de las salidas de la capa anterior. Un ejemplo de una red neuronal con m ultiples capas se presenta

6 JMFA

Captulo 1. Introducci on: Redes Neuronales 1.2. Redes Neuronales Articiales

Redes Neuronales

Estticas Dinmicas

Perceptrn de

Mltiples Capas

Redes de Funciones

Radiales Bsicas

Redes Competitivas

Redes de KOHONEN

Redes de HOPFIEL

Adaptive Resonance Theory

ART

Perceptrn de una Capa

Figura 1.6: Tipos de redes neuronales. Las redes neuronales pueden clasicarse en dos grupos: redes neuronales

estaticas y redes neuronales din amicas (recurrentes).

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

en la gura 1.7. La primera capa de la red es la de entrada; su funci on es la de distribuir las entradas de la red en la

primera capa oculta. La ultima capa genera las salidas de la red neuronal y las capas que se localizan entre la primera

y la de salida se les denomina ocultas. La conguraci on o topologa que se presenta en la gura 1.7 se expresa como:

2 , 3, 4, 3, esto signica que esta red neuronal tiene dos entradas; la primera capa oculta con tres neuronas; la segunda

capa oculta con cuatro neuronas y la capa de salida con tres neuronas.

No. de capas de la red L

No. de entradas de la red n

0

No. nodos de la capa i (i = 1, . . . , L 1) n

i

No. de salidas de la red n

L

Tabla 1.1: Topologa de una red neuronal m ultiples

capas: n

0

, . . . , n

L

; n

0

indica el n umero de neu-

ronas en la capa de entrada, n

i

es el n umero de

neuronas en la capa i, n

L

es el n umero de salidas de

la red neuronal.

En la gura 1.7 se observan a:

l

i

, s

l

i

y x

l

i

que representan la funci on de activacion, la combinaci on lineal de las

entradas y la salida del nodo i en la capa l, respectivamente. Las entradas de compensacion: x

0

y x

l

0

se hacen igual a

1. Notar que para la capa de salida x

L

i

= y

i

; i = 1, . . . , n

L

. Donde W

l

= [w

ij

]; i = 1, . . . , n

l

; j = 1, . . . , n

l1

es la

matriz de pesos de la capa lesima, en donde cada la i contiene los parametros que ponderan a las entradas del nodo

(neurona) i que pertenece la capa l.

El ujo de informacion se transmite en un s olo sentido. De manera que una red neuronal de m ultiples capas es un

mapeo no lineal entre el espacio de entrada, A, al espacio de salida, }; es decir: A }. El ujo de la informaci on se

describe por las ecuaciones:

x

0

= [1, x

1

, . . . , x

no

]

T

; (1.14)

s

l

= W

l

x

l1

; (1.15)

l

= [

l

1

, . . . ,

l

n

l

]

T

, (1.16)

x

l

=

l

_

s

l

_

; 1 < l L; (1.17)

x

L

= y = [y

1

, . . . , y

nL

]

T

, (1.18)

JMFA 7

1.2. Redes Neuronales Articiales Captulo 1. Introducci on: Redes Neuronales

W

x

s

1

1

s

1

2

s

1

3

1

1

1

2

1

3

x

1

3

x

1

2

x

1

1

s

2

3

s

2

4

s

2

2

s

2

1

2

1

2

2

2

3

2

4

x

2

3

x

2

2

x

2

1

x

2

4

s

3

3

s

3

2

s

3

1

3

1

3

2

3

3

x

3

1

=

y1

x

3

2

=

y2

x

3

3

=

y3

x

1

2

1 xo

=

x

1

o

=

1

x

2

o

=

1

1

W

2 W

3

Capa de

Entrada

1

er

Capa

Oculta

2

da

Capa

Oculta

3

er

Capa

Oculta (salida)

Figura 1.7: Red neuronal de m ulti-

ples capas. Esta red neuronal tiene

dos entradas; una capa oculta con

tres neuronas; una segunda capa

oculta con cuatro neuronas y una

capa de salida con tres neuronas.

Topologa 2, 3, 4, 3

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

en donde s

l

, x

l

son vectores y sus componentes son la suma ponderada y salidas de los nodos en la capa l, respectivamente.

Redes de Funciones Radiales Basicas

Un inconveniente de las redes neuronales de m ultiples capas es que su entrenamiento (ajuste de pesos) es lento; la

minimizacion del ndice cuadratico del error de salida requiere de comparar en varias ocasiones del conjunto de datos de

entrenamiento con la respuesta de la red neuronal.

Las redes neuronales de funciones radiales basicas son una alternativa a las redes neuronales de m ultiples capas.

En partes de la corteza celebral y visual se encuentran campos receptivos que se interceptan y que son localmente

sintonizados. Las funciones radiales basicas se basan en estos sistemas biol ogicos. En la gura 1.8 se presenta este tipo

de red neuronal.

x

x

1

2

1

x

3

W

y

R

n

R

1

Figura 1.8: Red neuronal de funciones radiales b asicas.

Este tipo de red neuronal tiene un entrenamiento r apido,

debido a que el valor de los pesos se actualiza fuera de

lnea.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

En la gura 1.8 x

i

, i = 1, 2, . . . , n; la salida es y = F

fr

(x); R

i

son funciones radiales; por ejemplo: la funci on de

Gauss. Si se supone que la red neuronal tiene n

R

nodos, entonces de la gura 1.8 se deduce que la salida de este tipo

de red neuronal se expresa de la forma:

y = F

fr

(x, ) =

nr

i=1

w

i

R

i

(x). (1.19)

en donde esta integrada por los parametros w

i

. Hay varias opciones para las funciones radiales basicas, R

i

(x), siendo

lo mas com un utilizar la funci on de Gauss:

R

i

(x) = e

|xc

i

|

2

2

i

(1.20)

en donde c

i

representa los centros de la funci on;

i

es un escalar y dene el radio de la funci on de activaci on.

8 JMFA

Captulo 1. Introducci on: Redes Neuronales 1.2. Redes Neuronales Articiales

Redes Neuronales EstaticasAplicaciones

Las principales tareas para las cuales se aplican las redes neuronales estaticas son aquellas en donde es necesario

construir una relacion funcional entre la entrada y la salida, como ejemplos de aplicaciones se tienen las listadas a

continuaci on:

1. Clasicacion de Patrones.

2. Aproximacion de Funciones.

3. Memoria Asociativa.

1.- Clasicaci on de Patrones: Sea p una muestra que pertenece a un conjunto T, y c es un designador de clase.

Se dice que p es de clase c, si existe una funci on f, tal que:

f : p c. (1.21)

A todas las muestras p en que cumplen (1.21) forman la clase (:

( = p T[f : p c . (1.22)

2.- Aproximaci on de Funciones: Dada una funci on f : x y, en donde x A

n

, y }

m

. Encontrar

una

f tal que:

_

_

_f(x)

f(x)

_

_

_ < ; x A. (1.23)

en donde es un entero positivo peque no. Se dice que

f es una aproximacion en A de f.

3.- Memoria Asociativa: En la actualidad las computadoras tienen memorias direccionadas, es decir memorias

que necesitan como informacion de entrada una direccion para recuperar un dato, esto las hace que tengan una

estructura rgida; en consecuencia tienen un tiempo de escritura y lectura grande. Una memoria asociativa, por

el contrario, no requiere de una direccion especca para recuperar un dato guardado en ella, lo que necesita es

otro dato; es decir, que en este tipo de memorias se recupera la informacion por la asociacion impuesta sobre su

contenido. Este modo de operar hace a una memoria asociativa mas rapida en la recuperacion de la informaci on.

En las anteriores tareas las redes neuronales estaticas han tenido exito para su soluci on. Pero como se ha visto,

las neuronas biol ogicas de forma natural son modeladas como sistemas dinamicos. En las siguientes secciones se daran

algunos ejemplos de redes neuronales articiales modeladas como sistemas dinamicos.

1.2.3. Redes Neuronales Articiales Dinamicas (Recurrentes)

En las redes neuronales estaticas su respuesta es independiente del tiempo. En consecuencia, una vez que se han

ajustado sus parametros, la respuesta a una entrada determinada sera la misma, no importando en que instante la entrada

se presente. Las redes neuronales estaticas son muy utiles en los problemas de clasicacion de patrones y aproximaci on

de funciones porque construyen aplicaciones no lineales entre el espacio de entradas al espacio de salidas de las variables

involucradas. En teora, se tiene la certeza de que una red neuronal de conexiones haca adelante con una capa oculta

no lineal y una capa de salida lineal puede aproximar cualquier funci on con el grado de precision que se desee, ver las

referencias [3, 4, 5].

Hay problemas que necesitan de un sistema que tenga una respuesta dependiente de su estado anterior. Y por tanto,

requieren de estructuras que tengan una dinamica interna propia. Si la respuesta de una red neuronal depende de su

pasado se dice que es una red neuronal dinamica. Algunas de las tareas para este tipo de redes neuronales son: la predici on

de series, la identicacion y el control de sistemas dinamicos.

Existen diversos modelos de redes neuronales dinamicas. Algunos de ellos se basan en los modelos estaticos que por

medio de lneas de retardo retroalimentan alguna de las se nales generadas por la red, ver las referencias [8, 9, 10]. Otros

modelos tienen lneas de retroalimentacion en cada una de las neuronas y que act uan como memorias de corto plazo, [6].

Las redes neuronales recurrentes se han usado para mejorar el desempe no en problemas de clasicaci on que habian

sido resueltos por medio de redes neuronales estaticas. Dos modelos de redes neuronales que se han ocupado con este

objetivo son:

JMFA 9

1.2. Redes Neuronales Articiales Captulo 1. Introducci on: Redes Neuronales

Red de Hopeld.

Maquina de Boltzmann.

Red de Hopeld

La red de Hopel es una de las redes neuronales dinamicas que mas han sido estudiadas. Consiste en nodos ordenados

en una s ola capa, con lazos de retroalimentacion interiores y exteriores.

El modelo de la neurona de Hopeld en su forma discreta esta denida por la expresion:

x

i

(k + 1) = p

i

x

i

(k) +

n

j=1

w

ij

j

(x

j

(k)) +u

i

(k), (1.24)

en donde p

i

< 1 es el coeciente de retroalimentacion interna; x

i

es el estado interno del nodo i; () es la funci on de

activacion; w

ij

son los pesos sinapticos de la neurona, ver gura 1.9

z

-1

(

*

)

+

p

i

x(k+1) x(k)

i,1 w

wi, n

n

u

i

Figura 1.9: Neurona de Hopeld. La salida de la red neu-

ronal se retroalimenta hacia la entrada de cada neurona.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Algunas de las aplicaciones de esta red estan en los problemas de clasicacion, analisis de imagenes y como memoria

asociativa (memoria que almacena y recupera la informacion por medio de un analisis del contexto de la informaci on).

En la gura 1.10 se presenta una red de Hopeld con tres neuronas.

z

-1

(

*

)

+

p

1

x(k+1) x(k)

u

1

z

-1

(

*

)

+

p

2

x(k+1) x(k)

u

2

z

-1

(

*

)

+

p

3

x(k+1) x(k)

u

3

1

y

2

y

2

y

1 1

2 2

3 3

Figura 1.10: Red de Hopeld con tres neuronas. En una

red de Hopeld se retroalimentan las se nales internas y

externas.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Maquina de Boltzmann

La maquina de Boltzmann es una extension de la red de Hopeld que incluye nodos ocultos y con una regla estocastica

de ajuste de los pesos. Los pesos en esta red son simetricos y su actualizacion esta basado en el principio de templado

simulado (annealing), en donde un material es calentado y enseguida es enfriado de forma lenta, como resultado el

material presenta una estructura cristalina ordenada sin impurezas de manera que el sistema se encuentra en un estado

de muy baja energa, gura 1.11.

10 JMFA

Captulo 1. Introducci on: Redes Neuronales 1.2. Redes Neuronales Articiales

1 2 3

1 2 3

L

K

Neuronas

Ocultas

Neuronas

Visibles

Figura 1.11: M aquina de Boltzmann. Esta es una red neu-

ronal con una tecnica de aprendizaje de tipo estoc astico.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

La maquina de Boltzmann es una maquina estocastica formada por neuronas estocasticas. Una neurona estocastica

esta en uno de dos estados posibles de manera probabilstica. Las neuronas de la maquina de Boltzmann se dividen en dos

grupos: las visibles y las ocultas. Las neuronas visibles son una interface entre la red y el ambiente en el cual esta opera.

Durante la fase de entrenamiento las neuronas visibles son obligadas a permanecer en un estado que es determinado por

el ambiente. Las neuronas ocultas, por el contrario, son libres de tomar cualquiera de los estados.

Redes Neuronales Localmente Recurrrentes

En el artculo [7] se analizan diversas estructuras de redes neuronales recurrentes, en particular, una clase de redes

que tienen retrolimentaciones locales o internas, pero cuya estructura global es la de una red de conexiones directas

(local-recurrent-global-feedforward). En la gura 1.12 se presentan cuatro estructuras que en [7] se citan.

En la gura 1.12.a se presenta el modelo de Lapedes-Farber. En este modelo una neurona esta descrita por medio

de la expresion:

y(t) = f [a(t)] ; a(t) =

n

i=1

w

i

x

i

, (1.25)

en donde x

i

, i = 1, 2, . . . , n son las entradas a la neurona y w

i

, i = 1, 2, . . . , n son pesos constantes. En este modelo

la se nal de activacion de la neurona, a(t), es la suma ponderada de las entradas. A partir de modelo se derivan tres

metodos para incorporar alg un tipo de retroalimentacion:

1.- Retroalimentaci on local de la activaci on neuronal: gura 1.12.b . En este tipo las entradas son una ver-

sion retardada de la se nal de activacion local; es decir, x

i

= a(t i), i = 1, 2 . . . , n, o una combinaci on de una

version retardada de la se nal de activacion local y de la se nal de entrada.

2.- Retroalimentaci on local de la sinapsis: gura 1.12.c . En este tipo de red neuronal cada sinapsis incorpora

una estructura de retroalimentacion. Notar que la retroalimentacion local de la activacion neuronal, es un caso

especial de esta estructura. En esta estructura cada sinapsis se considera como si fuera una retroalimentaci on local,

y la activacion local de cada sinapsis es a nadida antes de entrar a la funci on no lineal f().

3.- Retroalimentaci on local de la salida: gura 1.12.d . En este tipo las entradas de la red son de la forma:

x

i

= y(t i), i = 1, 2, . . . , n; es decir, que ahora las entradas son las versiones retardadas de la se nal de salida o

que hay una retroalimentacion alrededor de la funci on no lineal.

En la seccion que sigue se presenta un grupo de modelos de red neuronal recurrente que son utiles para los problemas de

identicacion y control de sistemas dinamicos. Se basan en la representacion de los sistemas dinamicos como dependientes

de sus condiciones en el pasado, ver [9, 8].

Modelo NARMA de una Red Neuronal Dinamica

Sea un sistema dinamico no lineal discreto con una entrada, u() y una salida, y(). Su comportamiento dinamico se

describe por la expresion:

y(k + 1) = F [y(k), . . . , y(k n); u(k), . . . , u(k m)] , (1.26)

JMFA 11

1.2. Redes Neuronales Articiales Captulo 1. Introducci on: Redes Neuronales

f(

.

)

a(t) y(t)

w

1

w

2

w

n

x

1

x

2

x

n

f(

.

)

Sistema

dinmico