Documente Academic

Documente Profesional

Documente Cultură

Retele Neuronale Distribuite

Încărcat de

Ion PereuTitlu original

Drepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Retele Neuronale Distribuite

Încărcat de

Ion PereuDrepturi de autor:

Formate disponibile

Reţea neurală

De la Wikipedia, enciclopedia liberă

Reţelele neurale[1] (RN, în engleză: ANN de la artificial neural network) Inteligenţă artificială

sunt o ramură din ştiinţa inteligenţei artificiale, şi constituie totodată, GOFAI

principial, un obiect de cercetare şi pentru neuroinformatică. Reţelele Căutare în spaţiul stărilor

neurale artificiale caracterizează ansambluri de elemente de procesare Planificare automatizată

simple, puternic interconectate şi operând în paralel, care urmăresc să Căutare combinatorială

interacţioneze cu mediul înconjurător într-un mod Sistem expert

asemănător creierelor biologice şi care prezintă capacitatea de a învăţa. Reprezentarea cunoaşterii

Ele sunt compuse din neuroni artificiali, sunt parte a inteligenţei artificiale Sistem bazat pe cunoaştere

şi îşi au, concepţional, originea ca şi neuronii artificiali, în biologie. Nu Conecţionism

există pentru RNA o definiţie general acceptată a acestor tipuri Reţele neuronale

de sisteme, dar majoritatea cercetătorilor sunt de acord cu definirea Viaţă artificială

IA distribuită

reţelelor neurale artificiale careţele de elemente simple puternic

Programare genetică

interconectate prin intermediul unor legături numite interconexiuni prin Algoritm genetic

care se propagă informaţienumerică. Inteligenţă "roi"

Originea acestor reţele trebuie căutată în studierea reţelelor bioelectrice Fiinţă artificială

din creier formate de neuroni şi sinapsele acestora. Principala trăsătură Metoda empirică Bayes

a acestor reţele este capacitatea de a învăţa pe bază de exemple, Reţea bayesiană

Învăţare la maşini

folosindu-se de experienţa anterioară pentru a-şi îmbunătăţi

Recunoaşterea tiparelor

performanţele.

Sisteme Fuzzy

Logică fuzzy

Cuprins

Electronică fuzzy

[ascunde] Filozofie

IA Puternică

1Structură Conştiinţă artificială

o 1.1Caracteristici Test Turing

1.1.1Modele ale neuronului artificial Etică

1.1.2Arhitecturi

1.1.3Algoritmi de învăţare

2Aplicaţii în viaţa de zi cu zi

3Istoric

4Note

5Bibliografie

Structură[modificare | modificare sursă]

Deşi se aseamănă în funcţionare cu creierul uman, reţelele neurale au o structură diferită de cea

a creierului. O reţea neurală este mult mai simplă decât corespondentul său uman, dar la fel ca

şi creierul uman, este compusă din unităţi puternice cu capacitate de calcul, mult inferioare însă

corespondentului uman, neuronul.

Caracteristici[modificare | modificare sursă]

Reţelele neurale artificiale se pot caracteriza pe baza a 3 elemente:

modelul adoptat pentru elementul de procesare individual,

structura particulară de interconexiuni (arhitectura)

mecanismele de ajustare a legăturilor (de învăţare).

Modele ale neuronului artificial[modificare | modificare sursă]

Sunt mai multe criterii de clasificare a modelelor neuronului elementar, ce implică: domeniul de

definiţie a semnalelor folosite, natura datelor folosite, tipul funcţiei de activare, prezenţa memoriei.

Dar cel mai utilizat model este modelul aditiv.

Arhitecturi[modificare | modificare sursă]

Există numeroase modalităţi de interconectare a neuronilor elementari, dar pot fi identificate două

clase de arhitecturi:

cu propagare a informaţiei numai dinspre intrare spre ieşire, reţele de tip feedforward

reţele recurente (cu reacţie).

Un dezavantaj al reţelelor neurale îl constituie lipsa teoriei care să precizeze tipul reţelei şi numărul

de neuroni elementari, precum şi modalitatea de interconectare. Există câteva tehnici de

tip pruning sau de tip learn and grow, dar acestea sunt în intense cercetări.

Algoritmi de învăţare[modificare | modificare sursă]

Principala deosebire a reţelelor neurale faţă de alte sisteme (electronice) de prelucrare a

informaţiilor îl constituie capacitatea de învăţare în urma interacţiunii cu mediul înconjurător, şi

îmbunătăţirii performanţelor. O reprezentare corectă a informaţiilor, care să permită interpretarea,

predicţia şi răspunsul la un stimul extern, poate permite reţelei să construiască un model propriu al

procesului analizat. Acest model va putea răspunde astfel unor stimuli neutilizaţi

în procesele anterioare de învăţare ale reţelei RNA. Informaţiile utilizate în procesul de învăţare pot

fi: informaţii disponibile a priori sau perechi intrare-ieşire(care stabilesc relaţii de tipul cauză-efect),

iar modul de reprezentare internă urmăreşte un set de reguli bine documentate. Aceşti algoritmi pot

fi clasificaţi după mai multe criterii cum ar fi:disponibilitatea răspunsului dorit la ieşirea

reţelei, existenţa unui model analitic, tipul aplicaţiei în care sunt utilizaţi, dar cele mai multe

documentaţii se rezumă la două clase mari: învăţarea supravegheată (care presupune existenţa în

orice moment a unei valori dorite a fiecărui neuron din stratul de ieşire) şiînvăţarea

nesupravegheată (în care reţeaua extrage singură anumite caracteristici importante a datelor de

ieşire, în urma unui gen de competiţie între neuronii elementari). În ultima perioadă se remarcă încă

o clasă de algoritmi, algoritmii de învăţare folosind un critic, rezultaţi în urma observaţiilor

experimentale făcute pe animale, acestia fiind de tipul recompensă/pedeapsă.

Aplicaţii în viaţa de zi cu zi[modificare | modificare sursă]

Domeniile în care reţelele neurale realizează modele eficiente sunt :

Aproximări de funcţii

Predicţii ale unor serii temporale

Clasificări

Recunoaştere de tipare

Recunoaştere vocală

Scanarea retinei

Învăţarea robotului care se verifică în mod constant cu un om

Astfel de implementări ale reţelelor neurale, legate de sectorul bussines se întâlnesc în:

previziuni financiare

controlul proceselor industriale

cercetări de piaţă

validări de date pe bază de clasificări şi de tipare

management de risc

previziuni de marketing

Reţele neurale folosind algoritmi genetici pot fi folosite în controlul roboţilor industriali. Un alt

domeniu de interes pentru reţelele neurale este medicina şi sistemele biomedicale. În acest moment

se utilizează reţele neurale pentru descoperirea de boli, prin recunoaşterea unor tipare de

pe cardiograme, ş.a.

Istoric[modificare | modificare sursă]

Studiul reţelelor neurale a cunoscut perioade în care activitatea de cercetare a fost extrem de

intensă şi perioade în care acesta domeniu de cercetare a fost declarat complet „mort”, pentru ca

apoi să revină în centrul atenţiei, atât în rândul cercetătorilor cât şi a publicului larg prin multitudinea

de aplicaţii practice pe care le au sau le pot avea.

Primi paşi au fost făcuţi la sfârşitul secolului al XIX-lea şi începutul secolului al XX-lea, de

către Hermann von Helmholz, Ernst Mach şi Ivan Pavlov care au emis teorii asupra procesului de

învăţare, asupra condiţionării, etc. Aceste teorii nu au adus nici un fel de modele matematice şi nu

se putea vorbi încă de un început. Adevăratul punct de pornire al acestui domeniu se situează la

începtul anilor 1940 când Warren McCulloch şi Walter Pitts au pus în evidenţă primul model formal

al neuronului, evidenţiind capacitatea de calcul a acestuia şi posibilitatea de implementare cu

ajutorul circuitelor electronice. Cei doi au oferit o primă abstractizare matematică a neuronului.

Astfel:

1. Sinapsele pe care un neuron le făcea prin dendrite cu alţi neuroni au devenit intrări;

2. Corpul neuronului a devenit un sumator şi o funcţie de activare (numită şi funcţie de

TRANSFER)

3. Axonul a devenit ieşirea

4. Pentru a reprezenta caracteristici neliniare simple s-a introdus noţiunea de bias

Pe la sfârşitul anilor 1940, Hebb, având la bază teoriile lui Pavlov, a enunţat principiul adaptării

permeabilităţii sinaptice conform căruia de fiecare dată când o conexiune sinaptică este folosită,

permeabilitatea ei creşte. Acest principiu stă la baza procesului de învăţare prin modificarea

ponderilor sinaptice.

În anii 1950 apare şi prima aplicaţie practică, Frank Rosenblatt realizează o implementare hard,

numită perceptron, utilizată în recunoaşterea caracterelor. Tot în anii 1950 Bernard Windrow şi Ted

Hoff dezvoltă algoritmi de învăţare pentru reţele neurale liniare cu un singur nivel de unităţi

funcţionale. Algoritmii lor sunt bazaţi pe minimizarea erorii pe setul de date de antrenare. În anul

1969 Marvin Minsky şi Seymor Papert publică cartea "Perceptrons" care pune în evidenţă limitările

la care sunt supuse reţelele neurale cu un singur nivel de unităţi funcţionale. Acesta părea a fi

sfârşitul reţelelor neurale. Publicarea acestui material, corelată cu lipsa unor echipamente de calcul

digital suficient de puternice, face ca o mare parte din companiile care investeau în cercetările din

acest domeniu să se reorienteze, iar o mare parte dintre cercetători îşi abandonează studiul în

această direcţie.

Anii 1970 sunt mult mai liniştiţi şi doar câţiva cercetători mai sunt cu adevărat activi în domeniu.

Printre ei merită amintiţi Teuvo Kohonen, Sames Anderson precum şi Stephen Grossberg (foarte

activ în cercetarea reţelelor cu auto-organizare).

Anii 1980 aduc, pe lângă noi descoperiri în domeniul reţelelor neurale, şi calculatoare digitale mai

puternice capabile să ajute cercetătorii în demersurile lor. Astfel că la începutul anilor 1980, odată cu

o nouă abordare a reţelelor folosind formalismul fizicii statistice prin punerea în evidenţă a analogiei

între reţelele recurente (destinate memorării asociative) şi sistemele de spini magnetici propusă

de John Hopfield se marchează începutul unei noi perioade de interes în domeniu, caracterizată prin

extinderea domeniilor de aplicabilitate şi volumul mare de implementări soft şi hard folosite în

aplicaţiile practice.

S-ar putea să vă placă și

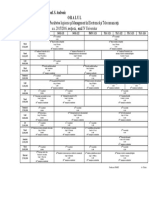

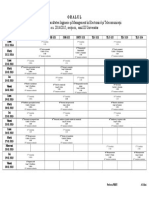

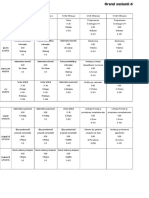

- Anul II F RDocument3 paginiAnul II F RGonta VasileÎncă nu există evaluări

- Orar Anul IIIDocument9 paginiOrar Anul IIIIon PereuÎncă nu există evaluări

- Orar Iarna FRDocument18 paginiOrar Iarna FRIon PereuÎncă nu există evaluări

- Orar Anul IIIDocument9 paginiOrar Anul IIIIon PereuÎncă nu există evaluări

- 3UA1Document2 pagini3UA1Ion PereuÎncă nu există evaluări

- 4UDocument1 pagină4UIon PereuÎncă nu există evaluări

- Oralul: Decanul FIMET Conf. S. AndronicDocument1 paginăOralul: Decanul FIMET Conf. S. AndronicIon PereuÎncă nu există evaluări

- Grafic Susținerii Tezei de LicențaDocument1 paginăGrafic Susținerii Tezei de LicențaIon PereuÎncă nu există evaluări

- Ciclu Prelegeri TVPPDocument100 paginiCiclu Prelegeri TVPPMihai CoșlețÎncă nu există evaluări

- Orar Ses Vara FRDocument6 paginiOrar Ses Vara FRIon PereuÎncă nu există evaluări

- Managementul Intreprinderii Pe PuncteDocument21 paginiManagementul Intreprinderii Pe PuncteIon PereuÎncă nu există evaluări

- 4UA1 AuleDocument1 pagină4UA1 AuleAurelia Tonu BurduniucÎncă nu există evaluări

- Hector Malot - Singur Pe LumeDocument230 paginiHector Malot - Singur Pe Lumerodica14488% (49)

- F de TitluDocument1 paginăF de TitluIon PereuÎncă nu există evaluări

- 3UA1Document1 pagină3UA1Ion PereuÎncă nu există evaluări

- Software EngineeringDocument198 paginiSoftware Engineeringmugurciup100% (1)

- Документ Microsoft Office WordDocument1 paginăДокумент Microsoft Office WordIon PereuÎncă nu există evaluări

- 8 MarinescuDocument12 pagini8 Marinescujulio7345Încă nu există evaluări