Documente Academic

Documente Profesional

Documente Cultură

Teza RaduC

Încărcat de

Don marioDrepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Teza RaduC

Încărcat de

Don marioDrepturi de autor:

Formate disponibile

Universitatea Lucian Blaga din Sibiu

Facultatea de Inginerie Hermann Oberth

Departamentul de Calculatoare i Inginerie

Electric

CONTRIBUII LA

PROIECTAREA SISTEMELOR DE

CLASIFICARE A

DOCUMENTELOR

Tez de doctorat

Autor:

Asist. univ. Radu George CREULESCU, MSc

Conductor tiinific:

Prof. univ. dr. ing. Lucian N. VINAN, m.c. ASTR

SIBIU, 2011

2

Cuprins

PARTEA I. INTRODUCERE ....................................................................................................................................... 5

1 INTRODUCERE. SCOP I OBIECTIVE PRINCIPALE ................................................................................ 5

1.1 SCOP I OBIECTIVE ............................................................................................................................ 6

1.2 STRUCTURA TEZEI DE DOCTORAT ...................................................................................................... 6

2 STADIUL ACTUAL N PROCESAREA AUTOMAT A DOCUMENTELOR DE TIP TEXT................. 9

2.1 DATA MINING N BAZE DE DATE ........................................................................................................ 9

2.1.1 Preprocesarea datelor ............................................................................................................ 9

2.1.2 Curirea datelor .................................................................................................................. 10

2.1.3 Transformarea i integrarea datelor .................................................................................... 11

2.2 TEXT MINING ................................................................................................................................... 13

2.2.1 Analiza datelor text i regsirea informaiei......................................................................... 14

2.2.2 Metode de regsire a informaiei .......................................................................................... 14

2.2.3 Asocierea ntre cuvinte cheie i clasificarea documentelor .................................................. 15

2.2.4 Alte tehnici de indexare pentru regsirea textului ................................................................ 16

2.3 WWW MINING ................................................................................................................................ 16

2.3.1 Mineritul structurii paginilor web ........................................................................................ 17

2.3.2 Mineritul link-urilor pentru identificarea paginilor web autoritare ..................................... 18

2.3.3 Mineritul utilizrii web ......................................................................................................... 19

2.3.4 Construirea informaiilor de baz pe mai multe niveluri web .............................................. 19

2.3.5 Clasificarea automat a documentelor web.......................................................................... 20

2.4 CLUSTERING VS. CLASIFICARE ........................................................................................................ 21

2.4.1 nvare nesupervizat i supervizat ................................................................................... 21

2.4.2 Clasificare i analiza clasificrii .......................................................................................... 22

2.4.3 Clustering i analiza clusterilor ............................................................................................ 24

2.4.4 Cerine cheie pentru algoritmii de clustering ....................................................................... 25

2.5 METRICI DE SIMILARITATE A DOCUMENTELOR TEXT ....................................................................... 25

2.5.1 Structurarea datelor utilizate n clustering ........................................................................... 25

2.5.2 Disimilaritate i similaritate: msuri ale calitii clusteringului.......................................... 26

2.5.3 Distane uzuale ..................................................................................................................... 26

2.5.4 Tipuri de variabile utilizate n clustering/clasificare ............................................................ 28

2.6 EVALUAREA ALGORITMILOR DE CLASIFICARE/ CLUSTERING ........................................................... 31

2.6.1 Msuri externe de validare a clusteringului i a clasificrii ................................................ 31

2.6.2 Msuri de validare intern a clusterilor ............................................................................... 32

2.7 SETURI DE DATE UTILIZATE ............................................................................................................. 33

2.7.1 Setul de date Reuters ............................................................................................................. 33

2.7.2 Setul de date RSS Web ........................................................................................................ 37

PARTEA A II-A. CLUSTERING ................................................................................................................................39

3 ALGORITMI DE CLUSTERING. PARADIGMA ACTUAL .....................................................................39

3.1 O POSIBIL TAXONOMIE .................................................................................................................. 39

3.1.1 Algoritmi partiionali (sau metode partiionale) ................................................................... 39

3.1.2 Metode ierarhice ................................................................................................................... 45

3.1.3 Metode bazate pe ordinea cuvintelor .................................................................................... 49

3.1.4 Metode bazate pe densiti .................................................................................................... 53

3.1.5 Metode de tip grid-based ...................................................................................................... 53

3.1.6 Metode bazate pe modele ...................................................................................................... 53

3.2 ALGORITMI IERARHICI. HAC IMPLEMENTAREA AGNES .............................................................. 54

3.3 ALGORITMI PARTIIONALI. K-MEDOIDS ......................................................................................... 57

3

4 CERCETRI PRIVIND REPREZENTAREA DOCUMENTELOR N ALGORITMI DE

CLUSTERING ................................................................................................................................................60

4.1 MODELE DE REPREZENTARE UTILIZATE........................................................................................... 60

4.1.1 Reprezentarea utiliznd modelul Vector Space Model - VSM .............................................. 60

4.1.2 Reprezentarea utiliznd modelul Suffix Tree Document Model - STDM .............................. 61

4.2 METODOLOGIA DE LUCRU ............................................................................................................... 62

4.3 METRICI PENTRU CALCULUL MATRICII DE SIMILARITATE I METODE DE EVALUARE UTILIZATE.

METRICA ORIGINAL PROPUS ............................................................................................................................... 63

4.4 REZULTATE OBINUTE PE SETURILE RSS ........................................................................................ 66

4.4.1 Rezultatele obinute de algoritmul HAC cu reprezentare VSM ............................................. 67

4.4.2 Rezultatele obinute de algoritmul HAC cu reprezentare STDM .......................................... 69

4.4.3 Rezultatele obinute de algoritmul k-Medoids cu reprezentare VSM .................................... 74

4.4.4 Rezultatele obinute de algoritmul k-Medoids cu reprezentare STDM ................................. 76

4.4.5 Comparaii ntre algoritmii de clustering i ntre modurile de reprezentare. Superioritatea

metricii propuse 80

PARTEA A III-A. CLASIFICARE .............................................................................................................................90

5 ALGORITMI DE CLASIFICARE. PARADIGMA ACTUAL ....................................................................90

5.1 GENERALITI ................................................................................................................................ 90

5.2 ALGORITMI STOHASTICI .................................................................................................................. 90

5.2.1 Clasificarea bayesian .......................................................................................................... 91

5.2.2 Antrenarea clasificatorului Bayes......................................................................................... 92

5.2.3 Testarea clasificatorului Bayes ............................................................................................. 93

5.2.4 Rezultate obinute cu clasificatorului Bayes ......................................................................... 94

5.3 ALGORITMI DE NVARE BAZAI PE BACKPROPAGATION .............................................................. 96

5.3.1 Modelul neuronului artificial ................................................................................................ 96

5.3.2 Arhitectura reelelor neuronale ............................................................................................ 98

5.3.3 nvarea reelelor neuronale ............................................................................................... 98

5.3.4 Reguli de nvare prin corecie a erorii (error-correction rules) ................................... 99

5.3.5 Regula de nvare Boltzmann ............................................................................................ 102

5.3.6 Regula de nvare Hebb..................................................................................................... 102

5.3.7 Regula de nvare competitiv ........................................................................................... 102

5.3.8 Algoritmul de nvare Backpropagation ............................................................................ 104

5.3.9 Cercetri privind evitarea saturrii ieirii neuronilor........................................................ 107

5.4 ALGORITMI EVOLUIONITI. ALGORITMI GENETICI ....................................................................... 107

5.4.1 Codificarea cromozomilor i problema de optimizare........................................................ 108

5.4.2 Metode de alegere a cromozomilor .................................................................................... 108

5.4.3 Operatorii genetici utilizai ................................................................................................. 110

5.5 ALGORITMI BAZAI PE NUCLEE. SUPPORT VECTOR MACHINE (SVM) ........................................... 110

5.6 CLASIFICATORI HIBRIZI. METACLASIFICATORI .............................................................................. 115

6 CERCETRI PRIVIND PROIECTAREA SISTEMELOR COMPLEXE DE CLASIFICARE ...............116

6.1 EVALUAREA CLASIFICATORILOR DE TIP SVM ............................................................................... 117

6.1.1 Problema limitrii metaclasificatorului cu clasificatori de tip SVM .................................. 118

6.1.2 O prim tatonare a problemei ............................................................................................ 120

6.2 SOLUII EXPLORATE PENTRU MBUNTIREA METACLASIFICATORULUI BAZAT PE CLASIFICATOARE

DE TIP SVM 121

6.2.1 Soluia introducerii unor noi clasificatori SVM .................................................................. 121

6.2.2 Soluia alegerii altei clase................................................................................................... 121

6.2.3 Soluia adugrii unui clasificator de alt tip ...................................................................... 122

6.3 METODE DE SELECIE A CLASIFICATORILOR ................................................................................. 126

6.3.1 Selecia bazat pe vot majoritar (MV). Rezultate ............................................................... 126

6.3.2 Selecia bazat pe distana euclidian (SBED). Rezultate .................................................. 127

6.3.3 Selecia bazat pe distana cosinus (SBCOS). Rezultate .................................................... 128

6.4 ARHITECTURI NEADAPTIVE PROPUSE I DEZVOLTATE ................................................................... 130

6.4.1 Metaclasificator cu ponderi predefinite. Evaluare de tip Eurovision. Rezultate obinute. . 130

6.4.2 Metaclasificator cu ponderi calculate. Design Space Exploration cu algoritmi genetici.

Rezultate obinute. ........................................................................................................................................... 134

6.5 ARHITECTURI ADAPTIVE PROPUSE I DEZVOLTATE ....................................................................... 137

6.5.1 Metaclasificatoare bazate pe similaritate ........................................................................... 137

6.5.2 Metaclasificator bazat pe algoritmul Backpropagation ..................................................... 140

4

PARTEA IV-A. CONCLUZII ....................................................................................................................................148

7 CONCLUZII ......................................................................................................................................................148

7.1 CONTRIBUII ORIGINALE ALE AUTORULUI ..................................................................................... 148

7.1.1 Contribuii originale n problema metaclasificatorilor ...................................................... 150

7.1.2 Contribuii originale n problema clusteringului ................................................................ 152

7.1 CONCLUZII SINTETICE I DEZVOLTRI ULTERIOARE ...................................................................... 152

8 GLOSAR DE TERMENI ..................................................................................................................................154

9 REFERINE BIBLIOGRAFICE ...................................................................................................................156

9.1 BIBLIOGRAFIE ............................................................................................................................... 156

9.2 WEBLIOGRAFIE ............................................................................................................................. 162

10 SINTEZA LUCRRILOR PUBLICATE/ELABORATE DE CTRE AUTOR PE PROBLEMATICA

TEZEI DE DOCTORAT ..............................................................................................................................163

Introducere. Scop i obiective principale

5

Partea I. Introducere

1 Introducere. Scop i obiective principale

Majoritatea informaiilor din lumea real se gsesc n format text. Aceste date sunt

considerate ca avnd un format semistructurat deoarece conin puine metainformaii despre

structura lor. Modelarea i implementarea de tehnici pentru lucrul cu date semistructurate s-au

dezvoltat continuu n ultimii ani. Mai mult dect att, aplicaiile de regsire a informaiilor ca i

metode de indexare a datelor din baze de date au fost adaptate astfel nct s funcioneze cu

aceste documente nestructurate.

Metodele generale de regsire a informaiei nu mai sunt utile pentru cutarea n colecii

mari de date nestructurate sau semistructurate. De obicei, n urma unei interogri utilizatorul

obine puine rezultate relevante conform cu interogarea formulat asupra documentelor

disponibile. Fr anumite cunotine iniiale referitoare la aceste colecii mari de date este dificil

pentru utilizator s formuleze interogri eficiente pentru extragerea de informaii interesante,

relevante i utile pentru utilizator. Pentru a putea compara diferite documente din punct de

vedere al gradului de relevan i utilitate precum i pentru gsirea de reguli pentru organizarea

lor devine tot mai imperioas proiectarea i utilizarea unor unelte specializate n acest sens.

Machine Learning-ul ofer dou abordri privind modalitile ca o main s nvee

documente text i anume, nvarea supervizat denumit n continuare clasificare i cea

nesupervizat denumit n continuare clustering.

n nvarea supervizat exist dou etape distincte: ntr-o prim faz se alege un set de

documente deja preclasificate acest set fiind utilizat apoi ca i set de antrenament. Pe baza

acestei mulimi de antrenament se va extrage o schem de clasificare. Aceast schem de

clasificare este evaluat i validat utiliznd o mulime de documente de test. n a doua etap

schema de clasificare obinut este utilizat apoi n clasificarea altor documente din setul de

testare. Setul de antrenare (mai mic) este diferit fa de setul de testare.

nvarea nesupervizat const n aplicarea unor anumii algoritmi de grupare pentru un

set de date dat direct, fr a se specifica criteriul de grupare i fr a utiliza o etap de antrenare

cum este cazul la nvarea supervizat. Apoi, ntr-o a doua etap, denumit i validarea

clusteringului se aplic diverse msuri (interne sau externe) pentru a putea analiza corectitudinea

clusterelor create.

n prezenta lucrare am plecat de la premisa utilizrii metodelor pur computaionale n

regsirea informaiilor din documente text. Cu toate c n unele cazuri am ncercat adugarea

unei anumite cantiti de informaie semantic n diverii algoritmi utilizai, abordarea din

punct de vedere semantic depete cadrul prezentei teze.

What a good thing Adam had. When he said a

good thing he knew nobody had said it before.

Mark Twain

The secret of getting ahead is getting started.

Agatha Christie

Introducere. Scop i obiective principale

6

1.1 Scop i obiective

Scopul general al acestei lucrri este acela de a contribui la mbuntirea performanelor

sistemelor de clasificare i clustering pentru documente text, prin metode avansate de nvare

nesupervizat i supervizat.

Pentru a ndeplini acest scop am avut n vedere urmtoarele aspecte:

- analizarea critic a stadiului actual al regsirii informaiilor din documente text n

funcie de metodele de nvare utilizate: nvare nesupervizat (clustering) i

respectiv nvare supervizat (clasificare);

- demonstrarea utilitii modelului de reprezentare a documentelor bazat pe arbori

de sufixe (STDM - Suffix Tree Document Model) n anumii algoritmi de

clustering;

- elaborarea i evaluarea unor noi metrici pentru determinarea similaritii ntre

documente reprezentate cu ajutorul modelului STDM n algoritmi de clustering;

- investigarea punctelor mai slabe ale unor metaclasificatori - dezvoltai ntr-o

anterioar tez de doctorat elaborat sub conducerea domnului profesor Lucian

Vinan de ctre domnul ing. Daniel Morariu (2007) - i determinarea unor soluii

pentru mbuntirea acurateei de clasificarea a acestora;

- mbuntirea acurateei de clasificare a documentelor text prin elaborarea unor

metaclasificatori hibrizi bazai pe algoritmi de clasificare de tip SVM i Bayes

respectiv pe algoritmi genetici i reele neuronale pe partea de selecie a

clasificatorului optimal (postclasificare).

1.2 Structura tezei de doctorat

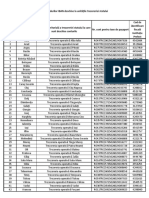

Direciile de cercetare abordate n prezenta tez sunt prezentate n Fig. 1.1. s-au

desfurat n mai multe etape, pe dou direcii mari de cercetare: clustering i clasificare de

documente text. n fiecare etap, informaiile primite, sunt procesate i apoi transmise mai

departe. Fiecare etap poate include unul sau mai muli algoritmi. Rezultatele fiecrui algoritm

utilizat sunt evaluate prin diferite msuri de validare.

Prezenta lucrare este structurat pe patru pri, cuprinznd apte capitole. n prima parte,

care conine capitolele unu i doi sunt prezentate noiuni introductive. Astfel, primul capitol

prezint scopul i obiectivele tezei, o schem de ansamblu a direciilor de cercetare propuse

respectiv structura tezei de doctorat.

n capitolul al doilea se prezint cteva consideraii generale privind procesarea automat

a documentelor de tip text. Sunt trecute n revist aspecte importante legate de pregtirea datelor

- preprocesare, curire, transformare i integrare - n mineritul datelor (data mining) n

general. Avnd n vedere scopul general al acestei lucrri sunt prezentate problemele specifice

ale mineritului textului (text mining) i ale mineritului WEB (WWW mining). De asemenea,

se prezint critic-comparativ aspecte generale legate de nvarea supervizat i cea

nesupervizat cu implicaii pentru analiza clasificrii i cea a clusteringului. Se prezint metricile

utilizate de ctre algoritmi pentru calcularea similaritii sau disimilaritii dintre documente.

Pentru evaluarea rezultatului algoritmilor de clasificare/clustering sunt prezentate i msurile de

evaluare. n finalul capitolului se prezint seturile de date Reuters utilizate pentru algoritmii de

clasificare precum i seturile de date RSS utilizate n algoritmii de clustering.

Partea a doua conine capitolele trei i patru i reprezint cercetarea autorului n domeniul

clusteringului. Astfel, capitolul trei conine o prezentare original a unei posibile taxonomii a

algoritmilor de clustering. Sunt prezentate diferite tipuri de algoritmi de clustering pentru fiecare

Introducere. Scop i obiective principale

7

categorie n parte, fiind analizai detaliat algoritmii cei mai reprezentativi. Algoritmii HAC

(Hierarchical Aglomerative Clustering) i K-Medoids sunt prezentai mai amnunit, cei doi fiind

alei pentru efectuarea experimentelor n clusteringul documentelor text.

n capitolul patru sunt prezentate cercetrile autorului n domeniul clusteringului.

Utilizarea modelului de reprezentare a documentelor ca arbori de sufixe (STDM) n algoritmi de

clustering este analizat i comparat cu modelul clasic vectorial (VSM) de reprezentare a

documentelor.

Fig. 1.1 Procesul de extragere a informaiei din documente text. Abordarea din tez

n acest capitol sunt prezentate metodologia de lucru aplicat la algoritmii de clustering

alei precum i rezultatele obinute de acetia. Se prezint metrici pentru calcularea similaritii

RSS feeds

REUTERS

Extragere cuvinte

Eliminare stop-words

Stemming

8 SVM Naive Bayes

Metaclasificatori

P

o

n

d

e

r

a

r

e

c

u

v

a

l

o

r

i

p

r

e

d

e

f

i

n

i

t

e

P

o

n

d

e

r

a

r

e

c

u

a

l

g

o

r

i

t

m

i

g

e

n

e

t

i

c

i

Ponderare

Backpropagation

Non-adaptivi

Adaptivi

VSM STDM

Matrice de distane

Modele de reprezentare

HAC

single link

K-Medoids

(PAM)

Evaluare

CLASIFICARE

CLUSTERING

A

l

e

g

e

r

e

a

a

l

t

e

i

c

l

a

s

e

Introducere. Scop i obiective principale

8

ntre dou documente reprezentate prin modelul STDM, una fiind original i cea care obine

rezultatele cele mai bune. n finalul capitolului sunt prezentate i analizate rezultatele obinute de

algoritmii de clustering utiliznd diferite metrici i cele dou modele de reprezentare a

documentelor STDM i VSM.

n partea a treia, care conine capitolele cinci i ase se prezint cercetarea efectuat n

domeniul clasificrii documentelor text. n capitolul cinci se face o prezentare a unei posibile

taxonomii pentru algoritmii de clasificare. Sunt prezentai algoritmi de clasificare caracteristici

pentru fiecare categorie i unele rezultate din faza de testare a acestora. De asemenea, la finalul

capitolului cinci sunt prezentate noiuni eseniale legate de metaclasificatoare.

n capitolul ase se prezint cercetri privind proiectarea metaclasificatoarelor. Sunt

propuse unele soluii de mbuntire a unor metaclasificatori existeni i se prezint 3

metaclasificatori originali. Utilizarea unor algoritmi genetici i a unei reele neuronale au dus la

mbuntirea rezultatelor clasificrii documentelor text care sunt prezentate n cadrul acestui

capitol.

Prezenta tez se ncheie cu capitolul apte care este dedicat prezentrii ideilor principale

care se desprind din aspectele teoretice i practice ale cercetrilor efectuate i care sintetizeaz

contribuiile personale aduse n aceast lucrare precum i perspectivele de cercetare.

Mulumiri

n primul rnd cele mai sincere mulumiri doresc s le adresez conductorului meu de

doctorat dl. prof. univ. dr. ing. Lucian N. VINAN, pentru coordonarea tiinific riguroas,

pentru ncrederea acordat i pentru discuiile profesionale extrem de stimulative i interesante

pe care le-am avut precum, pentru exigena manifestat fa de lucrare.

De asemenea, doresc s mulumesc i pe aceast cale colegilor din Catedra de

Calculatoare i Automatizri din cadrul Universitii Lucian Blaga din Sibiu, n special

domnului l. dr. ing. Daniel Morariu, pentru faptul c a acceptat s-i continui munca i pentru

atmosfera plcut creat, care a contribuit i ea semnificativ la motivarea mea.

Doresc s mulumesc referenilor acestei teze de doctorat, pentru acceptul i bunvoina

de a recenza aceast lucrare i pentru efortul competent depus.

Totodat mulumirile mele se ndreapt spre familia i prietenii mei pentru susinerea

moral i pentru faptul c nu au renunat s cread n mine, cu toate c timpul care l-am alocat

lor a fost redus considerabil.

Este interesant faptul c, aceast lucrare a nceput o dat cu cstoria mea, a asistat la

naterea fiicei mele Ana, a nsoit-o n prima zi de grdini cnd nu vorbea, a fost alturi cnd

Ana a nceput s vorbeasc limba german, s schieze i s noate. Sper c prima zi de coal a

Anei va reprezenta actul final pentru aceast tez i totodat ieirea mea ca cercettor din

rndurile grdiniei i intrarea n coal.

Stadiul actual n procesarea automat a documentelor de tip text

9

2 Stadiul actual n procesarea automat a documentelor

de tip text

2.1 Data mining n baze de date

Data mining [Han01] reprezint extragerea cunotinelor din masive de date. Este o

prescurtare pentru mineritul cunotinelor din date (knowledge mining from data). Data mining

este un simplu pas n procesul complex de descoperire a cunotinelor din baze de date. Acest

pas este folosit n special pentru a analiza datele coninute n baze de date. Aceast analiz are ca

rezultat descoperirea caracteristicilor ce pot fi folosite ulterior la organizarea datelor. Astfel, data

mining poate fi privit ca procesul de descoperire a pattern-urilor i a legturilor (corelaiilor)

dintre date (tehnici de acest fel sunt prezentate n [Ian00]). Acest proces trebuie s fie automat

sau semi-automat. Deci, data mining este procesul de descoperire a cunotinelor relevante n

cantiti mari de date organizate n baze de date, depozite de date sau alte magazii de informaii

(data warehouse). Un sistem de data mining trebuie s aib urmtoarele componente majore

[Han01]:

1. Baze de date, depozite de date sau orice alt depozit de informaii cuprinde curirea

datelor (eliminarea zgomotului i corectarea inconsistenelor din date) i tehnicile de

integrare (agregare) efectuate pe date.

2. Baze de date sau servere pentru depozitarea datelor sunt responsabile pentru aducerea

datelor relevante bazate pe cererea utilizatorului.

3. Cunotinele de baz pentru ghidarea cutrii sau evaluarea pattern-urilor rezultate.

4. Motorul data mining este esenial pentru sistemul de data mining i ideal ar trebui s

cuprind module funcionale pentru sarcini cum ar fi, asocierile, clasificrile, analiza

clusterelor i analiza evoluiei i derivrii.

5. Module de evaluare a pattern-urilor sunt folosite pentru a interaciona cu modulul de

data mining pentru a realiza o cutare a pattern-urilor relevante.

6. Interfaa grafic a utilizatorului comunicarea ntre utilizator i sistemul de data mining

pentru specificarea interogrilor de data mining i afiarea informaiilor obinute.

Aadar, data mining este considerat a fi unul dintre cele mai importante domenii n

sistemul de baze de date i unul n care se prevd dezvoltri interesante i promitoare n

industria informatic.

2.1.1 Preprocesarea datelor

Bazele de date din lumea real sunt astzi foarte sensibile la zgomot, la lipsuri i

inconsisten a datelor. Pentru a putea obine rezultate folositoare din date se folosesc

urmtoarele tehnici de preprocesare:

- Curirea datelor pentru eliminarea zgomotului i corectarea inconsistenelor din date;

Information is not knowledge.

Albert Einstein

Stadiul actual n procesarea automat a documentelor de tip text

10

- Agregarea datelor contopirea datelor din surse multiple ntr-o form corespunztore

mineritului. Combin datele din mai multe surse ntr-un depozit de date coerent: depozit

de date sau cub de date;

- Selectarea datelor pentru a selecta informaiile relevante pentru procesul curent de

analiz cu scopul simplificrii muncii n etapa propriu-zis de extragere de cunotine;

- Transformarea datelor pregtirea datelor pentru analiz printr-o reprezentare ct mai

adecvat. Const n operaii cum ar fi normalizarea datelor. Normalizarea poate

mbunti acuratea i eficiena algoritmilor de data mining. Normalizarea datelor

reprezint scalarea tuturor datelor la un domeniu prestabilit;

- Reducerea datelor poate reduce dimensiunea datelor prin agregare, eliminarea

trsturilor caracteristice redundante sau gruparea trsturilor comune.

Aceste tehnici sunt aplicate apriori procesului de data mining i pot mbunti calitatea

procesului pentru gsirea abloanelor i/sau reducerea timpului necesar pentru mineritul efectiv.

2.1.2 Curirea datelor

Deoarece datele pentru procesul de data mining sunt preluate din diverse surse, acestea au

deseori diverse structuri i valori eronate sau lips. Algoritmii de curire a datelor ncearc s

umple valorile lips, s netezeasc valorile considerate zgomot prin identificarea extremelor i

s corecteze inconsistenele n date.

2.1.2.1 Valorile lips

Atunci cnd se aduc toate datele n aceeai structur pot aprea valori lips n valorile

corespunztoare unui document. Pentru a umple valorile lips exist cteva metode clasice:

- Ignorarea tuplelor (valorile atributelor corespunztoare unui document) de obicei este

fcut cnd clasa de etichete sau o mare parte din atributele tuplului lipsesc. Aceast

metod nu este eficient mai ales n cazul n care tuplele conin cteva atribute cu valori

lips. Este n special slab cnd procentajul valorilor lips per atribute variaz

considerabil;

- Umplerea valorilor lips manual n general aceast cale este consumatoare de timp i

nu este fezabil la multe valori lips;

- Utilizarea unei constante globale pentru umplerea valorilor lips nlocuiete toate

atributele lips cu aceeai constant (ex. Unknown sau

)

. Aceast metod este

simpl dar nu este recomandat deoarece poate duce la valori eronate ale tuplului;

- Utilizarea unui atribut de mijloc pentru nlocuirea valorilor lips de exemplu se umple

cu media tuturor valorilor din cmpul respectiv;

- Utilizarea unui atribut de mijloc pentru toate eantioanele aparinnd aceleiai clase din

care provine tuplul Aceasta se aplic n cazul n care avem la dispoziie i un set mic de

date preetichetate. Se vor nlocui valorile lips n setul de datete neetichetat cu media

valorilor pe tuplul respectiv pentru toate documentele aparinnd aceleiai clase din setul

de date etichetat;

- Utilizarea valorii cele mai probabile pentru nlocuirea valorilor lips determinarea

prin regresie a valorilor, are ca rezultat componente bazate pe concluzii utiliznd teoria

Bayesian sau bazat pe arbori de decizie.

Ultima metod este cea mai des folosit pentru c utilizeaz datele prezente pentru a

prezice valorile lips.

Stadiul actual n procesarea automat a documentelor de tip text

11

2.1.2.2 Zgomotul

Zgomotul este o eroare aleatoare sau variabil n valorile msurate. Acesta poate duce la

erori n evaluarea pattern-urilor. Cteva tehnici de netezire a datelor (eliminare a zgomotului)

sunt:

1. Filtrarea reprezint netezirea valorilor sortate prin consultarea vecintii. Valorile

sortate sunt distribuite ntr-un numr de grupuri sau bin (container). Deoarece metoda

consult valoarea vecinului, ea va face o netezire local. Exist mai multe metode de

netezirea a datelor:

- Netezire prin filtru median fiecare element din container este nlocuit cu media

elementelor din acel grup.

- Netezirea prin median fiecare element este nlocuit cu mediana elementelor

din container.

- Netezirea prin margini minimul i maximul sunt date de container i reprezint

graniele, fiecare element este nlocuit de valoarea graniei celei mai apropiate.

2. Clusterarea extremitile pot fi gsite prin grupare, unde valorile similare sunt

organizate ntr-un grup sau cluster. Valorile care rmn afar dup grupare sunt

considerate zgomot i sunt eliminate.

3. Combinarea inspeciei umane cu cea a calculatorului aplicaia este utilizat pentru

identificarea pattern-urilor extreme care reflect un coninut surpriz i respect o

etichet cunoscut. Pattern-urile gsite pot fi bune sau pot fi gunoi. Omul poate sorta

aceste pattern-uri pentru a identifica care dintre acestea reprezint gunoi.

4. Revenirea la starea anterioar datele pot fi netezite prin ajustarea datelor. Regresia

liniar implic gsirea celei mai bune linii pentru a uni dou variabile astfel nct

variabilele cunoscute pot fi utilizate s predicioneze altele. Regresia multipl liniar este

o extensie a regresiei liniare unde mai mult de dou variabile sunt implicate i datele sunt

unite pe o suprafa multidimensional. Se utilizeaz regresia pentru a gsi ecuaia

matematic care ajut la netezirea datelor i elimin zgomotul.

2.1.3 Transformarea i integrarea datelor

Data mining ofer posibilitatea de integrare a datelor concatenarea datelor din surse

multiple de date. Aceste date trebuie transformate ntr-o form convenabil pentru cutare.

2.1.3.1 Integrarea datelor

Este inevitabil ca n etapa de analiz a datelor, s se apeleze i la integrarea datelor din

surse multiple ntr-o surs de date coerent aceasta reprezint depozitarea datelor. Exist un

numr de probleme de luat n considerare pe durata integrrii datelor:

- Identificarea entitilor cum pot ti c customer_id dintr-o baz de date i cust_number

din cealalt fac referire la aceleai entiti. Bazele de date i depozitele de date conin de

obicei metadate. Fiecare metadat poate fi folosit pentru a evita erori n schema de

integrare.

- Redundana un atribut poate fi redundant dac el este derivat dintr-o alt tabel.

Inconsistena n atribute sau dimensiune pot de altfel cauza redundan n setul de date.

Redundana poate fi eliminat prin analiza corelaiilor. Analiza msoar ct de puternic

un atribut implic pe cellalt, bazndu-se pe datele disponibile. Corelaia dintre atributele

A i B poate fi msurat prin [Han01]:

Stadiul actual n procesarea automat a documentelor de tip text

12

B A

B A

n

B B A A

r

o o ) 1 (

) )( (

,

(2.1)

unde n reprezint numrul de tuple, A i B sunt media valorilor A i B iar

A

o i

B

o

reprezint deviaia standard:

1

) (

,

1

) (

: , ,

2 2

= = =

n

B B

n

A A

iar

n

B

B

n

A

A

B A

o o (2.2)

Dac rezultatul relaiei (2.1) este mai mare dect zero atunci A i B sunt posibil corelate,

n sensul c dac valoarea lui A crete va crete i valoarea lui B. De aici, o valoare mare va

indica c A sau B pot fi terse deoarece sunt redundante. Dac rezultatul este zero A i B sunt

independente i nu exist corelaie ntre ele. Dac valoarea rezultat este mai mic ca 0, atunci

A i B au o corelaie negativ (anticorelaie) unde dac valoarea unui atribut crete valoarea

celuilalt atribut va descrete.

- Detecia i rezoluia valorii datelor de conflict valorile pot diferi din cauza scrii de

reprezentare sau codrii. De exemplu nlimea poate fi memorat n diferite uniti de

msura. Preul pentru diferite hoteluri poate implica nu doar diferene de pre ci i

diferene de servicii.

Integrarea cu grij a datelor din surse multiple poate ajuta la reducerea i evitarea

redundanelor i inconsistenelor n setul de date rezultat i poate duce la o mbuntire a

procesului de extragere de cunotine.

2.1.3.2 Transformarea datelor

Transformarea datelor const n reprezentarea sau consolidarea datelor ntr-o form

convenabil pentru mineritul datelor. Ea implic urmtoarele:

- Netezirea se folosete pentru eliminare zgomotului din date. Asemenea tehnici includ

filtrare, clusterare i regresie;

- Agregarea operaii de sumarizare sau agregare sunt aplicate pe date. De exemplu

vnzrile zilnice pot fi agregate ca i calcule lunare sau anuale;

- Generalizarea unde primitivele de date de nivel jos sunt nlocuite cu primitive de nivel

nalt. De exemplu atributul strad poate fi generalizat cu ora sau ar. La fel vrsta

poate fi generalizat n tnr, mediu i btrn;

- Normalizarea se aplic o scalare ntr-un anumit domeniu pentru atribute. De exemplu

datele sunt scalate n intervalul [-1.0, 1.0] sau n intervalul [0.0, 1.0].

- Construirea atributelor (construirea articolelor) unde noi atribute sunt create i

adugate n setul de atribute dat pentru procesul de mining.

n continuare, nu voi detalia tehnicile de netezire, agregare i generalizare, ci m voi axa

pe normalizare pentru c a fost utilizat cu precdere n experimentele prezentate n aceast tez.

Normalizarea reprezint scalarea unei valori a atributului ntr-un domeniu specificat i

se realizeaz printr-o funcie matematic. Dintre metodele de normalizare mai des utilizate, se

menioneaz urmtoarele:

- Normalizarea min-max: transformare liniar de la datele originale. Presupunem min

A

i

max

A

sunt valorile minime i maxime a atributului. Normalizarea valorii v a lui A n v'

n noul domeniu [new_min

A

, new_max

A

] se face dup formula:

`

A

A A A

A A

v min

v (new_max -new_min )+new_min

max -min

= . (2.3)

Normalizarea min-max pstreaz relaiile dintre valorile datelor originale.

Stadiul actual n procesarea automat a documentelor de tip text

13

- Normalizarea z-mediu valoarea A este normalizat n baza unei medii i deviaii

standard a lui A: `

A

v A

v

o

= , unde este valoarea lui A, este valoarea calculat, A este

media iar

A

o este deviaia standard. Aceast metod de normalizare este utilizat cnd

minimul i maximul sunt necunoscute sau A iese din domeniul min-max.

- Normalizare prin scalare decimal normalizare prin mutarea punctului decimal, punct

care se mut innd cont de valoarea maxim absolut a lui A:

10

j

v

v' = unde j este un

ntreg dat de ( ) max 1 v' < . De exemplu pentru A n domeniul [986; 917], j ia valoarea 3.

Normalizarea schimb datele originale n totalitate, n special ultimele dou metode.

Este necesar s se salveze parametrii de normalizare pentru ca noile date s se normalizeze n

aceiai msur.

Construirea atributelor noile atribute sunt construite i adugate plecnd de la atributele deja

existente pentru a ajuta la o mai bun reprezentare a setului de date. De exemplu din atributele

lungime i lime s-ar putea construi atributul arie.

2.2 Text mining

Cele mai multe colecii de date din lumea real sunt n format text i constau din colecii

mari de documente din diferite surse, cum ar fi articole de tiri, lucrri de cercetare, cri,

biblioteci digitale, mesaje e-mail, pagini web i fluxuri RSS etc. Aceste tipuri de date sunt

semistructurate i nu au o structur complet determinist. Au fost dezvoltate tehnici de regsire a

informaiilor, cum ar fi metodele de indexare a textului, care au fost dezvoltate pentru a manevra

documente nestructurate.

Exist mai multe abordri n text mining, care pot fi clasificate din perspective diferite,

unele bazate pe intrri din cadrul sistemului de text mining i unele bazate pe sarcinile care

urmeaz s fie efectuate de sistemul de minerit. n general, abordrile majore, sunt [Han01]: (1)

abordarea bazate pe cuvinte cheie, n cazul n care ca i intrare este un set de cuvinte cheie sau

termeni din documente, (2) abordarea bazat pe etichetare, n cazul n care datele de intrare sunt

reprezentate printr-un set de etichete i (3) abordri bazate pe extragerea de informaii, abordare

care are ca intrare informaii semantice, cum ar fi evenimente, fapte, sau alte entitii descoperite

prin extragerea de informaii. O simpl abordare bazat pe cuvinte cheie ar putea s descopere

doar relaii la un nivel relativ superficial, cum ar fi redescoperirea expresiilor simple (de

exemplu, "baza de date" i "sisteme") sau apariii mpreun n pattern-uri cu semnificaie puin

important (de exemplu, "pescar" i "pete"), dar care nu pot duce la o nelegere profunda a

textului. Metoda etichetrii documentelor se bazeaz pe denumiri de clase, obinute prin

etichetare manual (care este costisitoare i este imposibil de realizat pentru colecii mari de

documente) sau de ctre unii algoritmi de clasificare automat (care pot prelucra un set relativ

mic de clase dar au nevoie n prealabil de definirea etichetelor). Cea de a treia abordare i anume,

extragerea de informaii este mult mai avansat i poate duce la descoperirea unor cunotine

profunde, dar ea necesit o analiz semantic a textului prin nelegerea limbajului natural

utiliznd att metode de nvare automat ct i lingvistica computaional.

Cele trei abordri prezentate sunt rezolvate prin diferite metode. Acestea includ

clusteringul documentelor, clasificarea, extragerea de informaii i analiza asocierilor. n

prezenta lucrare voi prezenta cteva aspecte i cercetri proprii privind clusteringul i

clasificarea de documente text.

Stadiul actual n procesarea automat a documentelor de tip text

14

2.2.1 Analiza datelor text i regsirea informaiei

Un domeniu care a fost dezvoltat o dat cu sistemele de baze de date este regsirea

informaiei (Information Retrieval - IR). Fa de un sistem de baze de date care se axeaz pe

interogri i procesarea tranzaciilor n date structurate, regsirea informaiei este concentrat pe

organizarea i recunoaterea de informaii din documente text. Pentru sistemele de regsire a

informaiei, o problem important o reprezint alegerea documentelor relevante pentru

utilizator.

Deoarece sistemele de regsire a informaiilor i sistemele de baze de date utilizeaz

fiecare diferite tipuri de date, problemele care apar la aceste dou tipuri de sisteme sunt diferite.

Problemele majore ale regsirii informaiei din documente text sunt legate de aproximarea

cutrii bazndu-ne pe cuvinte cheie i pe noiunea de relevan.

2.2.1.1 Msuri de baz pentru regsirea informaiei

S presupunem c un sistem de regsire a informaiei a returnat un numr de documente

pe baza unei interogri formulate. Problema care apare este cum se poate aprecia dac setul de

documente regsit pe baza interogrii este satisfctor.

Prezentm n continuare dou notaii importante pentru sistemele de regsire a informaiei

[Han01]. Fie { } Relevant mulimea tuturor documentele relevante fa de interogare i { } Regasit

mulimea tuturor documentelor gsite n urma interogrii. Setul de documente care le include pe

ambele este notat { } { } Relevant Regasit . Exist 3 msuri de baz pentru aprecierea calitii

textului regsit:

Precizie reprezint probabilitatea ca un document clasificat corect s fie util:

{ } { }

{ }

Relevant Regasit

precision

Regasit

= (2.4)

Recall reprezint probabilitatea ca un document util s fie clasificat corect

{ } { }

{ }

Relevant Regasit

Relevant

recall

= (2.5)

F-measure care este definit ca medie armonic ntre Precizie i Recall

( ) / 2

recall precision

F measure

recall precision

=

+

(2.6)

Este tiut faptul c media armonic penalizeaz mai bine dect alte msuri (ex. media

aritmetica) un sistem care sacrific (supraliciteaz) o msur n favoarea celeilalte.

2.2.2 Metode de regsire a informaiei

n general, metodele de regsire se mpart n dou categorii: metode care vd regsirea de

informaie ca o problem de selecie a unor documente i metode care ofer o ierarhie de

documente. Aceast ierarhie se bazeaz pe un scor obinut de fiecare document n funcie de ct

de similare sunt acestea fa de interogarea formulat.

n metodele de selecie a documentelor, interogarea stabilete anumite limite pentru

selectarea documentelor relevante. O metod tipic din aceast categorie este modelul Boolean

de regsire a informaiei n care un document este reprezentat ca un set de cuvinte cheie i ofer

unui utilizator o expresie boolean de cuvinte cheie, cum ar fi "bed AND breakfast", "tea OR

coffee", sau "browser web NOT Internet Explorer". Un astfel de sistem de regsire a informaiei

Stadiul actual n procesarea automat a documentelor de tip text

15

va executa o astfel de interogare i va returna doar documentele care satisfac expresia boolean.

Totui, metoda de regsire boolean, n general, funcioneaz bine doar atunci cnd utilizatorul

cunoate setul de date din care vrea s selecteze informaii i poate formula o interogare

boolean corect n acest sens.

Metodele care ofer o ierarhie a documentelor, ordoneaz documentele n funcie de

relevana acestora n raport cu o interogare formulat. Pentru utilizatorii obinuii, aceste metode

sunt mai adecvate dect metodele de selecie a documentelor. Cele mai multe sisteme moderne

de regsire a informaiilor ofer o list de documente ierarhizate, ca rspuns la interogarea bazat

pe cuvinte sau expresii cheie a unui utilizator. Scopul acestei metode este de a aproxima gradul

de relevan a unui document cu interogarea formulat, cu ajutorul unui scor calculat pe baza

informaiilor, cum ar fi frecvena de cuvinte din document i cuvintele din ntregul set. Este

evident faptul c este dificil s gsim o msur precis a gradului de relevan pentru un set de

cuvinte cheie.

Cea mai des utilizat abordare pentru reprezentarea documentului este utilizarea

modelului spaiului vectorial (Vector Space Model - VSM). Ideea de baz a modelului VSM este

urmtoarea: reprezentm un document i o interogare, ca vectori ntr-un spaiu n-dimensional

corespunztor pentru toate cuvintele cheie i vom folosi o msur de similaritate specific pentru

a calcula similaritatea dintre vectorul de interogare i vectorul documentului. Valorile

similaritii pot fi apoi utilizate pentru ierarhizarea documentelor. Pornind de la un set D de

documente i t termeni (cuvinte), putem modela fiecare document ca fiind un vector v ntr-un

spaiu n dimensional ortogonal R

n

. Coordonata j a lui v este un numr (frecven de termeni

care se poate i pondera) care msoar importana termenului j pentru documentul dat: este de

obicei 0 dac documentul nu conine termenul i diferit de zero n rest. Presupunnd acum c la

documente similare se ateapt s aib o frecven similar a termenilor putem msura

similaritatea prin compararea frecvenelor cuvintelor de baz. De exemplu folosind formula

cosinusului dintre doi vectori n-dimensionali:

1 2

1 2

1 2

( , )

v v

sim v v

v v

= (2.7)

unde

1 2

v v reprezint produsul scalar a doi vectori i se calculeaz ca fiind

1 2

1

n

i i

i

v v

=

(cosinusul

ntre versorii ortogonali este evident 0) iar

1

v este norma (modulul, msura) vectorului i se

calculeaz ca fiind

1 1 1

v v v = . Evident ca sim (v1,v2)=1 semnific o similaritate maxim ntre

cei doi vectori.

2.2.3 Asocierea ntre cuvinte cheie i clasificarea documentelor

O astfel de analiz colecteaz seturi de cuvinte cheie sau termeni care apar frecvent

mpreun i apoi stabilete relaii de asociere sau de coresponden ntre ele. Metoda analizei

asocierilor n baze de date text efectueaz cteva operaii de preprocesare a datelor, prin

extragerea rdcinii cuvintelor i prin eliminarea cuvintelor de legtur din text obinnd astfel

un set redus, apoi apeleaz algoritmi specifici mineritului pe baz de asocieri. ntr-o baz de

date cuprinznd documente, fiecare document poate fi privit ca o tranzacie, n timp ce un set de

cuvinte cheie din document poate fi considerat ca un set de elemente din acea tranzacie. Baza de

date este n formatul:

{id_document, lista_cuvinte_cheie} (2.8)

Problema mineritului asocierii cuvintelor cheie din documente este, n consecin,

mineritul asocierii nregistrrilor din bazele de date tranzacionale, unde au fost dezvoltate mai

multe metode [Agra93], [Hols94]. Setul de cuvinte cheie care n mod consecutiv apar frecvent

Stadiul actual n procesarea automat a documentelor de tip text

16

pot forma un termen sau o fraz. Procesul de minerit al asocierilor poate ajuta la detectarea

componentelor asocierii, adic termeni sau fraze dependente de domeniu (ex. Stanford,

University), sau asocierilor necombinate (RON, curs valutar). Mineritul bazat pe aceste asocieri

este numit mineritul asocierilor de termeni care este diferit fa de mineritul cuvintelor simple.

Mineritul asocierilor la nivelului termenului se bucur de dou avantaje n analiza textului: (1)

termenii i frazele sunt automat etichetate eliminndu-se factorul uman i (2) numrul de

rezultate fr sens este substanial redus n timpul execuiei algoritmului de minerit.

2.2.4 Alte tehnici de indexare pentru regsirea textului

Alte tehnici de regsire pe care le-am analizat se refer la index invers i fiiere de

semnturi.

Un index invers este o structur de dou tabele numite document_table i term_table

indexate cu tabele HASH sau cu ajutorul unui arbore B+:

- document_table const dintr-un set de nregistrri, fiecare coninnd dou cmpuri:

doc_id i posting_list, unde posting_list este o list de termeni care apar n document,

sortat n raport cu metrica utilizat;

- term_table const dintr-un set de termeni nregistrai, fiecare coninnd: term_id i

posting_list, unde posting_list specific o list de identificatori de documente n care apar

termenii.

Fiierele de semntur sunt fiiere care memoreaz semnturi ale nregistrrilor pentru

fiecare document din baza de date. Fiecare semntur are o dimensiune fix de b bii care

reprezint termenii. Fiecare bit al documentului de semnturi este setat la 0 la nceput. Un bit

este trecut pe 1 dac termenul reprezentat prin semntur apare n document. O semntur S1 se

potrivete cu o alt semntur S2 dac fiecare bit care este setat n S1 este setat i n S2.

2.3 WWW mining

WWW (World Wide Web)este un sistem hipermedia distribuit, oferind o gam larg de

informaii i servicii. Informaiile coninute n paginile WEB precum i legturile (linkurile) ntre

ele ofer surse importante pentru data mining. n continuare prezint unele probleme cheie care

vizeaz utilizarea WWW ca surs pentru data mining.

Web-ul pare a fi prea vast pentru realizarea unui data warehousing sau data mining

eficient. Dimensiunea actual a WEB-ului este de ordinul sutelor sau miilor de terabytes

i este n continu cretere rapid. La sfritul lunii iunie 2011 compania Netcraft

[NETK] o companie care monitorizeaz severe de web a raportat rspunsuri de la un

numr de 346.004.403 de site-uri.

Complexitatea paginilor WEB este de departe mai mare dect orice alt colecie de

documente text tradiionale. n paginile web lipsete standardizarea. n ultimii 2-3 ani de

cnd ideea de web semantic prinde tot mai mult contur se ncearc introducerea unor

standarde la nivel de limbaj i structur a paginii. n momentul actual, paginile de web

conin structuri i stiluri diferite. Chiar dac WEB-ul este considerat a fi o mare

bibliotec digital, majoritatea documentelor din aceast bibliotec nu sunt ordonate. Nu

exist indexare dup categorii, titlu sau autor. Cutarea i regsirea de informaii ntr-o

asemenea bibliotec este o sarcin important i dificil.

Web-ul este o surs de informaii foarte dinamic. Web-ul crete continuu i informaiile

coninute sunt constant actualizate. tirile, bursa de valori, reclame i reclame pentru

servicii web modific paginile web zilnic.

Stadiul actual n procesarea automat a documentelor de tip text

17

Web-ul deservete o diversitate de utilizatori. Comunitatea utilizatorilor care folosesc

internetul este ntr-o continu cretere. Utilizatorii pot avea cunotine diferite, interese i

scopuri de utilizare diferite. Majoritatea utilizatorilor nu au cunotine legate de structura

reelei Internet, se poate s nu fie contieni de costul ridicat a unei cutri, se pot uor

pierde n ntunecimea reelei sau se pot uor plictisi n ateptarea unui rezultat.

Doar o mic parte din informaiile de pe Web sunt ntr-adevr relevante sau valoroase

pentru un utilizator la un moment dat. Se pare c aproape 99% din informaiile obinute

de un utilizator sunt neinteresante sau neimportante pentru el. Cum pot fi determinate

poriunile din web care sunt ntr-adevr relevante? Cum putem gsi o pagin web de

nalt calitate cu un topic specific? Iat doar cteva ntrebri care mai ateapt un

rspuns.

Exist multe motoare de cutare bazate pe indeci care caut n web, indexeaz pagini i

construiesc i memoreaz indeci imeni bazai pe cuvinte cheie, care ajut la localizarea

seturilor de pagini care conin acele cuvintele cheie. Un utilizator experimentat poate s

localizeze rapid un document prin furnizarea unui set de constrngeri de cuvinte cheie i fraze.

Oricum, cutarea bazat pe cuvintele cheie are dou probleme majore: (1) fiecare topic conine

sute sau mii de documente. Aceasta face ca motorul de cutare s returneze numeroase pagini,

multe dintre ele fiind doar parial relevante pentru interogarea formulat sau conin informaii de

o calitate slab. (2) multe documente care ar fi relevante pentru o interogare pot s nu conin

cuvinte cheie definite n interogare. Aceasta este problema polisemiei. De exemplu cuvntul

leu poate nsemna un animal slbatic care triete n Africa sau o unitate monetar.

Mineritul pe web reprezint o sarcin mult mai provocatoare, nseamn ordonarea

coninutului, identificarea de structuri n Web, identificarea de regulariti i coninuturi

dinamice, mineritul pattern-urilor de acces la Web. n general, sarcina de minerit pe web poate fi

clasificat n 3 categorii: mineritul coninutului web, mineritul structurii web i mineritul

utilizrii web.

2.3.1 Mineritul structurii paginilor web

Comparativ cu textul simplu dintr-un document, o pagin web conine pe lng text i

imagini i o structur. Din acest motiv paginile web sunt considerate a fi date semistructurate.

Structura de baz a unei pagini web este data de DOM (Document Object Model). DOM este o

interfa independent de platform i limbaj, care permite programelor i script-urilor s

acceseze dinamic i s actualizeze coninutul, structura i stilul documentului web [W3C].

Structura DOM a unei pagini web este o structur arborescent, n care fiecare tag

(etichet) HTML n pagina corespunde unui nod n arborele DOM. Pagina web poate fi

delimitat (marcat) de taguri predefinite structural. Tag-uri utile includ <p> (paragraf), <table>

(tabel), <li> (element de lista), <h1>... <h6> (titlu-heading) etc.

Stadiul actual n procesarea automat a documentelor de tip text

18

Fig. 2.1 Structura i taguri coninute ntr-o pagin web

Astfel, structura DOM poate fi folosit pentru a facilita extragerea de informaii. Din

pcate, datorit flexibilitii de sintax HTML, multe pagini web nu respect specificaiile W3C

privind structura HTML. Cel mai nociv standard utilizat n web a fost standardul HTML 3.2

care a permis amestecarea formei cu cea a coninutului fapt ce a dus la ngreunarea indexrii

paginilor web. n prezent, standardul XHTML1 i mai noul HTML5 ncearc o separare clar a

coninutului de forma de afiare prin utilizarea unor stiluri declarate n antetele paginilor sau n

fiiere separate cu ajutorul sintaxei CSS (Cascade Style Sheets). Mai mult dect att, arborele

DOM a fost iniial introdus pentru afiarea documentului n browser i nu ca i o descriere a

structurii semantice a paginii Web. De exemplu, chiar dac dou noduri n arbore DOM au

acelai printe, cele dou noduri ar putea fi semantic mai legate de alte noduri.

2.3.2 Mineritul link-urilor pentru identificarea paginilor web autoritare

Presupunem c un utilizator execut o interogare pentru a obine pagini relative la un

subiect dat, cum ar fi curs valutar. Paginile relevante i de nalt calitate din punct de vedere al

subiectului sunt considerate a fi pagini autoritare. Problema pentru motoarele de cutare este s

gseasc o modalitate pentru a identifica automat paginile web autoritare pentru un subiect dat.

Interesant este faptul c secretul autoritii este ascuns n legtura (link-ul) paginii. Web-ul

conine nu numai pagini dar i hiperlink-uri care pointeaz de la o pagin la alta. Aceste

hiperlink-uri conin o cantitate enorm de notaii umane latente care pot ajuta la regsirea

automat a noiunii de autoritate. Cnd un autor al unei pagini creeaz un hiperlink ctre o alt

pagin, aceasta nseamn c autorul acord ncredere paginii spre care a fcut linkul. Colecia de

linkuri venite pentru o pagin dat de la autori diferii de pe web poate indica importana paginii

i se poate s conduc natural la descoperirea paginilor web autoritare. Aadar,

(meta)informaiile web de legtur furnizeaz informaii bogate despre relevan, calitate i

structura coninutului web-ului i astfel este o surs bogat pentru mineritul web-ului.

Structura legturilor web are nite caracteristici unice. n primul rnd, nu fiecare hiperlink

reprezint o avizare pentru o pagin, unele linkuri sunt create pentru alte scopuri cum ar fi

navigarea sau reclame. Totui dac majoritatea hiperlink-urilor ctre o pagin sunt linkuri de

avizare atunci opinia colectiv va domina. n al doilea rnd, din interese comerciale evidente o

pagin autoritar nu va avea pe pagina proprie un link ctre rivali n acelai domeniu. n al treilea

rnd, paginile autoritare sunt rareori foarte descriptive.

Aceste proprieti ale structurii linkurilor conduce cercetarea la o alt categorie

important a paginilor web numit hub. Un hub este o pagin sau un set de pagini care

Stadiul actual n procesarea automat a documentelor de tip text

19

furnizeaz colecii de link-uri autoritare. Paginile hub pot fi chiar ele neimportante existnd

poate chiar puine link-uri care pointeaz ctre ele. Oricum, ele furnizeaz link-uri ctre site-uri

autoritare, avnd un subiect comun. Astfel de pagini pot fi liste de link-uri recomandate pe pagini

personale, liste de referine ale unui curs sau site-uri comerciale. n general, un hub bun este o

pagin cu link-uri ctre pagini autoritare de calitate.

2.3.3 Mineritul utilizrii web

Pe lng mineritul coninutului i structurii de legturi, un alt task important este

mineritul utilizri web-ului, care prelucreaz fiierele log pentru descoperirea pattern-urilor de

acces ale utilizatorilor la paginile web. Analizarea i exploatarea regularitilor n nregistrrile

de web log pot identifica poteniali clieni pentru comerul electronic, mrirea calitii i livrarea

serviciilor de informaii pe internet la utilizatorul final i mbuntirea performanei sistemelor

de servere de pe web.

Serverele web de obicei nregistreaz (n weblog) fiecare logare pentru fiecare acces la o

pagin web. Aceasta include URL-ul, adresa IP de la care a fost fcut cererea iniial i

tampila de timp a cererii. Bazele de date weblog furnizeaz informaii amnunite despre

dinamica web-ului. Pentru dezvoltarea tehnicilor de minerit pe weblog-uri acest aspect devine

foarte important.

n dezvoltarea tehnicilor pentru utilizarea mineritului pe weblog-uri, putem considera

urmtoarele: n primul rnd, este important ca datele din aceste fiiere de weblog s fie valide i

de ncredere. Adesea, datele din fiiere weblog trebuie s fie curate, condensate i transformate

ntr-o ordine pentru regsirea i analiza informaiilor semnificative i valoroase.

n al doilea rnd, avnd URL-urile disponibile, timpul, adresa IP i informaii despre

coninutul pagini web se poate realiza o selecie multidimensional iar cu ajutorul unei analize de

tip OLAP (OnLine Analytical Processing specifice masivelor de date) multidimensional se

pot determina N useri de top, numrul celor mai accesate pagini web, perioade de timp cu cele

mai multe accese i altele care pot ajuta de exemplu n descoperirea clienilor poteniali,

utilizatorilor, pieelor comerciale.

n al treilea rnd, data mining poate fi efectuat pe nregistrrile weblog pentru gsirea

pattern-urilor de asociere sau secveniale i tendine pentru accesul la web.

Datele weblog furnizeaz informaii despre acele grupuri de utilizatori acceseaz anumite

grupuri de pagini, informaiile weblog pot fi integrate cu coninutul web i structura de legturi

web pentru ajutorul mineritului paginilor, clasificarea documentelor web i construcia pe mai

multe niveluri a informaiilor de baz.

2.3.4 Construirea informaiilor de baz pe mai multe niveluri web

Deoarece o pagin de web conine totui, n afar de textul propriu-zis i metainformaii

despre pagina respectiv, ar fi interesant s se structureze informaiile de baz pe mai multe

niveluri pentru a vedea dac sunt realiste sau folositoare. Cel mai de jos nivel (cu cele mai multe

detalii) poate fi web-ul nsui. El nu poate fi separat n depozite. M voi referi la acest nivel ca

layer-0. Totui este nerealist s creezi depozite web coninnd copii a fiecrei pagini de pe web,

deoarece ar fi un duplicat al WWW.

Al doilea nivel pe care l voi numi n continuare layer-1 este nivelul de descriere al pagini

web, coninnd informaiile care descriu pagina web. Acesta ar trebui s fie mult mai mic dect

layer-0 dar suficient de bogat n prezentarea celor mai interesante informaii generale pentru

furnizarea cuvintelor cheie de baz, cutarea multidimensional sau minerit. Bazndu-ne pe

Stadiul actual n procesarea automat a documentelor de tip text

20

varietatea de pagini web, layer-1 poate fi organizat n diferite clase semistructurate cum ar fi:

documente, persoane, organizaii, vnzri etc.

Al treilea nivel, layer-2, reprezint nivelul de servicii WEB. Acestea pot fi cataloage web

construite deasupra nivelului, servicii specifice de aplicaie care pot utiliza limbajul WSDL (Web

Service Discovery Language) sau care pot utiliza protocoale mai simple cum ar fi SOAP (Simple

Object Access Protocol - este un protocol pentru schimbul de informaie structurat ntre servicii

WEB).

Utiliznd rangurile paginilor web date de motoare de cutare i algoritmi de clasificare a

paginii sau documentului putem obine informaii relevante de nalt calitate i pagini relevante

de pe web din construcia nivelului 1.

Standardizarea cu ajutorul XML-ului (eXtended Markup Language) va facilita schimbul

de informaii i extragerea informaiilor pentru construirea informaiilor de baz pe mai multe

nivele. n afar de asta, cutarea informaiilor de baz pe web i limbajele de descoperire a

cunotinelor pot fi create i implementate pentru astfel de scopuri. Web-ul semantic va avea ca

baz aceast standardizare la care se vor aduga diferite modele i limbaje de descriere a datelor

cum ar fi RDF (Resource Description Framework). RDF este un model standard pentru schimbul

de date pe Web. RDF are caracteristici care s faciliteze fuzionarea informaiilor, chiar dac

schemele care stau la baza acestor informaii sunt diferite i sprijin n mod specific evoluia

schemelor de-a lungul timpului fr a necesita la un moment data ca toate datele consumatorilor

s fie schimbate.

2.3.5 Clasificarea automat a documentelor web

Clasificarea automat a unui document web const n alocarea unei etichete de clas care

exist ntr-un set pre-clasificat De exemplu colecia DMOZ i documentele web asociate

anumitor categorii poate fi utilizat ca seturi de antrenament pentru obinerea schemei de

clasificare. Apoi dup ce s-a obinut schema de clasificare ea poate fi aplicat unor documente

web noi pentru a le clasifica corespunztor.

Metodele de clasificare a documentelor pe baza cuvintelor cheie au fost prezentate n

seciunea 2.2, aceste metode pot fi utilizate pentru clasificarea documentelor web. Astfel, scheme

de clasificare bazate pe termeni au dat rezultate bune pentru clasificarea documentelor web. Cu

toate acestea, deoarece o pagin web poate conine mai multe teme, publicitate i informaii de

navigare, analiza de coninut bazat pe blocuri de pagin poate juca un rol important n

construcia de modele de clasificare de nalt calitate. De vreme ce hiperlink-urile conin

informaii de nalt calitate din punct de vedere semantic n comparaie cu topicul paginii, este

indicat utilizarea i a unor astfel de informaii semantice pentru a obine o acuratee i mai bun

dect simplele clasificri bazate pe cuvinte cheie. Totui, link-urile care nconjoar un

document pot provoca zgomot iar folosirea simpl a termenilor din vecintatea de link-uri a

unui document poate chiar degrada acurateea.

n ultimii ani s-a intensificat activitatea de cercetare privind construcia i utilizarea web-

ului semantic; astfel informaia despre infrastructura web va structura la un nivel superior web-ul

care se va baza i pe sensul coninutului paginilor web. Clasificarea documentelor web prin web

mining va ajuta la extragerea automata a sensului semantic a paginilor web i la construirea

ontologiilor pentru web-ul semantic. Iar dac web-ul semantic se va construi cu succes, acesta va

ajuta foarte mult automatizarea clasificrii documentelor web.

Stadiul actual n procesarea automat a documentelor de tip text

21

2.4 Clustering vs. clasificare

n ultimii ani creterea semnificativ a utilizrii web-ului i mbuntirea calitii i

vitezei internetului au transformat societatea noastr ntr-una care depinde puternic de informaii.

Cantitatea uria de date care este generat de acest proces de comunicare conine informaii

importante care se acumuleaz zilnic n bazele de date i nu sunt uor de regsit. Domeniul

mineritului datelor (data mining) s-a dezvoltat ca un mijloc de extragere de informaii i

cunotine din baze de date pentru a descoperi modele sau concepte care nu sunt evidente.

Dup cum se menioneaz n [Berk06, Han01], nvarea automat ofer tehnici de baz

pentru data mining prin extragerea informaiilor din datele brute coninute n bazele de date.

Procesul de obicei este format din urmtoarele etape:

- transformarea datelor ntr-un format adecvat;

- curarea datelor;

- deducerea sau extragerea concluziilor cu privire la date.

nvarea automat este mprit n dou subdomenii principale: nvarea supervizat i

nvarea nesupervizat. n cadrul categoriei de nvare nesupervizat unul dintre instrumentele

principale este clusteringul datelor. Clasificarea datelor face parte din cel de al doilea

subdomeniu i anume nvarea supervizat.

2.4.1 nvare nesupervizat i supervizat

n scopul de a clarifica diferenele dintre clasificare i clustering voi face o scurt

prezentare a nvrii supervizate i nesupervizate. n nvarea supervizat algoritmul primete

att datele (vectorizate) ct i etichetele care reprezint conceptul de nvat, pentru fiecare caz.

Scopul nvrii supervizate este ca algoritmul s nvee conceptul, n sensul c, atunci cnd se

prezint un exemplu nou, pentru a fi clasificat, algoritmul ar trebui s prezic o etichet pentru

acest caz. Msura calitii clasificrii este dat de acurateea clasificrii.

n conformitate cu aceast paradigm, pe seturi relativ reduse de date exist posibilitatea

de overfitting sau pclire prin memorarea tuturor etichetelor pentru fiecare caz de ctre

algoritm, n detrimentul nvrii de ctre acesta a relaiilor generale predictive dintre valorile

atributelor i etichete.

Rezultatele nvrii supervizate sunt de obicei evaluate pe un set de exemple de test,

disjunct fa de setul de exemple de antrenare. Metodele de clasificare utilizate sunt foarte

variate, aria lor cuprinznd de la abordrile tradiionale statistice, reelele neuronale i pn la

algoritmi bazai pe nuclee precum SVM [Burg98].

n nvarea nesupervizat algoritmul primete doar date neetichetate iar sarcina

algoritmului este de a gsi o reprezentare adecvat a distribuiei datelor (gruparea n clusteri

relevani).

Unii cercettori au combinat nvarea supervizat cu cea nesupervizat i a aprut

conceptul de nvare semi-supervizat [Benn89]. De obicei, n acest tip de abordare nvarea

nesupervizat este aplicat iniial setului de date necunoscut n scopul de a face unele

presupuneri cu privire la distribuia datelor i apoi aceast ipotez este confirmat sau infirmat

printr-o abordare supervizat.

Stadiul actual n procesarea automat a documentelor de tip text

22

2.4.2 Clasificare i analiza clasificrii

Clasificarea automat de documente text este un aspect important n mineritul textului

deoarece, datorit existenei unui numr imens de documente on-line, este esenial gruparea n

mod automat a acestor documente n clase pentru a facilita regsirea de documente i analize

ulterioare.

Pentru a efectua clasificarea automat de documente text se parcurg cteva etape. n

primul rnd, un set de documente preclasificate este considerat ca fiind setul de antrenare. Setul

de antrenament este analizat pentru a obine schema de clasificare. Schema de clasificare apoi

trebuie s fie rafinat printr-un proces de testare. Schema de clasificare obinut astfel poate fi

aplicat la clasificarea celorlalte documente.

Acest proces pare oarecum similar cu clasificarea datelor din bazele de date relaionale.

Oricum exist o diferen fundamental. Datele relaionale sunt structurate: fiecare tuplu este

definit de un set de perechi atribut-valoare. Analiza clasificrii decide care seturi de perechi de

astfel de atribute are puterea de a determina dac sau nu se ntmpl ceva. Pe de alt parte,

seturile de documente nu sunt structurate pe perechi de tipul atribut-valoare. Un set de cuvinte-

cheie asociate cu un set de documente nu este organizat ntr-un set fix de atribute sau dimensiuni.

Dac considerm fiecare cuvnt-cheie distinct sau un atribut n document ca reprezentnd o

dimensiune, pot exista mii de dimensiuni ntr-un set de documente. Prin urmare, metodele de

clasificare frecvent utilizate n bazele de date de date relaionale, cum ar fi arbori de decizie, nu

pot fi eficace pentru clasificarea seturilor de documente text.

Voi aminti cteva metode tipice de clasificare care au fost folosite cu succes n

clasificarea documentelor text. Acestea includ clasificatorul k-NN (k-Nearest-Neighbor), metode

de selecie a trsturilor, clasificarea bayesian, clasificatori SVM (Support Vector Machine) i

clasificatori care utilizeaz clasificarea bazat pe asociere.

Conform modelului vectorial de reprezentare a documentelor VSM, dou documente sunt

similare n cazul n care vectorii care reprezint documentele sunt similari sau conin pri

similare. Clasificatorul k-Nearest-Neighbor face parte din categoria algoritmilor de clasificare

prin analogie i pleac de la premisa c documente similare vor primi aceeai etichet de clas.

Atunci cnd un document de testare este prezentat algoritmul l va trata ca pe o interogare la

sistemul recunoatere a informaiilor i va prelua din setul de antrenare cele k documente

reprezentative pentru cele k categorii existente, k fiind o constant dat. Eticheta de clas a

documentului de test poate fi determinat pe baza similaritii acestuia fat de unul din cele k

documente reprezentative i va fi etichetat cu eticheta documentului reprezentativ cel mai

similar. De aici provine i numele algoritmului k-Nearest-Neighbor. Aceast metod are nevoie

de resurse de memorie importante pentru a salva informaiile legate de antrenare n comparaie

cu alte tipuri de clasificatori.

Clasificarea bayesian este una din cele mai frecvent utilizate tehnici care pot fi utilizate

eficient pentru clasificare documentelor text. Deoarece clasificarea documentelor poate fi privit

ca o calculare a distribuiei statistice a documentelor n anumite clase, un clasificator Bayesian

calculeaz pentru setul de antrenament distribuia ( ) P d C a documentului d pentru fiecare clas

C i apoi n etapa de testare va genera pentru un document de test clasa cea mai probabil pe

baza distribuiei stabilite n etapa de antrenare. Deoarece aceast metod se poate aplica la seturi

de date n-dimensionale, ea poate fi folosit pentru clasificarea documentelor text.

Support Vector Machine (SVM) este un alt exemplu de clasificator care lucreaz eficient

cu seturi de date mari, neseparabile liniar, deci i cu documente text. Astfel, algoritmul

construiete o funcie de mapare direct ntre mulimea termenilor i variabilele de clas n etapa

de antrenare. Prin determinarea unui hiperplan de separaie a acestor puncte utilizate se

realizeaz gsirea claselor pentru documentele din setul de testare. Cnd nu e posibila gsirea

Stadiul actual n procesarea automat a documentelor de tip text

23

unui hiperplan de separare se trece la o dimensiune superioara de reprezentare etc. Ideea

esenial, care difereniaz SVM-ul de celelalte metode bazate pe nuclee, este aceea de a mapa,

atunci cnd este necesar, datele de antrenament, reprezentate ntr-un anumit spaiu, ntr-un alt

spaiu, de ordin superior prin intermediul unei funcii i de a construi un hiperplan optimal de

separare n acest nou spaiu. Aceast operaie conduce evident la o funcie de separare neliniar

n spaiul iniial de date. Deoarece toi vectorii apar n produse scalare utiliznd funcia nucleu

) ( ), ( x | | w , hiperplanul de separare poate fi determinat fr a proiecta explicit datele n noul

spaiu de trsturi. Am notat cu w vectorul pondere iar cu , produsul scalar a doi vectori.

Calculele sunt reduse semnificativ prin introducerea unui nucleu pozitiv definit k, astfel

ca ' , : ) ' , ( x x x x k = . Aceast substituire, care este referit uneori ca trucul nucleu. Deoarece toi

vectorii de trsturi apar doar n produse scalare poate fi aplicat trucul nucleu. Utiliznd funcia

reprezentm vectorii de intrare n noul spaiu. Pentru nuclee sunt folosii n principal nucleul

polinomial i nucleul Gaussian. Conform [Mora08] pentru nucleul polinomial singurul parametru

care trebuie modificat este gradul iar pentru nucleul Gaussian rmne de modificat parametru C

dup urmtoarele formule:

- Polinomial:

( )

d

x x d x x k ' 2 ) ' , ( + = (2.9)

- d fiind sigurul parametrul care trebuie modificat.

- Gaussian (radial basis function RBF):

|

|

.

|

\

|

=

C n

x x

x x k

2

'

exp ) ' , ( (2.10)

- n este numrul de elemente distincte care au ponderea mai mare ca 0 n vectorii

de intrare.

n formulele 2.9 i 2.10 x i x reprezint vectorii de intrare. Clasificatorul de tip SVM

este mai amnunit prezentat n seciunea 5.5.