Documente Academic

Documente Profesional

Documente Cultură

Functia Lui Rosenbrock

Încărcat de

ene_andreyDrepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Functia Lui Rosenbrock

Încărcat de

ene_andreyDrepturi de autor:

Formate disponibile

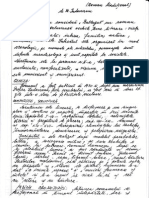

Andrei-Daniel Ene 321AA

Functia lui Rosenbrock

În optimizarea matematică , funcția Rosenbrock este o funcție non-convexa utilizata ca o

problemă de test de performanță pentru algoritmii de optimizare, introdusa de Howard H. Rosenbrock în

1960. De asemenea, este cunoscuta sub numele de Valea lui Rosenbrock sau Funcția banană a lui

Rosenbrock.

Valoarea minimă globala este intr-o vale lungă , îngustă , în formă de parabolă. Pentru a găsi valea

este banal. Dar cu toate acestea, este dificila convergerea la minimul global.

Forma generala a functiei este:

𝑁−1

𝑓(𝑥) = ∑ 100 ∙ (𝑥𝑖+1 − 𝑥𝑖2 )2 + (1 − 𝑥𝑖 )2

𝑖=1

unde x = [x1, …. , xN] ∈ RN.

Imaginea 3D a functiei pentru 2 variabile.

Tema 2 – Tehnici de Optimizare

1

Andrei-Daniel Ene 321AA

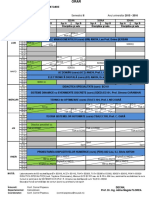

Valorile functiei pentru:

Pas ideal

Pas constant

Pas backtracking

Normele gradientilor pentru:

Pas ideal

Pas constant

Pas backtracking

Tema 2 – Tehnici de Optimizare

2

Andrei-Daniel Ene 321AA

Pentru metoda gradient voi folosi si urmatoarele functii implementate in MatLab:

function g = gradient(x) % am facut gradient doar pentru primele 10

variabile

g = [

200*(x(1)-x(2)^2);

200*(x(2)-x(3)^2);

200*(x(3)-x(4)^2);

200*(x(4)-x(5)^2);

200*(x(5)-x(6)^2);

200*(x(6)-x(7)^2);

200*(x(7)-x(8)^2);

200*(x(8)-x(9)^2);

200*(x(9)-x(10)^2);

400*x(10)*(x(9)-x(10)^2)+2*(1-x(10));

];

end

function obj = feval_obj(x)

obj = 0;

n = size(x);

for i=1:n-1

obj = obj + 100*(2*x(i+1) - x(i)^2)^2 + (1-x(i))^2;

end

end

function f = phi_obj(a,x,d)

f=feval_obj( x + a*d);

end

function xmin=metoda_gradient(x0,eps)

%initializam vectori/matrice pentru memorarea gradientilor,

%a punctelor x generate de algoritm, etc

obj = @(x) 100*(x(1) - x(2)^2)^2 + (1-x(2)^2)+100*(x(2) - x(3)^2)^2 + (1-

x(3)^2)+100*(x(3) - x(4)^2)^2 + (1-x(4)^2)+100*(x(4) - x(5)^2)^2 + (1-

x(5)^2)+100*(x(5) - x(6)^2)^2 + (1-x(6)^2)+100*(x(6) - x(7)^2)^2 + (1-

x(7)^2)+100*(x(7) - x(8)^2)^2 + (1-x(8)^2)+100*(x(8) - x(9)^2)^2 + (1-

x(9)^2)+100*(x(9) - x(10)^2)^2 + (1-x(10)^2);

puncte_gradient=[];

puncte_iteratie=[];

valori_functie=[];

norme_gradienti=[];

%vom utiliza un vector g pentru a stoca gradientul curent

x=x0;

g=gradient(x);

while(norm(g)>eps)

g=gradient(x);

norm(g)

puncte_gradient=[puncte_gradient g];

puncte_iteratie=[puncte_iteratie x];

valori_functie=[valori_functie; feval_obj(x)];

norme_gradienti=[norme_gradienti; norm(g)];

alpha=fminsearch(@(alpha) phi_obj(alpha,x,-g),x0);

x = x-alpha*g;

end

Tema 2 – Tehnici de Optimizare

3

Andrei-Daniel Ene 321AA

xmin=x

%Pentru afisarea grafica a rezultatelor, avem urmatoarele instructiuni

t=1:length(valori_functie);

figure(1)

hold on

plot(t,norme_gradienti(t),'k--','LineWidth',1);

hold off

figure(2)

hold on

plot(t,valori_functie(t),'k--','LineWidth',1);

hold off

end

Pentru varianta metodei gradient cu pasul determinat de metoda de backtracking, se poate

inlocui in codul de mai sus functia fminsearch cu urmatoarea functie:

function alpha=backtrack_alpha(x,d)

alpha=1; t1=0.9; t2 = 0.2

W=gradient(x);

%Va trebui satisfacuta conditia Armijo:

while(feval_obj(x+alpha*d)>feval_obj(x)+t1*alpha*W'*d)

alpha=alpha*t2;

end

end

Astfel codul pentru metoda gradient cu backtragking este:

function xmin=metoda_gradient_backtracking(x0,eps)

%initializam vectori/matrice pentru memorarea gradientilor,

%a punctelor x generate de algoritm, etc

obj = 0;

n = size(x0);

for i=1:n

obj = obj + 100*(x(i) - x(i+1)^2)^2 + (1-x(i+1)^2)

end

puncte_gradient=[];

puncte_iteratie=[];

valori_functie=[];

norme_gradienti=[];

%vom utiliza un vector g pentru a stoca gradientul curent

x=x0;

g=gradient(x);

while(norm(g)>eps)

g=gradient(x);

norm(g)

puncte_gradient=[puncte_gradient g];

puncte_iteratie=[puncte_iteratie x];

valori_functie=[valori_functie; feval_obj(x)];

norme_gradienti=[norme_gradienti; norm(g)];

alpha=backtrack_alpha(x,-g);

x = x-alpha*g;

end

xmin=x

Tema 2 – Tehnici de Optimizare

4

Andrei-Daniel Ene 321AA

%Pentru afisarea grafica a rezultatelor, avem urmatoarele instructiuni

t=1:length(valori_functie);

figure(1)

hold on

plot(t,norme_gradienti(t),'k--','LineWidth',1);

hold off

figure(2)

hold on

plot(t,valori_functie(t),'k--','LineWidth',1);

hold off

end

Bibliografie:

http://www.calpoly.edu/~aamendes/GTweb/LinearProgramming.pdf

https://en.wikipedia.org/wiki/Rosenbrock_function

http://www.mathworks.com/

Tema 2 – Tehnici de Optimizare

5

S-ar putea să vă placă și

- BacM2 TeorieDocument21 paginiBacM2 TeorieMihai Andrei Vizireanu100% (1)

- Derivate de Ordinul NDocument9 paginiDerivate de Ordinul NBogdan PisaiÎncă nu există evaluări

- Test - Algebra Clasa A Viii-A - Formule de Calcul PrescurtatDocument3 paginiTest - Algebra Clasa A Viii-A - Formule de Calcul PrescurtatTatiana Potinga BelostecinicÎncă nu există evaluări

- MatLab ExercitiiDocument6 paginiMatLab ExercitiiIulianÎncă nu există evaluări

- In Bratul TauDocument1 paginăIn Bratul Tauene_andreyÎncă nu există evaluări

- In Bratul TauDocument1 paginăIn Bratul Tauene_andreyÎncă nu există evaluări

- Divide Et Impera ApliDocument25 paginiDivide Et Impera ApliralucaÎncă nu există evaluări

- Integrale Si Ecuatii DiferentialeDocument51 paginiIntegrale Si Ecuatii DiferentialepixelshadesÎncă nu există evaluări

- Exercitii MATLABDocument63 paginiExercitii MATLABJustin PuscasuÎncă nu există evaluări

- Lab Matlab 2Document7 paginiLab Matlab 2mahallajrÎncă nu există evaluări

- TabsDocument23 paginiTabsene_andreyÎncă nu există evaluări

- Schita Proiect Livrare Cu DroneDocument2 paginiSchita Proiect Livrare Cu Droneene_andreyÎncă nu există evaluări

- Duritatea ApeiDocument3 paginiDuritatea Apeiene_andrey100% (2)

- Cap 3. Subprograme RecursiveDocument14 paginiCap 3. Subprograme RecursivebblonddÎncă nu există evaluări

- Integrarea Numerica A FunctiilorDocument8 paginiIntegrarea Numerica A FunctiilorDannyÎncă nu există evaluări

- Laborator 1 MecanicaDocument6 paginiLaborator 1 MecanicaHatyManagarmÎncă nu există evaluări

- Unitatea de Învățare 8Document9 paginiUnitatea de Învățare 8MihaelaÎncă nu există evaluări

- LL1 Prelucrarea SemnalelorDocument20 paginiLL1 Prelucrarea SemnalelorAnya MrÎncă nu există evaluări

- Aplicatiimatlab 3 DDocument135 paginiAplicatiimatlab 3 DMaria SolonaruÎncă nu există evaluări

- Raport Lab 1 Metode NumericeDocument8 paginiRaport Lab 1 Metode NumericeDutcovici RaduÎncă nu există evaluări

- FortranDocument83 paginiFortranGeorgian ComanÎncă nu există evaluări

- MAEDocument14 paginiMAEEden DaeosÎncă nu există evaluări

- Co1Document5 paginiCo1I LOVE MEÎncă nu există evaluări

- Cercetari Operationale Lucrarea de Laborator Nr.1: TEMA: Optimizarea NeconditionataDocument5 paginiCercetari Operationale Lucrarea de Laborator Nr.1: TEMA: Optimizarea NeconditionataConstantin RusuÎncă nu există evaluări

- Laborator Nr.1Document3 paginiLaborator Nr.1cojucari dumitruÎncă nu există evaluări

- Algebra Seminar1Document10 paginiAlgebra Seminar1Daniel RusuÎncă nu există evaluări

- Grile AnalizaDocument3 paginiGrile AnalizaCristina StefanescuÎncă nu există evaluări

- Matlab Lab3.1Document46 paginiMatlab Lab3.1Vlad ȘtefanÎncă nu există evaluări

- Matlab Lab4Document46 paginiMatlab Lab4Cezara Elena MachedonÎncă nu există evaluări

- Laborator 1 Cucu EugeniuDocument5 paginiLaborator 1 Cucu EugeniuCucu EugenÎncă nu există evaluări

- Fișă de Temă - 3.04.2020Document3 paginiFișă de Temă - 3.04.2020Cosmin BerechetÎncă nu există evaluări

- Laboratoare Sisteme de OperareDocument61 paginiLaboratoare Sisteme de OperareBogdan DanielÎncă nu există evaluări

- Lab 1 Var 14Document6 paginiLab 1 Var 14Mihai LipcanÎncă nu există evaluări

- Laborator 6-Modelare Si SimulareDocument3 paginiLaborator 6-Modelare Si SimulareTudor MunteanuÎncă nu există evaluări

- LucrarilaboratorDocument119 paginiLucrarilaboratorMantulescu MariusÎncă nu există evaluări

- Laborator Nr.112 PDFDocument4 paginiLaborator Nr.112 PDFcojucari dumitruÎncă nu există evaluări

- Proiect 3 - MatlabDocument11 paginiProiect 3 - MatlabVlad ȘtefanÎncă nu există evaluări

- Lucrare Nr.1 Mecanica UTMDocument3 paginiLucrare Nr.1 Mecanica UTMПарасийАлексÎncă nu există evaluări

- C4 MathcadDocument12 paginiC4 Mathcadviorelz13Încă nu există evaluări

- Matlab Curs3Document29 paginiMatlab Curs3Vlad ȘtefanÎncă nu există evaluări

- Lab 1 Var 10Document6 paginiLab 1 Var 10Mihai LipcanÎncă nu există evaluări

- Metoda GraficaDocument4 paginiMetoda GraficaWave ShockÎncă nu există evaluări

- Lucrare de Laborator Nr. 1Document4 paginiLucrare de Laborator Nr. 1Belîi DanielaÎncă nu există evaluări

- Lab 6 MTDocument14 paginiLab 6 MTAdrian CiorescoÎncă nu există evaluări

- Laboratorul nr3 (MN)Document8 paginiLaboratorul nr3 (MN)Negru TatianaÎncă nu există evaluări

- Programe ScilabDocument17 paginiPrograme ScilabsilvercristiÎncă nu există evaluări

- MN Cap2Document44 paginiMN Cap2Hilohe AdrianÎncă nu există evaluări

- Raport La InformaticaDocument12 paginiRaport La InformaticaIvan BychekÎncă nu există evaluări

- Laborator 12 - Integrarea Si Derivarea Numerica A FunctiilorDocument8 paginiLaborator 12 - Integrarea Si Derivarea Numerica A FunctiilorDanielCumpanaÎncă nu există evaluări

- Lab2 MN CR-212 V14Document8 paginiLab2 MN CR-212 V14Tabureanu MarianÎncă nu există evaluări

- Curs 9Document11 paginiCurs 9bigcrissmallÎncă nu există evaluări

- WafafgsDocument4 paginiWafafgsCS:GO cFGÎncă nu există evaluări

- Lucrarea NR 1 MATLABDocument5 paginiLucrarea NR 1 MATLABCrupa GrigoreÎncă nu există evaluări

- Derivarea NumericaDocument5 paginiDerivarea NumericaAndreeaÎncă nu există evaluări

- Proiect Optimizaari BiticaDocument13 paginiProiect Optimizaari BiticaDaniel IlăuÎncă nu există evaluări

- Lectia 3. Grafuri Neorientate. ConexitateDocument12 paginiLectia 3. Grafuri Neorientate. ConexitateNicu Vlad LaurentiuÎncă nu există evaluări

- Book Teste 2014Document184 paginiBook Teste 2014Florina NăstăsoiuÎncă nu există evaluări

- Sisteme de Conducere A FabricatieiDocument4 paginiSisteme de Conducere A Fabricatieiene_andreyÎncă nu există evaluări

- Indicatiile Reflexoterapiei in Disfunctii DigestiveDocument7 paginiIndicatiile Reflexoterapiei in Disfunctii Digestiveene_andreyÎncă nu există evaluări

- Proiect Proiectare - SchitaDocument4 paginiProiect Proiectare - Schitaene_andreyÎncă nu există evaluări

- Orar 2 AADocument1 paginăOrar 2 AAene_andreyÎncă nu există evaluări

- Lista Activitati - Plan de AfaceriDocument2 paginiLista Activitati - Plan de Afaceriene_andreyÎncă nu există evaluări

- Exemplu 1Document5 paginiExemplu 1ene_andreyÎncă nu există evaluări

- Poema ChiuveteiDocument6 paginiPoema Chiuveteiene_andreyÎncă nu există evaluări

- RomantismulDocument1 paginăRomantismulene_andreyÎncă nu există evaluări

- TX 32as600eDocument200 paginiTX 32as600esacopÎncă nu există evaluări

- Enigma OtilieiDocument8 paginiEnigma Otilieiene_andreyÎncă nu există evaluări

- BaltagulDocument6 paginiBaltagulene_andreyÎncă nu există evaluări

- Alexandru LapusneanulDocument7 paginiAlexandru Lapusneanulene_andreyÎncă nu există evaluări

- BaltagulDocument6 paginiBaltagulene_andreyÎncă nu există evaluări

- Aproape Totul Despre CafeaDocument51 paginiAproape Totul Despre CafeamnkÎncă nu există evaluări

- Moara Cu NorocDocument3 paginiMoara Cu Norocene_andreyÎncă nu există evaluări