Documente Academic

Documente Profesional

Documente Cultură

Analiza Cluster

Încărcat de

tancutaDrepturi de autor

Formate disponibile

Partajați acest document

Partajați sau inserați document

Vi se pare util acest document?

Este necorespunzător acest conținut?

Raportați acest documentDrepturi de autor:

Formate disponibile

Analiza Cluster

Încărcat de

tancutaDrepturi de autor:

Formate disponibile

Statistic multivariat

Lucrarea nr. 12 Clasificare - SPSS

A. Noiuni teoretice

Clasificare

Prin clasificare se nelege gruparea unor entiti (observaii, obiecte etc.) n

clase (grupuri) de entiti similare. Atunci cnd gruparea este efectuat manual, cel

care o efectueaz opereaz cu judeci de similaritate, asemnare, apropiere. Acest tip

de raionament este formalizat i n metodele automate.

Exist, n esen, dou tipuri de clasificare automat:

1. predictiv, de exemplu analiza discriminant; se asigneaz o observaie la

un grup pornind de la reguli de clasificare derivate din observaii

clasificate n prealabil. Se poate ca schema de clasificare existent s fie

subiectiv, neutilizabil efectiv, astfel nct metoda descoper aspectele

eseniale ale schemei i le transform n reguli practice.

2. descriptiv, de exemplu analiza cluster; se grupeaz obiectele pe baza

similaritii lor, nu este cunoscut o grupare prealabil.

Clasificare predictiv

Considerm cazul a dou populaii multivariate,

1

i

2

, fiecare caracterizat

de repartiiile diferitelor variabile msurate. Problema clasificrii revine la a stabili

populaia la care aparine o observaie u (caracterizat de valorile variabilelor

considerate).

Notnd cu S spaiul de eantionare (care cuprinde observaii din

1

i din

2

),

o regul de clasificare revine la a partiiona S n A

1

i A

2

, astfel nct pentru o

observaie u se poate dezvolta o procedur care decide

dac u A

1

, atunci u

1

dac u A

2

, atunci u

2

Clasificare predictiv - Fisher

Regula de clasificare a lui Fisher este bazat pe maximizarea separaiei dintre

cele dou populaii, n spiritul analizei varianei. Presupunem c populaiile univariate

au, respectiv, mediile

1

,

2

i dispersia comun

2

.

Este evident (intuitiv) c o observaie u va fi clasat n

1

dac u este mai

apropiat de

1

i n

2

daca este mai apropiat de

2

.

In cazul a dou populaii m-dimensionale, ideea lui Fisher a fost s transforme

observaia multidimensional u ntr-o observaie univariat y = a'u. Problema devine

atunci aceea de a determina combinaia liniar, definit de vectorul a, astfel nct cele

dou populaii s fie separate (difereniate) ct mai mult posibil. Se ajunge astfel, n

cazul general, la problema studiat n analiza discriminant. Aceast analiz ofer ca

rezultat i funciile de clasificare:

Fiecare subpopulaie,

i

, are asociat o funcie de clasificare f

i

astfel nct

observaia u este clasat n populaia

j

determinat prin

) ( max ) ( u u

i

i

j

f f =

Definim centrul unei clase (sau centroidul clasei) n mod uzual, ca punctul

avnd drept componente mediile aritmetice ale componentelor corespunztoare din

punctele clasei. Funciile de clasificare sunt estimate pe baza distanelor dintre o

observaie (valorile celor m variabile determin un punct n spaiul R

m

) i punctele

centrale, centroizii claselor. Distanele se pot calcula ca distane euclidiene, dar, din

pcate distana euclidian nu reflect proprietile distribuionale ale variabilelor:

variabile msurate pe scale diferite, de ordine de mrime diferite, pot afecta foarte

mult distanele euclidiene. Componentele cu variabilitate mare ar trebui s contribuie

cu ponderi mai mici dect cele cu variabilitate mic.

Pentru a considera i distribuiile variabilelor au fost definite distane noi, cea

mai utilizat fiind distana Mahalanobis: dac este matricea de covarian a celor m

variabile, adic = cov(x)=exp[(x-exp(x))(x-exp(x))] atunci distana Mahalanobis

ntre punctele x = (x

1

, , x

m

) i y = (y

1

, , y

m

) , este definit prin

y) (x ) y (x y x,

1

=

) ( d

i, corespunztor, se definete norma unui vector prin

x x' x x

1

= = ) 0 , ( d

.

Clasificare predictiv k vecini

Considerm situaia clasificrii propriu-zise, adic sunt cunoscute n obiecte

prin atributele lor, inclusiv apartenena la clasele

1

,

2

, ,

k

, i se dorete clasarea

unei noi observaii.

Un algoritm suficient de des utilizat este acela denumit al celor k vecini

(k - nearest neighbours).

1. Se determin k obiecte cele mai apropiate de noua observaie.

2. Aceste k obiecte stabilesc clasa noului obiect prin

Vot majoritar noul obiect este clasat n clasa la care aparin cei mai

muli dintre cei k vecini (care dispun fiecare de un vot ntreg).

Vot invers proporional distanei similar votului majoritar, dar fiecare

dintre cei k vecini apropiai dispune de o fraciune de vot, egal cu

inversul distanei la noul obiect (obiectele mai apropiate contribuie mai

mult la decizie).

Clasificare descriptiv

In analiza multivariat, clasificarea descriptiv (cluster analysis) se refer la

metodele utilizate pentru a identifica ntr-o mulime de obiecte grupurile de obiecte

similare. Cazurile de aplicare ale acestor metode sunt similare celor n care se

utilizeaz analiza factorial.

Datele sunt (sau pot fi) organizate ca un tablou (liniile sunt observaii, obiecte,

coloanele sunt variabile, atribute). In plus,

datele sunt omogene n sensul c are sens calculul distanelor dintre

elemente

exist suficient de multe date nct simpla inspecie vizual sau

prelucrrile statistice elementare nu ofer o imagine satisfctoare a

structurii datelor

tabloul de date este amorf: nu exist o structurare a priori (dependene

funcionale, relaii, clasificri cunoscute).

De remarcat c ultima caracteristic este cea care ne deprteaz de descrierea

predictiv (unde se presupunea existena unei structurri necesare n etapa de

training).

Drept rezultat al clasificrii descriptive se obin grupurile de elemente, clasele

identificate. Deoarece se pot aplica pe aceleai structuri de date, metodele clasificrii

descriptive sunt complementare metodelor analizei factoriale. De regul, atunci cnd

se utilizeaz mpreun, analiza factorial este efectuat mai nti, clasele evideniate

de aceasta fiind precizate, ierarhizate, localizate de clasificarea descriptiv.

Metodele de clasificare sunt de natur mai degrab algoritmic: clasele apar ca

urmare a unei suite de operaii efectuate recursiv sau repetitiv; matematica implicat

este relativ elementar.

Numim clas (grup, cluster) o mulime de obiecte (elemente) similare ntre

ele i nesimilare obiectelor din alte clase. Un cluster poate fi gndit (reprezentrile

grafice reflect aceste interpretri)

Ca o mulime de puncte care sunt apropiate (la distane mici) ntre ele i

deprtate de punctele din alte clase, sau

Ca o regiune conex dintr-un spaiu multidimensional care are o densitate

mare (relativ) de puncte, clusterele fiind separate ntre ele de regiuni cu o

densitate sczut (relativ) de puncte.

Rezult c problema esenial n determinarea (identificarea) clusterelor este

cea a specificrii proximitii (apropierii, similaritii) i cum se determin aceasta.

Este evident c proximitatea este o noiune dependent de problema real cercetat.

Structurile uzuale de date privind obiectele supuse analizei cluster sunt:

Matricea de pattern-uri. Este cazul obiectelor care sunt prezente prin

atributele lor n obiecte i p atribute vor furniza o matrice de tip np.

Liniile sunt obiecte (pattern-uri), coloanele sunt atribute (variabile).

Matricea de proximitate. Elementele d(i,j) reprezint proximitile dintre

obiectele i i j. Proximitatea poate fi

o similaritate (asemnare), cum ar fi coeficientul de corelaie, sau

o disociere (deprtare, difereniere), cum ar fi distana euclidian.

Atunci cnd atributele sunt de tipuri diferite (att discrete, ct i continue), se

poate calcula proximitatea dintre obiectele i i j prin

] 1 , 0 [ ) , (

1

) (

1

) ( ) (

=

=

=

f

i

f

ij

p

f

f

ij

f

ij

d

j i d

unde

) ( f

ij

este ponderea variabilei f

= = =

rest in 1

binara , asimetrica este si 0 0

lipsa sau pentru 0

) (

f x x

x x

jf if

jf if

f

ij

Menionm c

) ( f

ij

d este contribuia variabilei f la d(i,j) i anume:

- dac f este binar sau nominal, atunci

=

=

altfel 1

pentru 0

) ( jf if f

ij

x x

d

(Hamming)

- dac f este continu, atunci (normalizare prin amplitudine)

hf

h

hf

h

jf if

f

ij

x x

x x

d

min max

) (

=

- dac f este ordinal, se atribuie rangul r

if

, se calculeaz

1 max

1

=

hf

h

if

if

r

r

z

i se

consider c f este continu, avnd valorile z

if

.

Exist mai multe tipuri de algoritmi de clasificare:

- Algoritmi ascendeni (de agregare, de sintez) clasele sunt construite

prin agregarea succesiv a elementelor, se obine astfel o ierarhie de

partiii, de clase.

- Algoritmi descendeni (de divizare) mulimea obiectelor este divizat

succesiv n submulimi de obiecte din ce n ce mai omogene; se poate

obine i aici o ierarhie a partiiilor.

- Algoritmi de partiionare se pleac de la o partiie (structur de clase)

care se modific pentru a maximiza omogenitatea fiecrei clase.

Primele dou categorii pot fi reunite n clasificarea ierarhic (hierarchical

cluster analysis).

Clasificare descriptiv - agregare

Algoritmul fundamental de clasificare ascendent ierarhic este:

1. Etapa 0 exist cele n elemente care se clasific;

2. Etapa 1 se determin perechea de elemente cele mai apropiate ntre ele i

se produce, prin agregarea lor, un nou element;

3. Etapa 2 exist acum n-1 elemente care se clasific;

4. Se repet Etapa 1 i Etapa 2 pn cnd mulimea elementelor care se

clasific are un singur element.

Clasificare descriptiv - divizare

Metoda ierarhic descendent const n construirea ierarhiei n ordine invers:

1. Se pleac de la mulimea total a elementelor

2. La fiecare pas urmtor, cea mai mare (cea mai eterogen) grupare este

divizat n dou subgrupri.

3. Algoritmul se oprete atunci cnd toate grupurile constituite au cte un

singur element.

Pentru definirea grupului cel mai eterogen se utilizeaz diametrul grupului,

definit ca distana maxim dintre dou elemente din grup. Evident c se pot utiliza i

alte metode n acest scop.

Un algoritm ierarhic descendent este DIANA (Divisive ANAlysis):

1. Se determin obiectul cu cea mai mare distan medie fa de celelalte

obiecte (cea mai mare disociere). Este obiectul care iniiaz un nou cluster,

S (splinter group).

2. Pentru fiecare obiect i din afara grupului S

a. se calculeaz

) , ( ) , ( j i d j i d D

j j

i

media media

S S

=

b. Se determin un obiect h cu D

h

= max D

i

.

c. Dac D

h

este pozitiv, atunci obiectul h se adaug grupului splinter

(este mai apropiat, n medie, de elementele din S).

d. Se repet a) c) pn ce D

h

este negativ. Mulimea iniial este

acum divizat n dou clustere.

3. Se selecteaz clusterul cu cel mai mare diametru. Acesta este divizat prin

paii 1 2.

4. Se repet 3) pn cnd toate grupurile constituite au un singur element.

Exist o diagram sugestiv (diagram steag) pentru un algoritm descendent,

n care pe axa vertical sunt obiectele, pe axa orizontal se trec diametrele clusterelor.

Clasificare descriptiv - partiionare

Metodele de partiionare din analiza cluster au ca ideea esenial aceea c se

poate porni de la o partiie oarecare a mulimii de obiecte i se poate ajunge, prin

migrarea obiectelor ntre clase, la o partiie care ndeplinete un criteriu de optim.

Partiia final constituie structura de clustere cutat. De reinut, totui, faptul c nu

exist un criteriu de optim care s funcioneze oricnd i pentru orice obiecte.

Metodele de partiionare sunt utile atunci cnd exist un mare numr de

obiecte, caz n care dendrogramele nu mai pot fi interpretate (cteva sute de obiecte

produc o dendrogram de neneles).

Majoritatea metodelor au drept criteriu de optim obinerea partiiei care

minimizeaz suma ptratelor erorilor (apare la distana Ward). Eroarea este distana

de la un obiect la centrul clusterului su.

Un algoritm general de partiionare este:

1. Se selecteaz o partiie iniial cu k grupuri i se calculeaz centrele

clusterelor.

2. Se genereaz o nou partiie atribuind fiecare obiect la clusterul cu

centrul cel mai apropiat.

3. Se calculeaz noile centre ale clusterelor.

4. Se repet paii 2-3 pn se stabilizeaz clusterele sau nu se

mbuntete criteriul ales.

5. Se ajusteaz numrul de clustere prin reunirea sau divizarea unor

clustere sau prin eliminarea clusterelor aberante (cu un numr mic de

elemente).

6. Se repet paii 2-5 pn se stabilizeaz clusterele sau nu se

mbuntete funcia criteriu.

Elementele importante ale algoritmului sunt comentate n continuare.

Partiia iniial

O partiie iniial se poate obine selectnd k obiecte, considerndu-le centre i

grupnd n jurul fiecruia restul de obiecte (fiecare element va fi asociat centrului cel

mai apropiat). Nu se recalculeaz centrele dup fiecare clasificare a unui element.

Centroizii fiecrui cluster astfel format constituie centrele pentru pasul

urmtor.

Cele k obiecte iniiale se pot alege aleatoriu sau dup criterii oferite de o

analiz prealabil (clasificare ascendent, analiz n componente principale etc.).

Clusterele iniiale pot fi date de o clasificare ascendent, de exemplu. De reinut,

totui, c partiii iniiale diferite conduc la clustere finale diferite.

Algoritmii care se bazeaz pe criteriul minimizrii sumei de ptrate a erorilor

conduc la atingerea unui optim local, cel puin dac grupurile nu sunt bine

difereniate. Se poate depi acest neajuns repetnd clasificarea cu partiii iniiale

diferite.

Dac se ajunge la o aceeai partiie, atunci se mrete ncrederea c s-a

atins un optim global.

In caz c nu, se pot analiza subgrupurile stabile (elemente care sunt

mereu mpreun), care pot oferi informaii despre numrul de clustere.

Actualizarea partiiei

Exist mai multe moduri de abordare a pasului 2 din metoda general:

Atribuirea fiecrui obiect la clusterul cu centrul cel mai apropiat.

o Centrele se recalculeaz dup fiecare atribuire, sau

o Centrele se recalculeaz dup ce au fost procesate toate obiectele.

Atribuirea fiecrui obiect n fiecare cluster i evaluarea funciei criteriu.

Se reine partiia care reduce cel mai mult valoarea funciei criteriu. Se

ncearc astfel evitarea unui optim local.

Ajustarea partiiei

Se pot defini condiii pentru reducerea, sau extinderea numrului de clustere.

Se ncearc astfel atingerea unui numr natural de clustere, apropiat de gruparea

real, neinfluenat de perturbaii introduse n procesul de determinare a observaiilor

sau din alte cauze exterioare.

Algoritmul cel mai cunoscut este, n acest sens, ISODATA (Ball & Hall,

Jensen):

Clusterele sunt comasate dac au puine elemente (sub un prag fixat) sau

dac distana dintre centrele lor este mic (sub un prag fixat).

Un cluster este divizat dac dispersia elementelor (dup atributul cel mai

dispersat) depete un prag fixat i dac exist un numr suficient de

elemente (de exemplu, de dou ori mai multe dect numrul minim).

Este de remarcat c existena valorilor aberante poate denatura procesul de

clusterizare. Din acest motiv, anumii autori recomand excluderea obiectelor

aberante (i chiar a celor din clusterele cu puine elemente).

Convergena

Dei nu se garanteaz atingerea unui optim global, algoritmul se oprete atunci

cnd funcia criteriu nu mai poate fi mbuntit, sau n anumite variante cnd

partiia nu se modific n dou iteraii succesive.

Demonstraii matematice ale convergenei au fost bazate

fie pe formularea problemei ca o problem de programare matematic,

fie pe artarea faptului c de la o iteraie la alta se mrete variana

interclase i se micoreaz variana intraclase, ceea ce dat fiind

finitudinea mulimii de obiecte produce oprirea procesului.

Clasificare descriptiv metode fuzzy

In afar de metodele deterministe, au fost dezvoltate i metode de clasificare

fuzzy. Intr-o metod fuzzy se obin, pentru fiecare obiect, probabilitile ca obiectul s

aparin la fiecare dintre clustere.

De exemplu, o metod fuzzy, similar metodei de partiionare, este metoda

celor c medii (fuzzy c-means), bazat pe minimizarea funciei obiectiv

= =

=

n

i

c

j

j i

m

ij m

c x d u J

1 1

2

) , (

unde

n - numrul de obiecte, c numrul de clustere,

m R , m > 1 este parametru (uzual este 2),

c

j

, j = 1c sunt centrele clusterelor, d este o distan de similaritate, u

ij

este

gradul de apartenen al lui i la clusterul j.

Rezultatul este coninut n matricea de apartenen (u

ij

) care ofer

probabilitile apartenenei elementelor la clase.

Partiionarea fuzzy se realizeaz iterativ (optimiznd implicit funcia obiectiv)

prin actualizarea la fiecare pas a matricei de apartenen (u

ij

) i a centrelor clusterelor

(c

j

)

|

|

.

|

\

|

=

c

l

m

l i

j i

ij

c x d

c x d

u

1

1

1

2

2

) , (

) , (

1

=

=

=

n

i

m

ij

n

i

i

m

ij

j

u

x u

c

1

1

Procesul se oprete atunci cnd matricea de apartenen se stabilizeaz:

<

+ ) ( ) 1 (

,

max

k

ij

k

ij

j i

u u

unde (0, 1) are semnificaia uzual n procese iterative similare.

Distane ntre obiecte

n continuare sunt prezentate metodele uzuale de calculare a distanelor dintre

obiecte (elemente sau grupuri deja constituite). Alegerea unei anumite distane

modific gruprile care se constituie.

Metoda celui mai apropiat vecin (nearest neighbor method)

Distana dintre dou grupuri este distana minim dintre dou elemente ale

grupurilor (distana dintre cele mai apropiate elemente din clase diferite)

( ) ) , ( min ,

2 1

,

2 1

y x d

y x

= d

n imaginea urmtoare se exemplific, prin numerotarea 1 6 ordinea de

atribuire a elementelor respective la grupurile figurate n extremiti. Astfel, un lan de

obiecte apropiate dou cte dou este atribuit, de regul, la un singur grup, ceea ce nu

produce o grupare acceptabil.

Metoda celui mai deprtat vecin (farthest neighbor method)

Aceast metod utilizeaz calcularea distanei dintre dou grupuri drept

distana maxim dintre dou elemente ale grupurilor (distana dintre cele mai

deprtate elemente din clase diferite)

( ) ) , ( max ,

2 1

,

2 1

y x d

y x

= d

Metoda are avantajul c nu aglomereaz grupuri legate printr-un lan. n

imaginea alturat se poate vedea ordinea de atribuire 1 6 a elementelor

corespunztoare la cele dou grupuri extreme. Gruparea obinut corespunde mai bine

i gruprii intuitive (efectuat de un operator uman).

Metoda legturii medii

Distana dintre dou grupuri este distana medie dintre perechile de elemente

ale grupurilor

( )

=

1 2

) , (

1

,

2 1

2 1

x y

y x d

n n

d

Metoda distanei centrelor (average group linkage)

Se consider, ca distan dintre dou grupuri

1

i

2

, distana dintre centrele

grupurilor

( ) ) , ( ,

2 1

2 1

G G d = d

unde centrele G

1

i G

2

au drept componente mediile aritmetice ale componentelor

elementelor din cele dou grupuri, respectiv.

De remarcat c centrul unui grup este dinamic, fiecare nou element putnd

produce deplasarea lui. Centrul unui grup format dintr-un singur element este chiar

acel element.

Metoda distanei Ward (Ward's linkage)

Distana Ward este bazat pe creterea suma de ptrate a erorilor dup

contopirea grupurilor ntr-unul singur. Metoda Ward selecteaz gruprile care

minimizeaz creterea sumei de ptrate a erorilor.

( ) ( ) ) ( ) ( ) ( ,

) (

2 1 2 1 2 1

2

SP SP SP

x x SP

x

+ =

=

d

Dendrograma

Ca rezultat al algoritmului se obine arborele de clasificare (dendrograma).

Prin secionarea orizontal a dendrogramei se obine o partiie a mulimii

elementelor clasificate. Componentele partiiei sunt clasele cutate.

n figura alturat este prezentat o dendogram. Pe axa orizontal sunt

elementele iniiale (ordinea este cea care permite desenarea arborelui). Pe axa

vertical sunt distanele dintre obiecte, de exemplu, ntre obiectele 4 i 6 este o

distan egal cu 4.

Calitatea clasificrii

Deoarece ntr-o problem de clusterizare nu se cunoate nimic a priori

(numrul de clase n special), evaluarea calitii partiiei obinute este o etap foarte

important. Evaluarea trebuie s ia n considerare att faptul c, poate, mulimea

iniial nu are o structur bine determinat de clase, ct i faptul c diferite metode

conduc la clase diferite.

Procedurile uzuale de evaluare:

Vizualizarea partiiei (dendrograme, profiluri, proiecii).

Indicatori de calitate

o Coeficienii de divizare (divisive coefficient DC) i de aglomerare

(agglomerative coefficient AC) care ofer indicatori (medii)

globali.

o Indici de siluet (Silhouette) care se pot defini att global, ct i

local pentru fiecare cluster.

Divisive Coefficient (DC): Pentru fiecare obiect i, se calculeaz d(i) ca fiind

raportul dintre diametrul ultimului cluster (n ordinea dat de algoritmul de divizare)

la care a aparinut obiectul nainte de a fi separat ca un singleton i diametrul mulimii

totale de obiecte (clusterul iniial). Atunci

= ) (

1

i d

n

DC

Agglomerative coefficient (AC) este un indice de calitate pentru clasificarea

ascendent: Pentru fiecare obiect i, se calculeaz d(i) ca fiind raportul dintre

disocierea primului cluster (n ordinea dat de algoritm) la care se ataeaz obiectul i

diametrul mulimii totale de obiecte (clusterul final).

| |

= ) ( 1

1

i d

n

AC

AC tinde s creasc o dat cu numrul de obiecte.

Silueta se calculeaz (Rousseeuw, 1987) ca silueta unui obiect, silueta medie a

unui cluster, silueta medie global. Acest indice vrea s reprezinte ct de bine este

separat un cluster de vecinii si (deci ct de apropiate sunt elementele dintr-un cluster

distana intra-cluster i ct de deprtate sunt de celelalte clustere distana inter-

clustere).

Prin calculul siluetei se poate decide asupra validitii unui cluster, ca i

asupra numrului corect de clustere.

Notnd cu S (i) silueta obiectului i, formula de calcul este

} , max{

) (

i i

i i

b a

a b

i S

=

unde a

i

disocierea medie a obiectului i fa de restul obiectelor din acelai cluster;

b

i

disocierea medie a obiectului i fa de obiectele din cel mai apropiat cluster (al

doilea candidat pentru includerea obiectului i).

Dac obiectul i este singurul element al unui cluster, atunci

S (i) = 0.

Rezult c -1 S (i) 1 i S (i) poate fi considerat ca un indice adimensional,

cu putere de comparare. Interpretarea este

Dac S (i) este apropiat de 1, atunci obiectul este bine clasificat (este

asociat cu clusterul adecvat).

Dac S (i) este aproape nul, atunci obiectul poate fi clasificat i n

urmtorul cluster apropiat (obiectul este situat similar n raport cu ambele

clustere)

Dac S (i) este apropiat de 1, atunci obiectul este clasificat eronat (el este

separat fa de celelalte clustere).

Fiecare cluster este caracterizat de silueta medie, obinut ca media siluetelor

elementelor din cluster.

Intreaga structur de clustere este caracterizat de silueta medie global,

obinut ca media siluetelor S(i) dup toate obiectele i. Dac structura conine un

numr k de clustere, se noteaz silueta medie global cu S

k

. Silueta medie global se

poate utiliza pentru a decide asupra celui mai bun numr de clustere: se va alege

acel k pentru care S

k

este maxim.

Se introduce coeficientul siluet prin

k

k

S SC max =

Este propus (Rousseeuw - 1987) urmtoarea interpretare a coeficientului

siluet dup valoarea sa:

0.71 - 1.00 s-a determinat o structur puternic (bine definit) de

clustere;

0.51 - 0.70 s-a determinat o structur acceptabil

0.26 - 0.50 structura determinat este slab, poate fi artificial

0.25 structura determinat este artificial.

B. Instrumente SPSS

Procedurile care rezolv probleme de clasificare sunt grupate n Analyze

Classify. Dintre ele se prezint n continuare K-Means Cluster care urmrete metoda

general prezentat n curs i Hierarchical Cluster pentru clasificarea ierarhic. De

menionat c dei algoritmul K-Means este cel mai direct i mai eficient ca volum de

calcule, el utilizeaz distana euclidian iar standardizarea prealabil a variabilelor

este important. Pentru considerarea altor distane se va apela procedura Hierarchical

Cluster.

K-Means Cluster

Algoritmul const n fixarea iniial aleatorie a centrelor claselor (numrul de

clase este cunoscut) i apoi se repet etapele:

atribuirea fiecrui caz la centrul cel mai apropiat,

actualizarea centrelor ca valori medii ale elementelor aparinnd clasei

respective.

Ca interpretare se poate considera c centrul unei clase finale reflect

caracteristicile unui element tipic al clasei prin valorile variabilelor n acel centru.

Prin Analize Classify K-Means Cluster se deschide dialogul

n lista Variables se vor trece variabilele n funcie de care se face clasificarea.

Se poate utiliza o variabil pentru etichetarea cazurilor prin specificarea ei n Label

Cases by. Numrul de clustere se poate fixa n Number of Clusters. O ghicire a

numrului de clustere poate fi obinut aplicnd n prealabil ACP i studiind

diagramele proieciilor pe planele factoriale. Ca metod se poate alege

Iterate and classify pentru a realiza o adaptare iterativ a clasificrii cazurilor prin

recalcularea centrelor dup fiecare iteraie. Dac se dorete utilizarea rezultatelor

i pentru clasificarea altor cazurii, informaiile se vor salva ntr-un fiier prin

selectarea opiunii Write final as din grupul Cluster Centers.

Classify only pentru realizarea clasificrii cazurilor atunci cnd se citesc dintr-un

fiier centrele claselor, calculate n prealabil i salvate. n acest caz se va selecta,

din zona Cluster Centers, Read initial from i se va preciza File, fiierul salvat

ntr-o prelucrare anterioar.

Prin acionarea butonului Iterate din dialogul principal, buton permis doar

pentru metoda Iterate and classify, se deschide dialogul sinonim.

n Maximum Iterations se fixeaz limita numrului de

iteraii, cel mult 999. Valoarea dat n Convergence

Criterion reprezint o proporie p din distana minim dintre

centrele iniiale, deci poate fi ntre 0 i 1. Procesul iterativ se

oprete dac niciun centru recalculat nu este deplasat cu mai

mult de 100p% din distana minim dintre centrele iniiale iteraiei.

Prin selectarea opiunii Use running means se cere

recalcularea centrelor la fiecare clasare a unui caz i nu dup

clasarea tuturor cazurilor.

Acionarea butonului Save din dialogul principal

deschide dialogul prin care se poate cere salvarea unor

informaii ca noi variabile.

Cluster membership se salveaz ca valori 1 k apartenena la clusterele

finale. Distance from cluster center salveaz distana euclidian dintre caz i centrul

clasei la care aparine.

Prin dialogul Options, afiat la acionarea butonului Options din dialogul

principal, se pot preciza statisticile calculate i modul de tratare a datelor lips.

n grupul Statistics:

Initial cluster centers prima estimare a centrelor,

obinut prin alegerea unui numr de cazuri egal cu

numrul de clustere.

ANOVA table se afieaz tabelul ANOVA pentru

fiecare variabil, considernd clusterele drept

factor. Valorile F mari vor arta variabilele care

contribuie cel mai mult la structura clusterelor.

Cluster information for each case afieaz asignrile finale la clase, distana la

centrul clasei ca i distanele euclidiene dintre centrele finale.

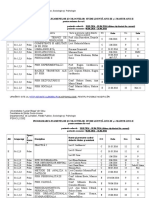

Rezultatele SPSS n cazul K-Means Cluster

Ieirea depinde de opiunile selectate n dialogurile procedurii, tabelele listate

n cazul (aproape) complet sunt prezentate n continuare. S-a realizat o clasificare

ilustrativ utiliznd fiierul SPSS de test Employee Data.

Centrele iniiale ale claselor sunt alese aleatoriu, attea cte clustere sunt

indicate n dialogul principal. Se prezint coordonatele centrelor n spaiul

variabilelor.

Modificrile survenite n timpul procesului iterativ sunt sistematizate n

tabloul urmtor, prezentndu-se modificrile aprute n coordonatele centrelor.

Centrele claselor finale sunt afiate ntr-un tabel similar celui care arat

centrele iniiale:

O verificare mai mult orientativ asupra separrii clusterelor dup fiecare

variabil considerat este coninut n tabelul ANOVA:

Cum nsi procesul de clasificare urmrete o ct mai bun difereniere a

clusterelor, toate testele F duc la respingerea ipotezei de egalitate a mediilor

clusterelor. Se poate ns interpreta comparativ valoarea statisticii F n sensul c

variabilele care au asociate valori mai mari asigur o difereniere mai pronunat.

Un tabel final arat cte elemente sunt clasificate n fiecare cluster.

Apartenena observaiilor (cazurilor) la clustere i distana pn la centrul

clasei sunt create ca noi variabile cu denumiri implicite, dup modelul

Informaiile salvate pot fi utilizate, n afara scopului propus de a cunoate

unde aparine fiecare observaie, i pentru ilustrarea clasificrii prin diagrama de

forma urmtoare, n care se poate observa modul de difereniere a claselor dup

diverse variabile (comanda a fost Graph - Scatter - Simple Scatter i s-a precizat

noua variabil Cluster Number n Set Markers by).

Hierarchical Cluster

Algoritmul pleac de la clustere coninnd un singur element (cazurile) i

reunete clustere pn cnd se obine un singur cluster. Se pot selecta mai multe

distane, se afieaz statistici la fiecare pas pentru a ajuta la selectarea numrului

optim de clustere.

Comanda este Analyze Classify Hierarchical Cluster care produce

afiarea dialogului principal.

Analiza se poate efectua pentru cazuri, sau pentru variabile, potrivit opiunii

selectate n grupul Cluster. Variabilele reprezentnd caracteristicile dup care are loc

clasificarea sau care se clasific se trec n lista Variables i se poate alege o variabil

de etichetare a cazurilor (la clasificarea cazurilor) util n reprezentrile grafice.

Grupul Display controleaz ce se afieaz, deci accesibilitatea la butoanele Statistics,

Plots. Dialogurile secundare sunt explicate n continuare.

Statistics

Agglomeration schedule se afieaz

combinaiile din fiecare iteraie, distane etc.

Proximity matrix se afieaz distanele sau

similaritile dintre elemente. Cluster Membership

produce afiarea apartenenei la clustere n una sau

mai multe iteraii.

Plots

Diagramele de aglomerare sunt disponibile n

formatul

Dendrogram (dendrograma explicat in curs,

orientat spre vizualizarea clusterelor) sau

Icicle (similar diagramei steag, orientat spre

vizualizarea cazurilor).

Orientarea diagramei poate fi vertical sau

orizontal. n reprezentarea dendrogramei, distanele

dintre elementele care se unesc sunt transformate pe o

scal 0 25, cu pstrarea raportului distanelor.

Method

n lista Cluster Method se poate alege una dintre metodele explicate n curs ca

metode de agregare, de calculare a distanelor dintre clustere: cel mai apropiat vecin

(nearest neighbor), cel mai deprtat vecin

(furthest neighbor), distana fa de centru

(centroid clustering), Ward etc.

n grupul Measure se poate specifica

distana sau similaritatea utilizat n grupare

potrivit tipului de date:

Interval pentru datele continue sunt

disponibile distanele: euclidian, cosinus

(cosinusul unghiului dintre vectorii

punctelor), corelaia Pearson, Chebychev

(diferena absolut maxim dintre valorile

elementelor), block (suma diferenelor

absolute dintre componente, distana Manhattan), Minkowski (rdcina de ordin p

din suma diferenelor absolute la puterea p), Customized (similar cu distana

Minkowski, dar rdcina poate fi de ordin r diferit de puterea p a diferenelor de

coordonate)

Count pentru frecvene (de date discrete) sunt disponibile msurile de disociere

2

i

2

(a se vedea seciunea privind asocierea datelor nominale).

Binary pentru datele dihotomice exist o mulime de distane propuse, bazate pe

tabelul de frecvene ncruciate a celor dou variabile. Se pot preciza valorile

interpretate ca 0 sau 1.

n grupurile Transform Values i Transform Measures se pot selecta metode

de transformare prealabil a valorilor astfel nct variabilele s fie ct mai omogen

msurate.

Save

Se poate salva, sau nu, ca variabile noi,

apartenena la clustere. Selectarea opiunii Single

solution i precizarea numrului de clustere

considerat ca soluie final va salva apartenena la

acel stadiu.

Dac se selecteaz Range of solutions, se va

salva apartenena la fiecare stadiu dintre cele

menionate.

C. Lucrarea practic

1) Setul de date aflat la adresa www.infoiasi.ro/~val/statistica/EuropeanProtein.txt

conine consumul de proteine n 25 de ri europene. Datele se refer la anul 1973.

Sunt msurate urmtoarele variabile: Country - numele rii, RdMeat - carne roie,

WhMeat - carne alb, Eggs - ou, Milk - lapte, Fish - pete, Cereal - cereale,

Starch - grsimi, Nuts - oleaginoase, Fr&Veg - fructe, vegetale.

a) s se realizeze o analiz factorial pentru a stabili numrul de clase n care pot

fi grupate cele 25 de ri

b) s se realizeze o clasificare a celor 25 de ri; s se studieze concordana cu

situaia observat la punctul a).

2) Datele acestei probleme sunt cele prelucrate i n lucrarea numrul 11,

www.infoiasi.ro/~val/statistica/EuropeanJobs.txt. Reamintim variabilele: Country

numele rii, Agr procentajul de muncitori din agrucultur, Min procentajul

de muncitori din minerit, Man procentajul de muncitori din industria

prelucrtoare, PS procentajul de muncitori din industria energetic, Con

procentajul de muncitori din construcii, SI procentajul de muncitori din

servicii, Fin procentajul de muncitori din finane, SPS procentajul de

muncitori din servicii sociale, TC procentajul de muncitori din transporturi i

comunicaii.

a) s se aplice un algoritm de clasificare ierarhic

b) s se aplice algoritmul k-means pentru k = 4; s se compare cu rezultatul

clasificrii realizate la a).

S-ar putea să vă placă și

- Scalare MultidimensionalaDocument15 paginiScalare MultidimensionalaJennifer ParkerÎncă nu există evaluări

- Cercetarea CalitativaDocument41 paginiCercetarea Calitativadaniela.bobocea8340Încă nu există evaluări

- Format LicentaDocument10 paginiFormat LicentaRobert NeghinaÎncă nu există evaluări

- Greier PracticaDocument16 paginiGreier PracticaDana GrerosuÎncă nu există evaluări

- Regresia LiniaraDocument30 paginiRegresia LiniaraFilip CristinescuÎncă nu există evaluări

- Indicatori Statistici Ai DispersieiDocument14 paginiIndicatori Statistici Ai DispersieiGeorgiana OlteanuÎncă nu există evaluări

- Validitatea Și Fidelitatea Testului MBTIDocument4 paginiValiditatea Și Fidelitatea Testului MBTIOana RusuÎncă nu există evaluări

- Metodologie Psihologica. Strategii Si Metode de Cercetare.Document110 paginiMetodologie Psihologica. Strategii Si Metode de Cercetare.kalinda05Încă nu există evaluări

- Rusu CercetareaDocument14 paginiRusu CercetareaProfa BiolÎncă nu există evaluări

- C 5 - Formularea Ipotezelor de CercetareDocument14 paginiC 5 - Formularea Ipotezelor de CercetareAlexandra Puiu100% (1)

- Extras - Manual de Practica in Domeniul Reintegrarii Sociale Si SupravegheriiDocument121 paginiExtras - Manual de Practica in Domeniul Reintegrarii Sociale Si SupravegheriiStephen Joyner100% (1)

- Curs Metodologia Cercetarii-Curs 2Document25 paginiCurs Metodologia Cercetarii-Curs 2Curecheriu Miluta IonelaÎncă nu există evaluări

- Analiza FactorialaDocument5 paginiAnaliza FactorialaAlina-Roxana DogaruÎncă nu există evaluări

- Tipuri de VariabileDocument7 paginiTipuri de VariabileAlexandru AlinÎncă nu există evaluări

- Lectia 8 SPSSDocument34 paginiLectia 8 SPSSIulia Mati100% (2)

- Sem-Curs 4Document4 paginiSem-Curs 4Alexandra MartinÎncă nu există evaluări

- Analiza Preliminara DateDocument43 paginiAnaliza Preliminara DateGeorge Iulian PanaitÎncă nu există evaluări

- Articol StiintificDocument22 paginiArticol StiintificAmelia AlexandraÎncă nu există evaluări

- Referat SPSSDocument73 paginiReferat SPSSDaniel NegruÎncă nu există evaluări

- Teste StatisticeDocument5 paginiTeste StatisticePoenaru Alexandra-Georgiana100% (1)

- Programare Vara PSIHOLOGIE 2016Document3 paginiProgramare Vara PSIHOLOGIE 2016ramona_psiÎncă nu există evaluări

- Competente Si ValoriDocument7 paginiCompetente Si ValoriChamomile MarrieÎncă nu există evaluări

- Coeficientul de Corelatie PearsonDocument11 paginiCoeficientul de Corelatie PearsonAura DorobantuÎncă nu există evaluări

- Bazele Evaluarii Psihologice TesteDocument13 paginiBazele Evaluarii Psihologice TesteRoua LoredanaÎncă nu există evaluări

- Proiect Etica Si DeontologieDocument12 paginiProiect Etica Si DeontologieLazar Iulia100% (1)

- Desfasurarea Functiei CalitatiiDocument2 paginiDesfasurarea Functiei CalitatiiOlga MuşinschiÎncă nu există evaluări

- Calcul Scor TotalDocument2 paginiCalcul Scor TotalMarcel MarzaÎncă nu există evaluări

- Analiza FactorialaDocument37 paginiAnaliza Factorialalestat stephyÎncă nu există evaluări

- Regresie Si Corelatie - StatisticaDocument12 paginiRegresie Si Corelatie - StatisticamarytzamariaÎncă nu există evaluări

- Curriculum Vitae Si Lista Lucrari MIHAELA STOICADocument15 paginiCurriculum Vitae Si Lista Lucrari MIHAELA STOICAEnna MagdaÎncă nu există evaluări

- Diagnoza Organizationala - Prezentarea Cursului - CerinteREFERATE - 2022 - 2023Document2 paginiDiagnoza Organizationala - Prezentarea Cursului - CerinteREFERATE - 2022 - 2023Dumitrache MarianaÎncă nu există evaluări

- Analize MultivariateDocument26 paginiAnalize Multivariatekaty kttyÎncă nu există evaluări

- Referat Psiho SocialaDocument16 paginiReferat Psiho SocialaAllen WheelerÎncă nu există evaluări

- Erori de EvaluareDocument1 paginăErori de EvaluarePiu TanaseÎncă nu există evaluări

- Bibliografie, Curs Toxico-DependentaDocument1 paginăBibliografie, Curs Toxico-Dependentaasistentasociala2011Încă nu există evaluări

- Analiza DatelorDocument80 paginiAnaliza Datelorcriss890100% (1)

- Proiect Individual. Competentele Consultantului OrganizationalDocument6 paginiProiect Individual. Competentele Consultantului Organizationalsica100% (1)

- Metodologia Cercetarii - Analiza Cantitativa PDFDocument52 paginiMetodologia Cercetarii - Analiza Cantitativa PDFDaniela SerbanicaÎncă nu există evaluări

- Regresie Multipla-Adrian DusaDocument25 paginiRegresie Multipla-Adrian DusaCatiusa IziumovÎncă nu există evaluări

- Metodele ParametriceDocument16 paginiMetodele ParametriceM. RomanÎncă nu există evaluări

- Statistic ADocument31 paginiStatistic Acosmian27Încă nu există evaluări

- Strategii de Pozitionare Utilizate in Marketingul StrategicDocument4 paginiStrategii de Pozitionare Utilizate in Marketingul Strategicliv880Încă nu există evaluări

- Analiza Cluster IMPORTANTDocument15 paginiAnaliza Cluster IMPORTANTCatalin CrisanÎncă nu există evaluări

- Teorie TDM v2Document6 paginiTeorie TDM v2Bogdan AdmÎncă nu există evaluări

- Analiza Clusterala A DatelorDocument14 paginiAnaliza Clusterala A DatelorChristine Banciu0% (1)

- Grupare Clasificare FuzzyDocument22 paginiGrupare Clasificare FuzzyElvis BoghiuÎncă nu există evaluări

- ACP TeorieDocument11 paginiACP TeorieCatalin CrisanÎncă nu există evaluări

- Analiza ClusterDocument22 paginiAnaliza ClusterRoxana C. LiviaÎncă nu există evaluări

- Curs 8Document22 paginiCurs 8Andrei CostinÎncă nu există evaluări

- Curs 1 SIA Exemplu1 Algoritm ClasificareDocument7 paginiCurs 1 SIA Exemplu1 Algoritm ClasificareMihai RaduÎncă nu există evaluări

- Analiza ClusterDocument7 paginiAnaliza ClusterInes AndrasiÎncă nu există evaluări

- L8 - Metode de Clustering A Datelor MicroarrayDocument8 paginiL8 - Metode de Clustering A Datelor MicroarraysimosimonaÎncă nu există evaluări

- Algoritmi de ClasificareDocument6 paginiAlgoritmi de Clasificareion1848Încă nu există evaluări

- Analiza ClusterDocument2 paginiAnaliza ClusterAde AdriiÎncă nu există evaluări

- Data Mining În Afaceri: - NotițeDocument32 paginiData Mining În Afaceri: - NotițeGEORGIANA-DENISA SAMOILA100% (1)

- Glosar Termeni StatisticaDocument6 paginiGlosar Termeni StatisticaMisu MisulicaÎncă nu există evaluări

- Metode de Invatare SupervizataDocument15 paginiMetode de Invatare SupervizataanadeeaÎncă nu există evaluări

- 57 Babucea Ana-GabrielahDocument6 pagini57 Babucea Ana-GabrielahLori MGÎncă nu există evaluări

- Modele Explicative Uzuale PDFDocument50 paginiModele Explicative Uzuale PDFDe Bona VirgilÎncă nu există evaluări

- Analiza Componentelor PrincipaleDocument16 paginiAnaliza Componentelor Principalesimona100% (1)